英伟达发布最强 AI 芯片 B200,性能提升 30 倍,该产品有哪些特性?对 AI 领域意味着什么?

- 14 个点赞 👍被审核的答案

只懂洋人坚船利炮,不懂洋人为什么坚船利炮。 以为靠某为去搞搞洋务了,就能和诸国宣战了? “中国本质上没有历史,只有不断的重复”——黑格尔!

查看全文>>

天马座的幻想 - 10 个点赞 👍被审核的答案

不管意味着什么跟咱中国没关系 世界高端局,为下一次工业革命准备,中国只能继续当个看客

查看全文>>

九山之滨 - 8 个点赞 👍被审核的答案

这几年 才只是刚刚闭关 各种新的科技迭代和突破如雨后春笋般 虽然目前可以靠网评员的键盘来缩短距离 但很快 随着科技不断的飞速发展 以后大概率会出现对现代科技出现认知断层 而且可能会很快到来

查看全文>>

Diablo - 222 个点赞 👍

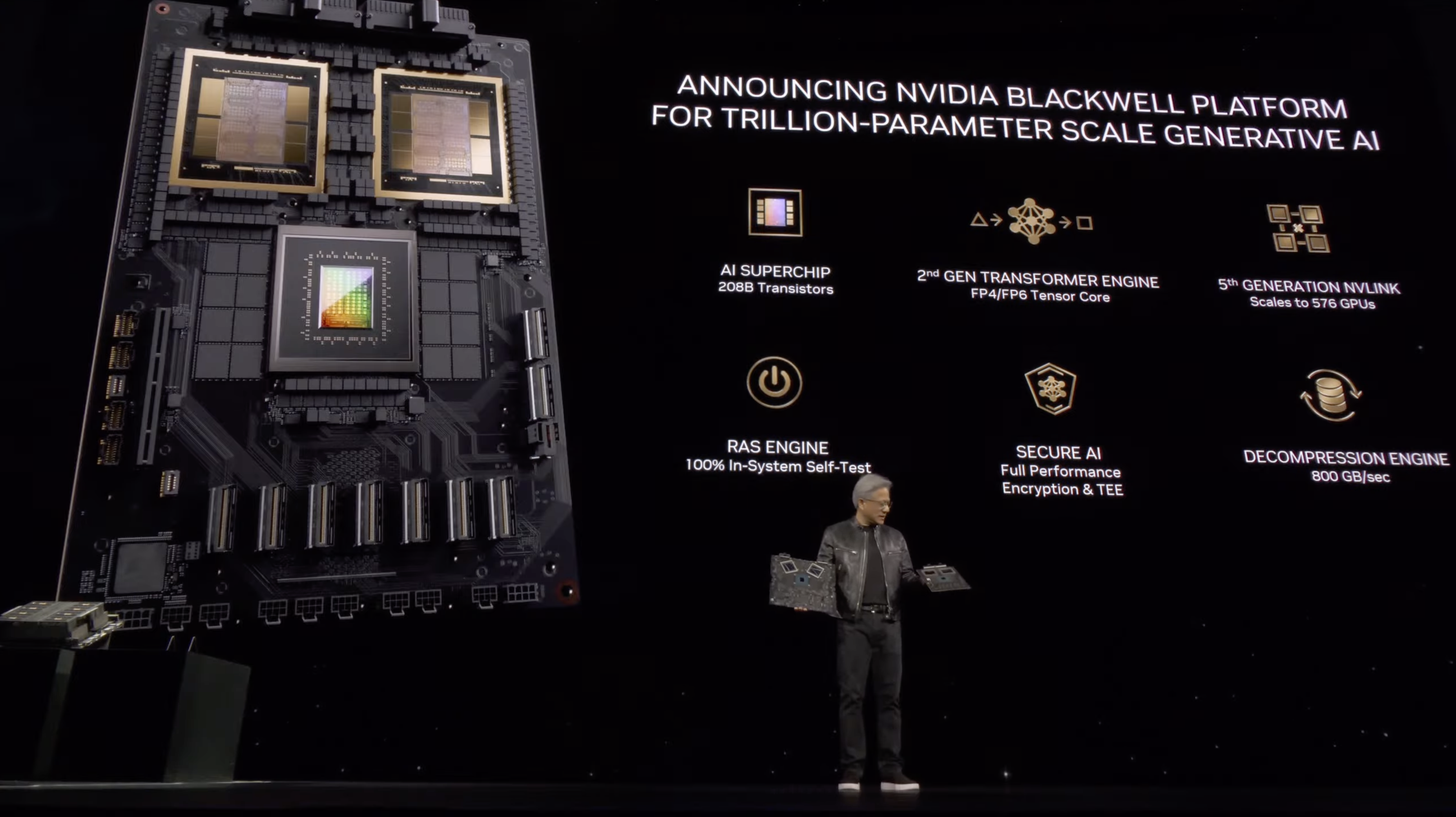

Blackwell B200 GPU,是如今世界上最强大的AI芯片,旨在「普惠万亿参数的AI」。

本来,H100已经使英伟达成为价值数万亿美元的公司,赶超了谷歌和亚马逊,但现在,凭着Blackwell B200和GB200,英伟达的领先优势还要继续领先。

老黄表示——「H100很好,但我们需要更大的GPU」!

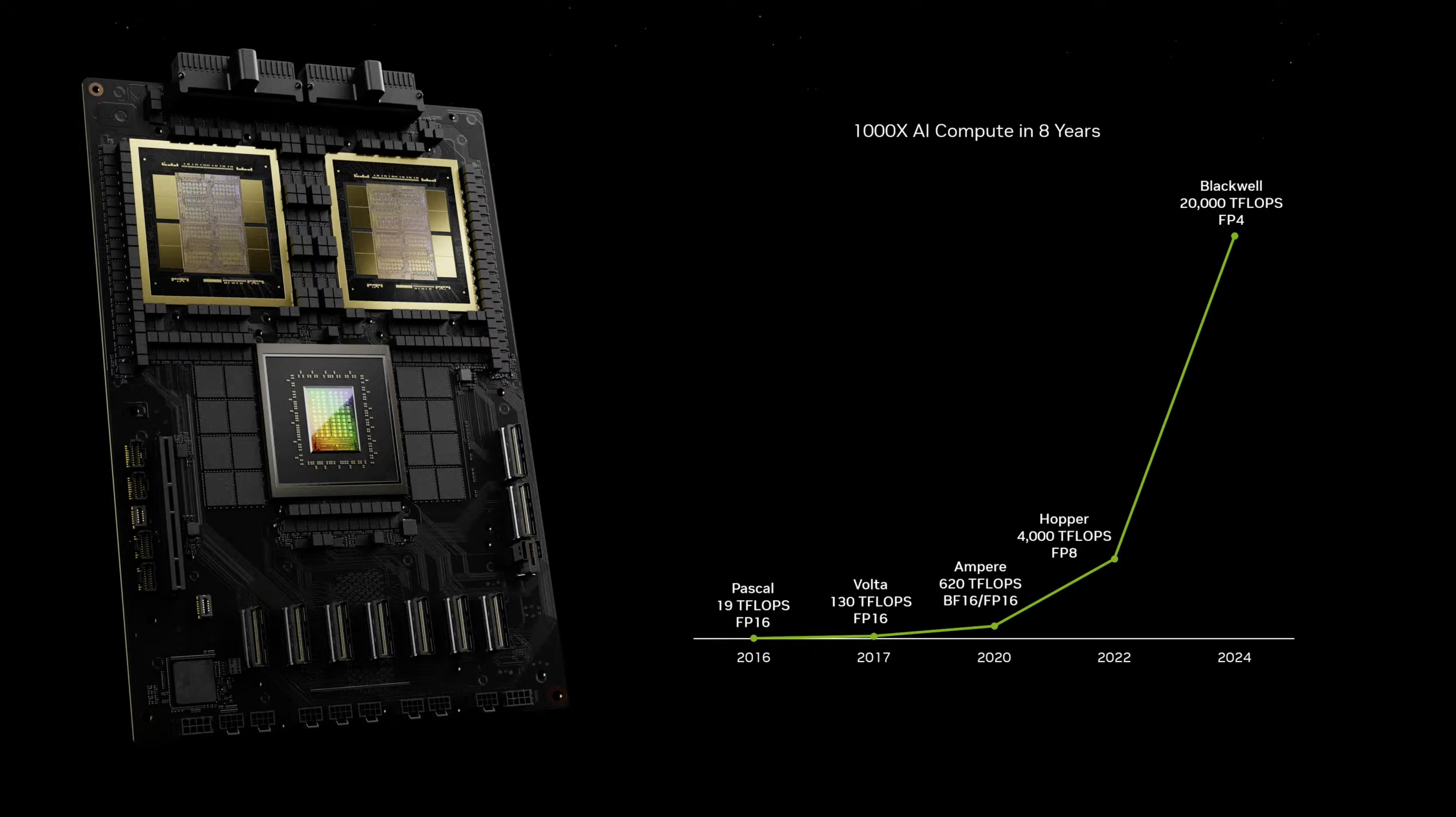

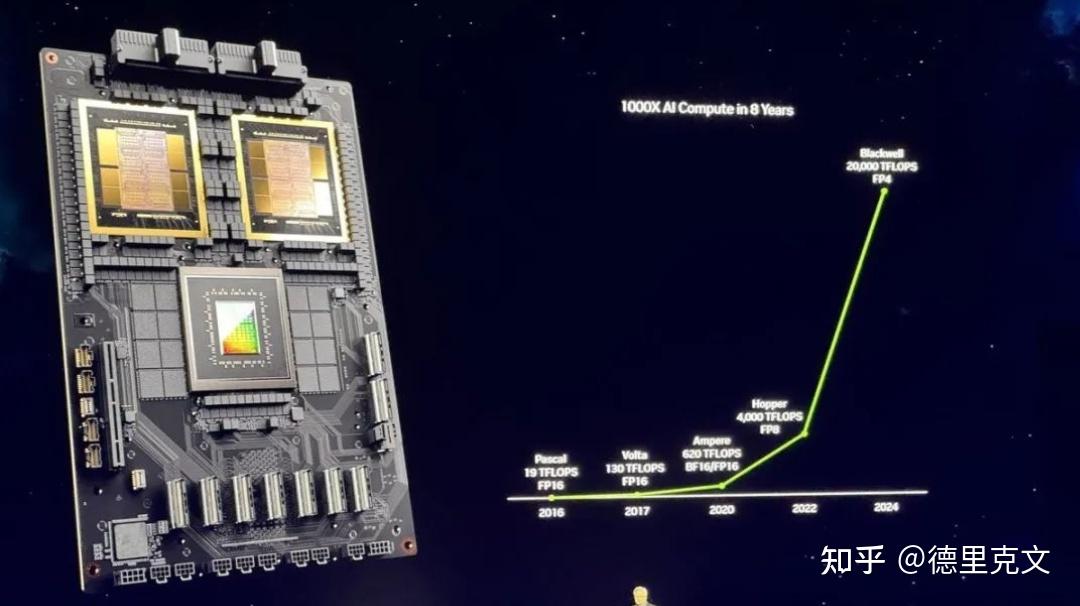

新的B200 GPU,从2080亿个晶体管中能提供高达20 petaflops的FP4性能。(H100仅为4 petaflops)

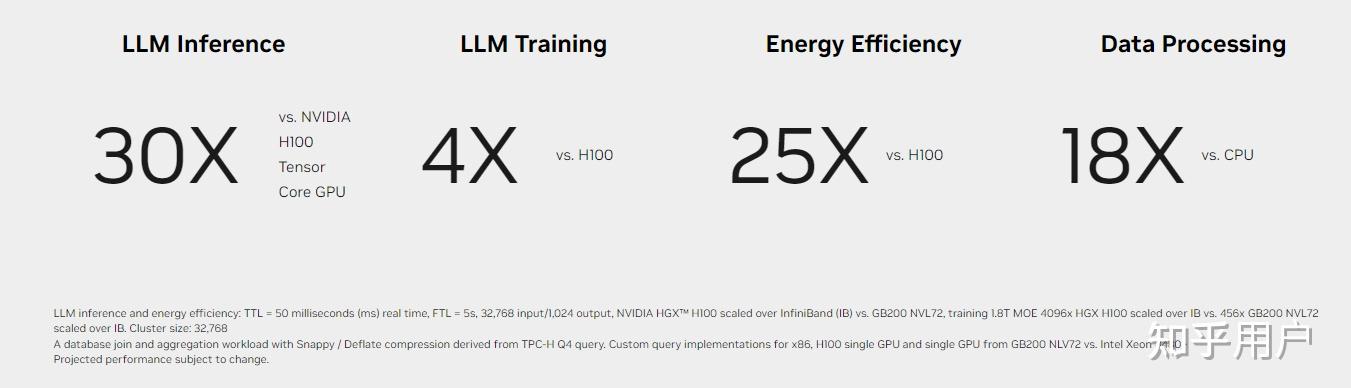

而将两个B200与单个Grace CPU相结合的GB200,则可以为LLM推理工作负载提供30倍的性能,同时大大提高效率。

比起H100,GB200的成本和能耗降低了25倍!

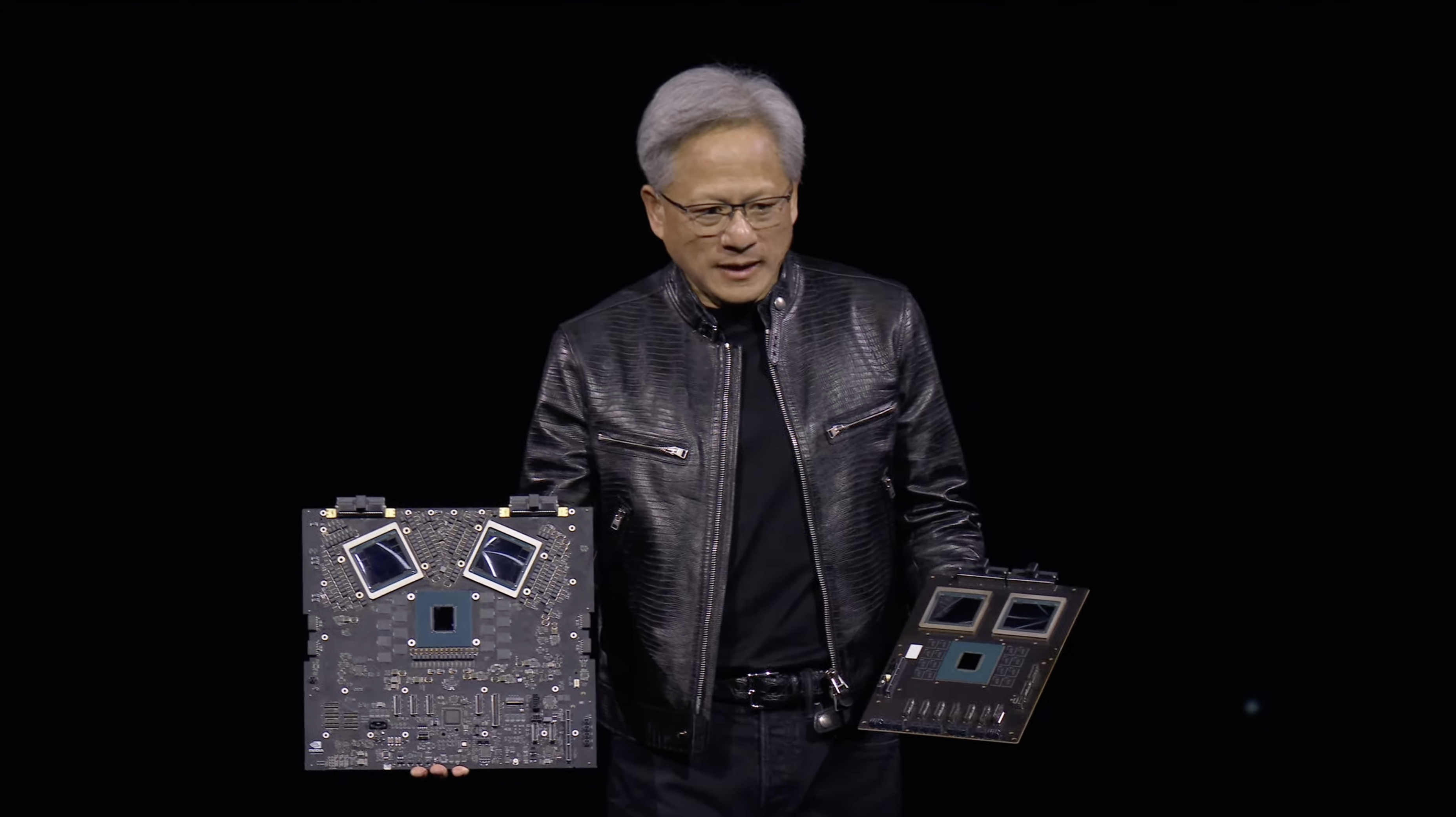

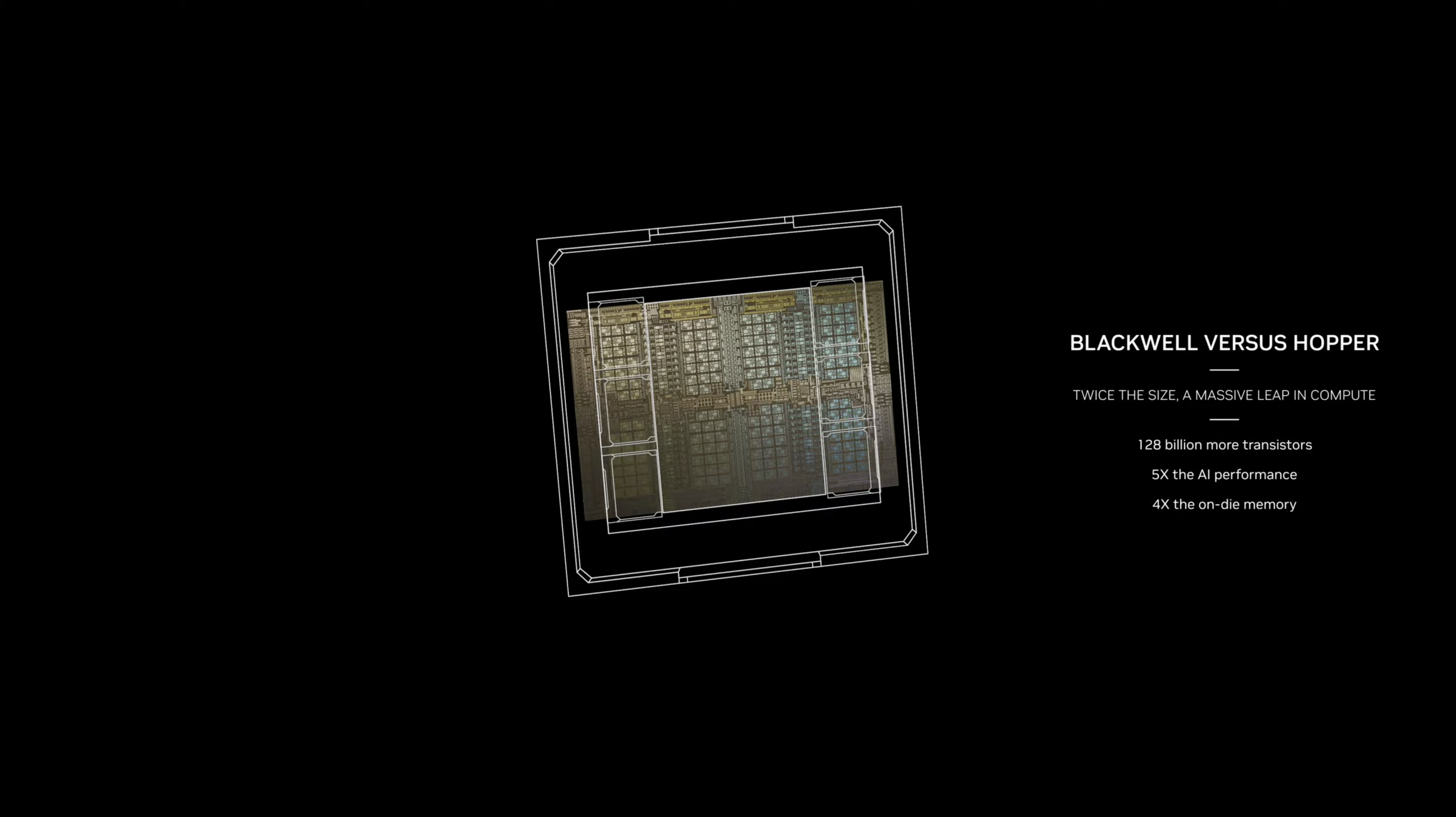

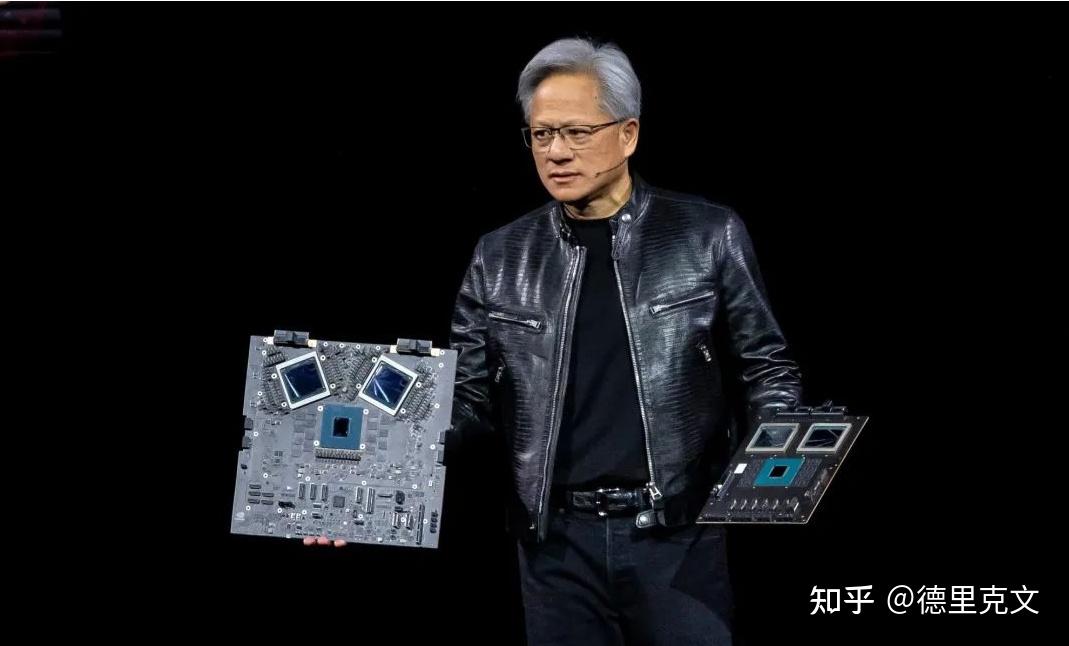

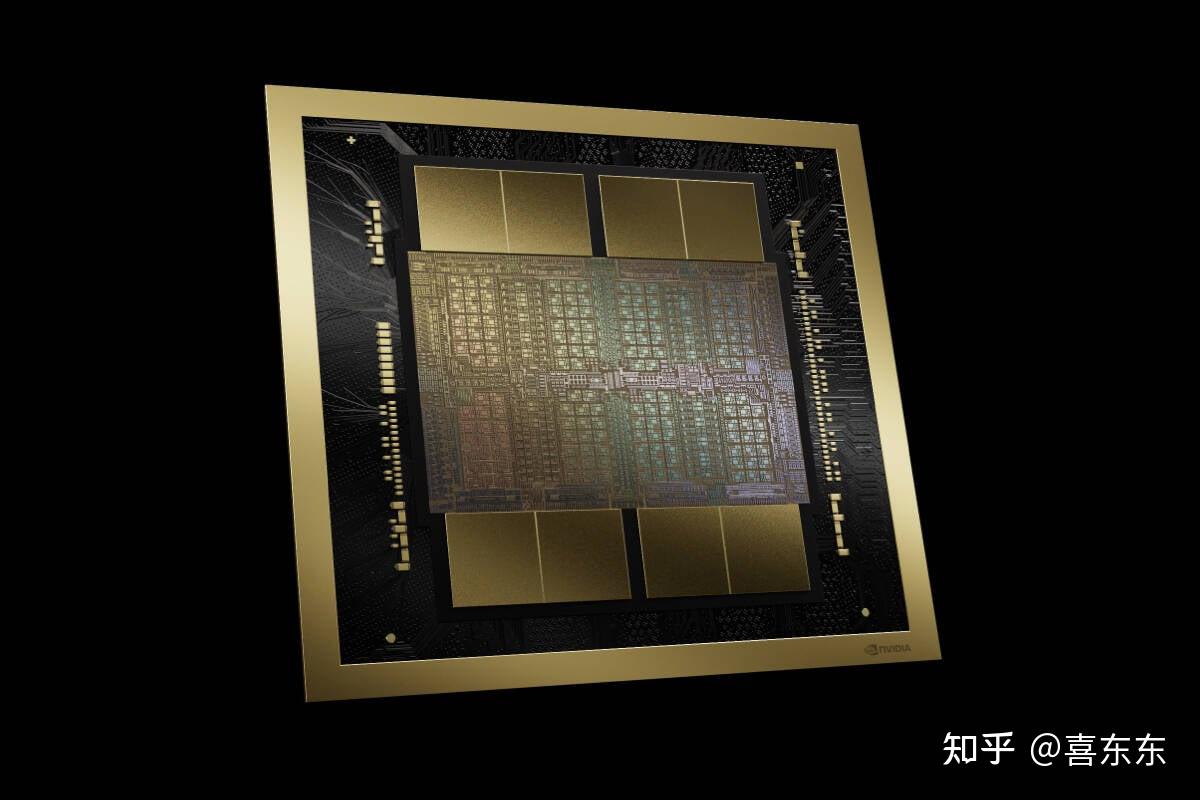

Blackwell芯片和Hopper H100芯片的尺寸比较

这种额外的处理能力,就能让AI公司训练更大、更复杂的模型,甚至可以部署一个27万亿参数的模型。

更大的参数,更多的数据,未来的AI模型,无疑会解锁更多新功能,涌现出更多新的能力。

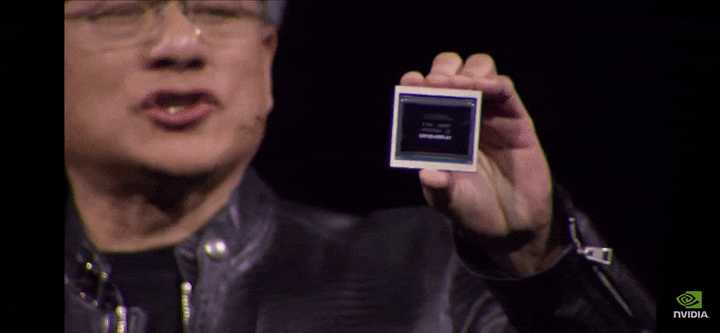

现在,老黄拿在手里的,或许是100亿美元。

新一代性能巨兽,深夜重磅登场

凭借H100成为全球市值第三大公司的英伟达,今天再次推出了性能野兽——Blackwell B200 GPU和GB200「超级芯片」。

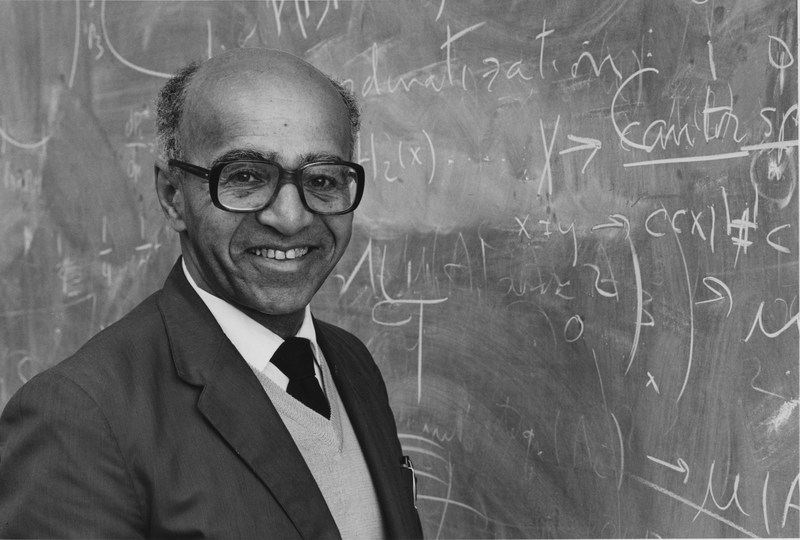

它以著名数学家David Blackwell(1919-2010)命名。他一生中对博弈论、概率论做出了重要的贡献。

老黄表示,「30年来,我们一直在追求加速计算,目标是实现深度学习和AI等变革性突破。生成式AI已然成为我们这个时代的标志性技术,而Blackwell将是推动这场新工业革命的引擎」。

「我们认为这是个完美的博弈概率」。

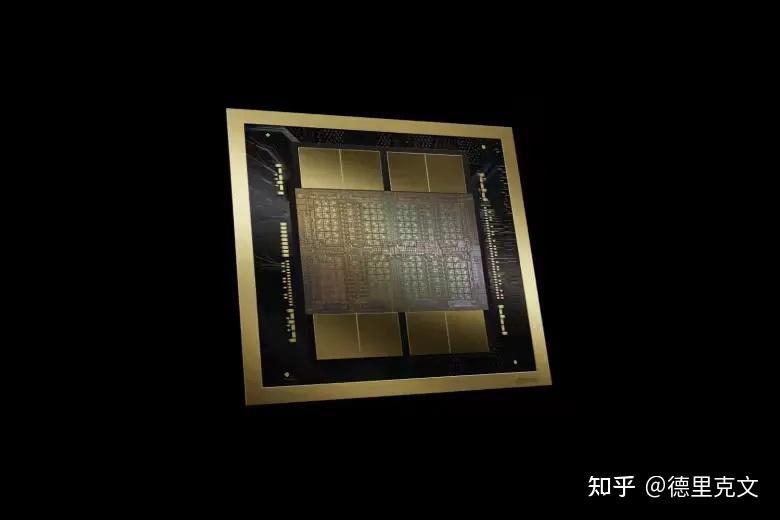

全新B200 GPU拥有2080亿个晶体管,采用台积电4NP工艺节点,提供高达20 petaflops FP4的算力。

与H100相比,B200的晶体管数量是其(800亿)2倍多。而单个H100最多提供4 petaflops算力,直接实现了5倍性能提升。

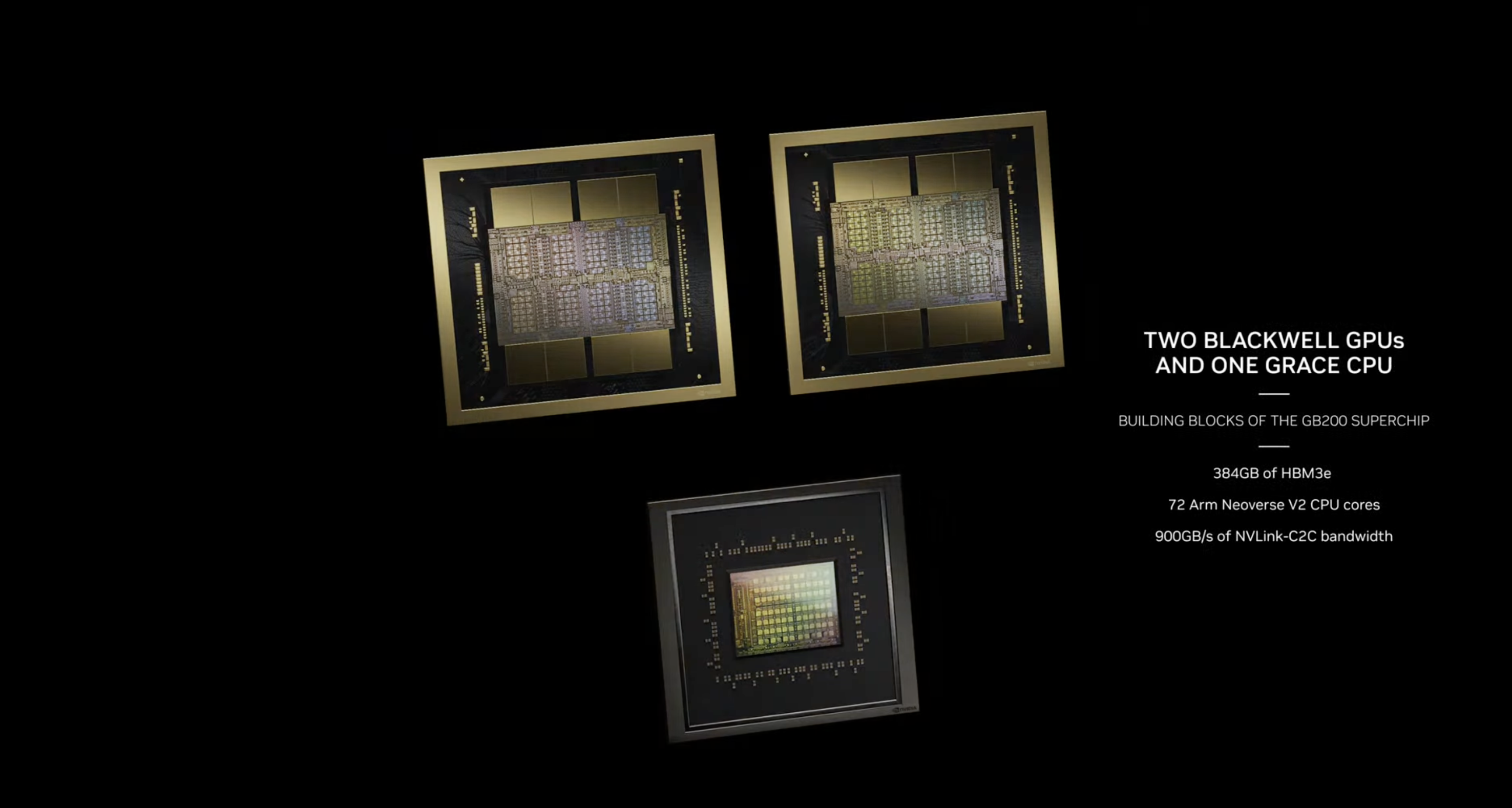

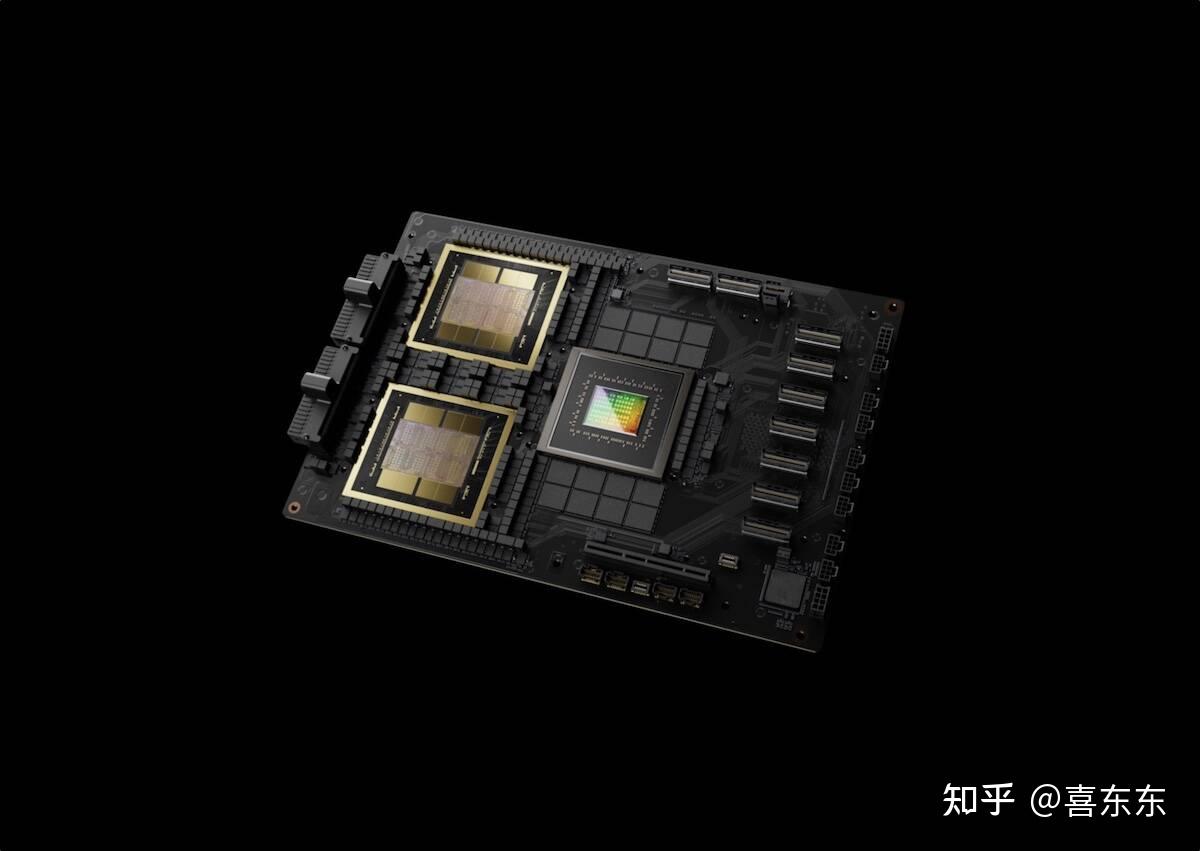

而GB200是将2个Blackwell GPU和1个Grace CPU结合在一起,能够为LLM推理工作负载提供30倍性能,同时还可以大大提高效率。

值得一提的是,与H100相比,它的成本和能耗「最多可降低25倍」。

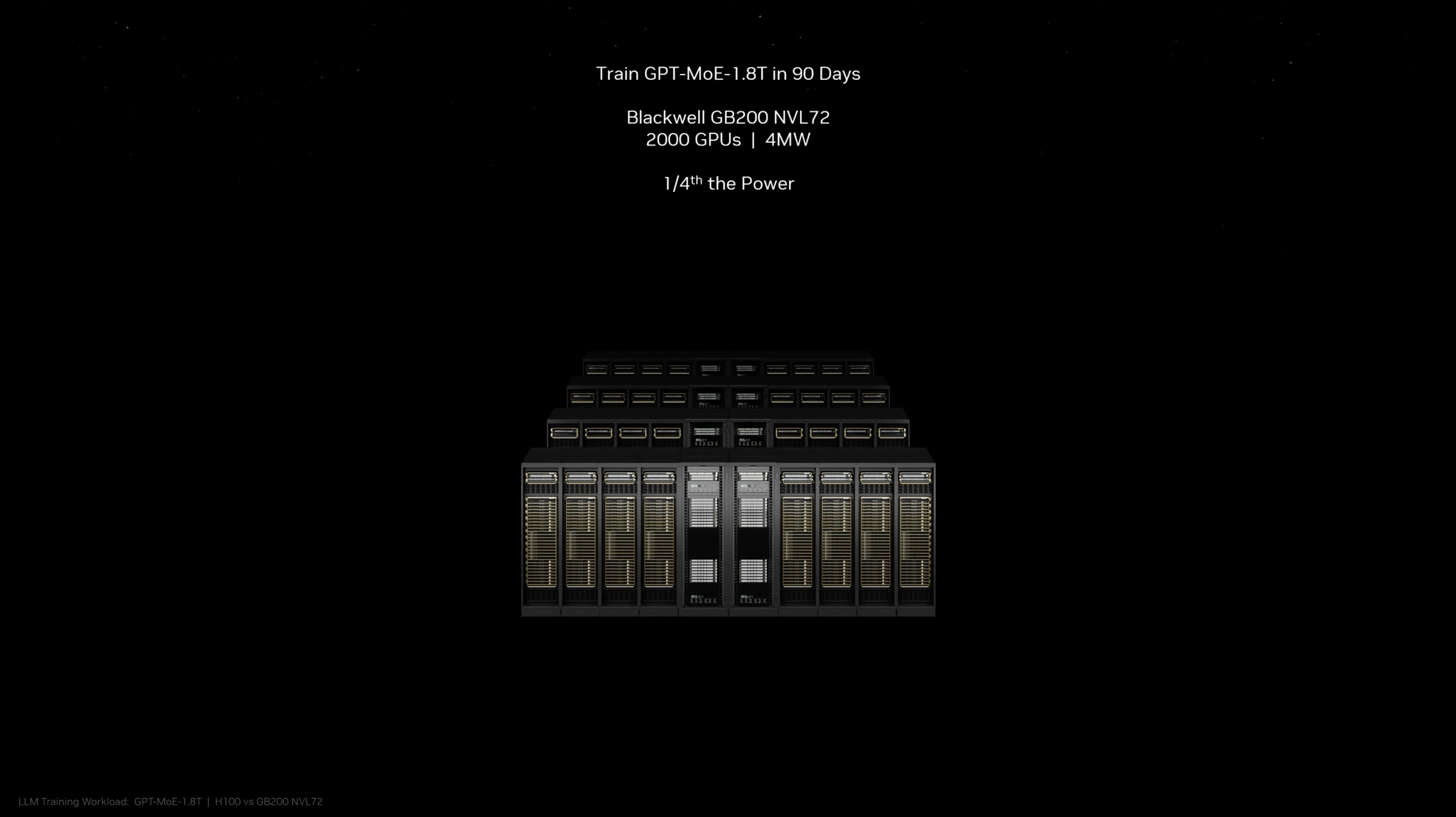

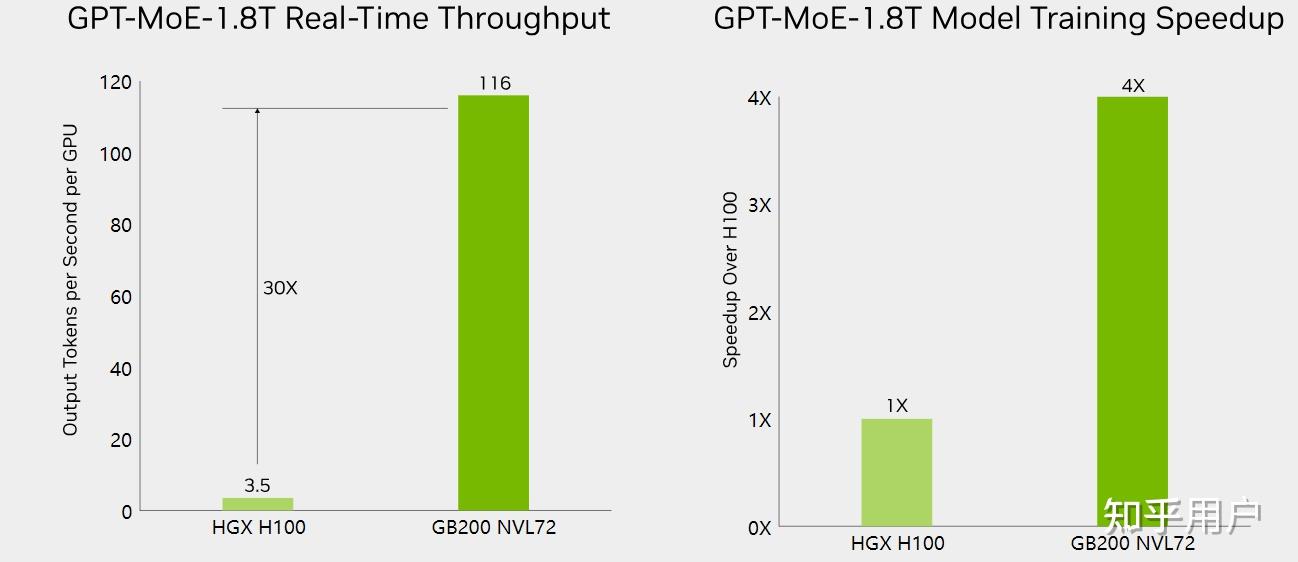

过去,训练一个1.8万亿参数的模型,需要8000个Hopper GPU和15MW的电力。

如今,2000个Blackwell GPU就能完成这项工作,耗电量仅为4MW。

在GPT-3(1750亿参数)大模型基准测试中,GB200的性能是H100的7倍,训练速度是H100的4倍。

GB200由2个GPU、1个CPU、一个主板组成

全新芯片其中一个关键改进是,采用了第二代Transformer引擎。

对每个神经元使用4位(20 petaflops FP4)而不是8位,直接将算力、带宽和模型参数规模提高了一倍。

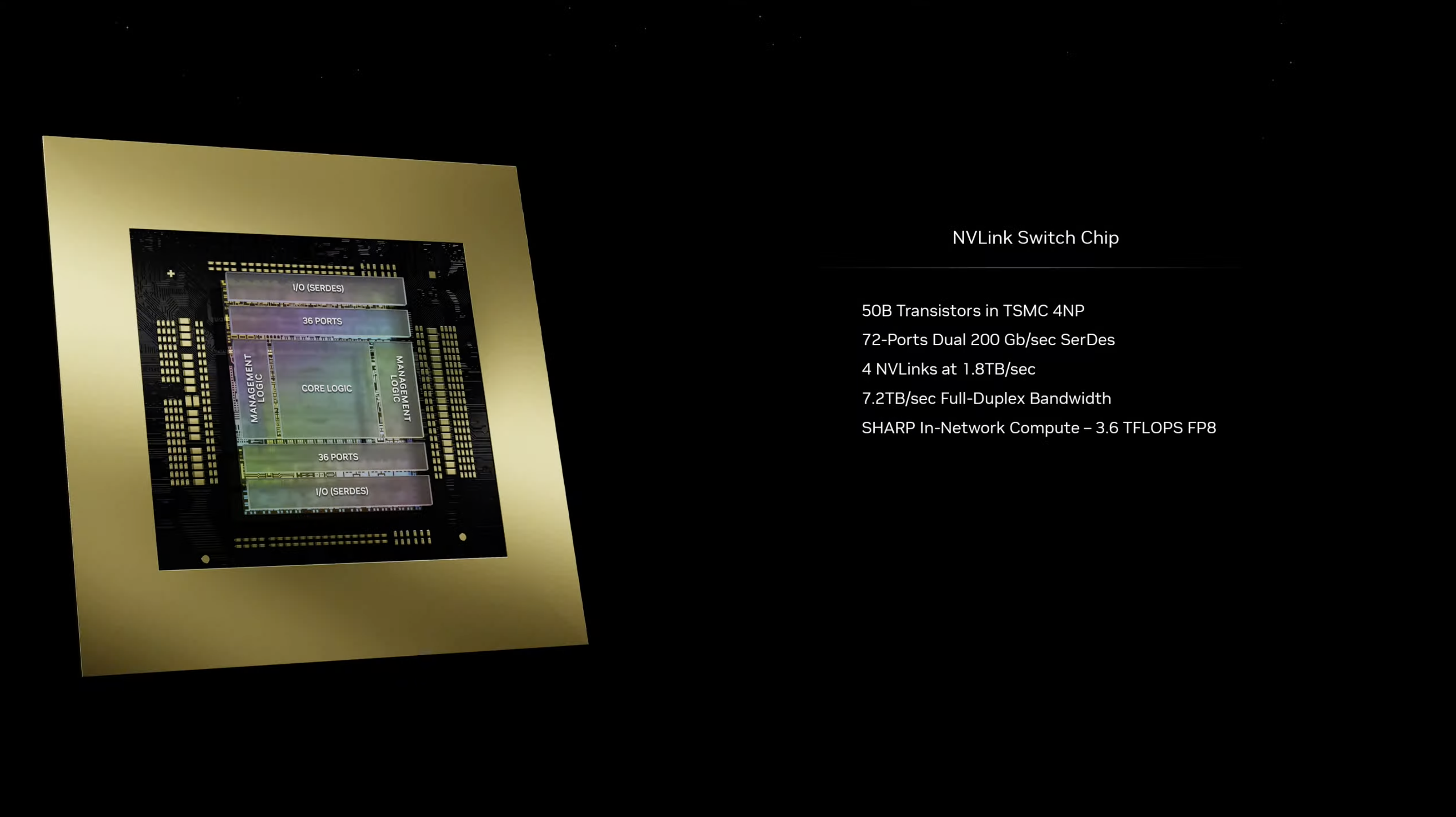

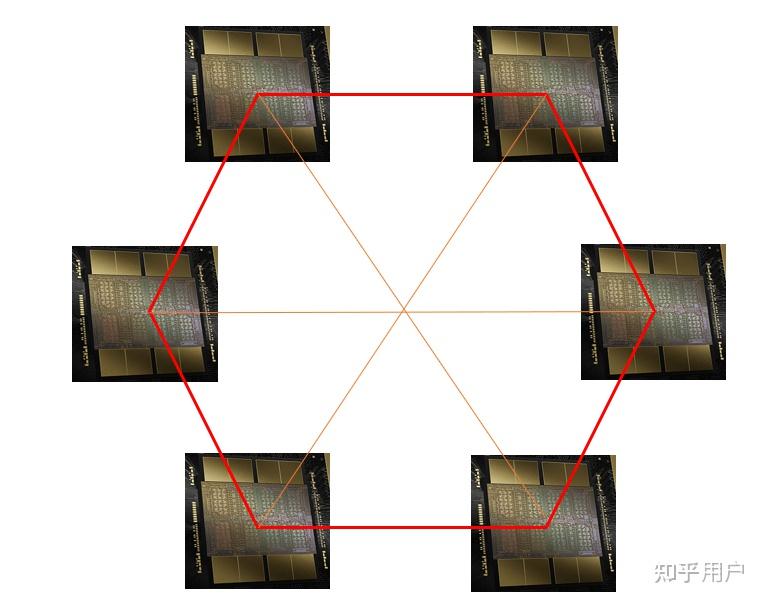

与此同时,英伟达还推出了第五代NVLink网络技术。

最新的NVLink迭代增强了数万亿参数AI模型的性能,提供了突破性的每GPU双向吞吐量,促进了无缝高速通信。

这也就是第二个关键区别,只有当你连接大量这些GPU时才会出现:新一代NVLink交换机可以让576个GPU相互通信,双向带宽高达1.8TB/秒。

这就要求英伟达打造一个全新的网络交换芯片,其中包含500亿个晶体管和一些自己的板载计算:拥有3.6 teraflops FP8处理能力。

在此之前,由16个GPU组成的集群,有60%的时间用于相互通信,只有40%的时间用于实际计算。

英伟达正在用Blackwell增加FP4和FP6

另外,Blackwell还配备了RAS引擎。

为了确保可靠性、可用性和可维护性,Blackwell GPU集成了专用引擎和基于AI的预防性维护功能,以最大限度地延长系统正常运行时间并最大限度地降低运营成本。

老黄表示,「过去8年,计算规模扩展已经增加了1000倍」。

网友:新的摩尔定律诞生了!

网友们纷纷惊叹,Blackwell再一次改变了摩尔定律。

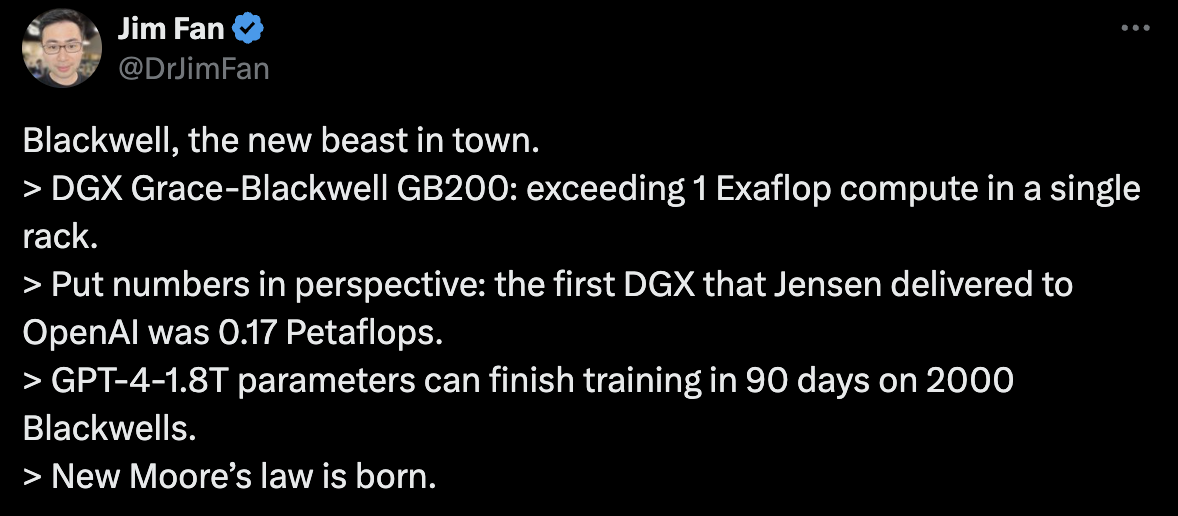

英伟达高级科学家Jim Fan表示:Blackwell,城里的新野兽。

- DGX Grace-Blackwell GB200:单机架计算能力超过1 Exaflop。

- 从这个角度来看:老黄交付给OpenAI的第一台DGX是0.17 Petaflops。

- GPT-4-1.8T参数在2000张Blackwell上可在90天内完成训练。新摩尔定律诞生了。

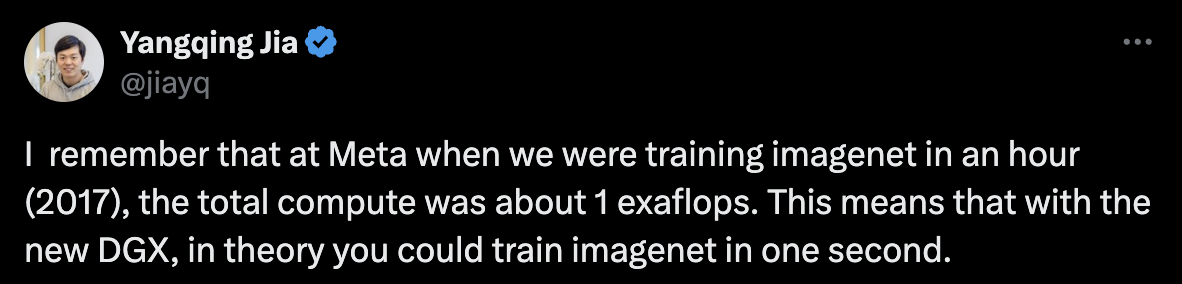

贾扬清回忆道,「我记得在Meta,当我们在一小时内(2017年)训练ImageNet时,总计算量约为1exaflop。这意味着有了新的DGX,理论上你可以在一秒钟内训练ImageNet」。

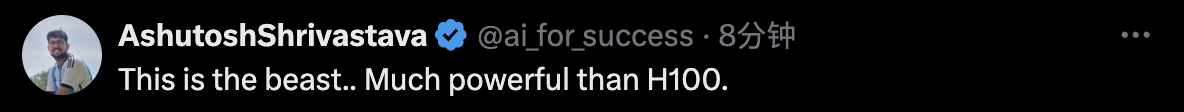

还有网友表示,「这简直就是野兽,比H100强太多」。

另有网友戏称,「老黄有效确认GPT4是1.8万亿参数」。

所以,GB200的成本是多少呢?英伟达目前并没有公布。

此前据分析师估计,英伟达基于Hopper的H100芯片,每颗的成本在25,000美元到40,000美元之间,整个系统的成本高达200,000美元。

而GB200的成本,只可能更高。

新超算可训万亿参数大模型

当然,有了Blackwell超级芯片,当然还会有Blackwell组成的DGX超算。

这样,公司就会大量购入这些GPU,并将它们封装在更大的设计中。

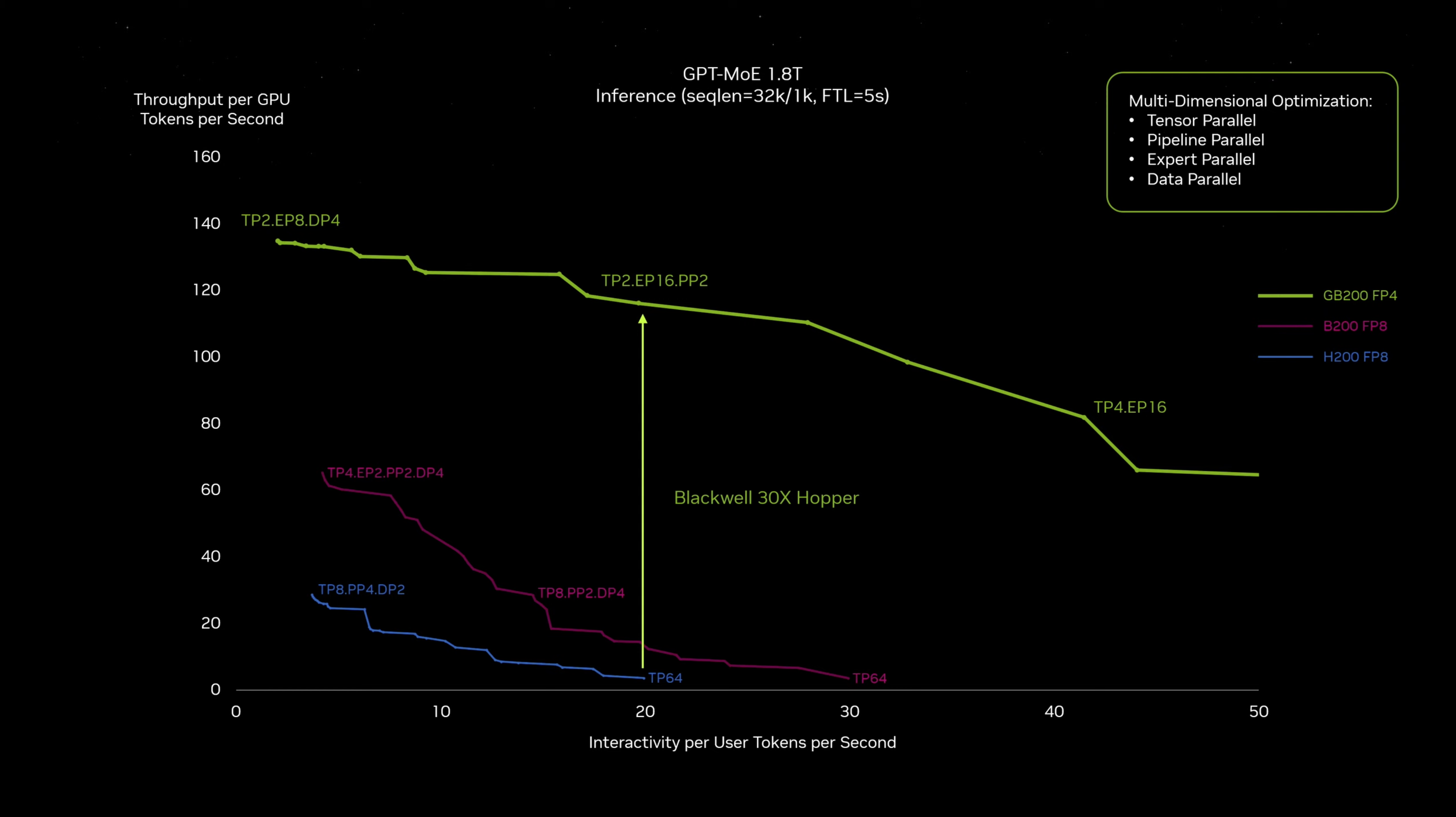

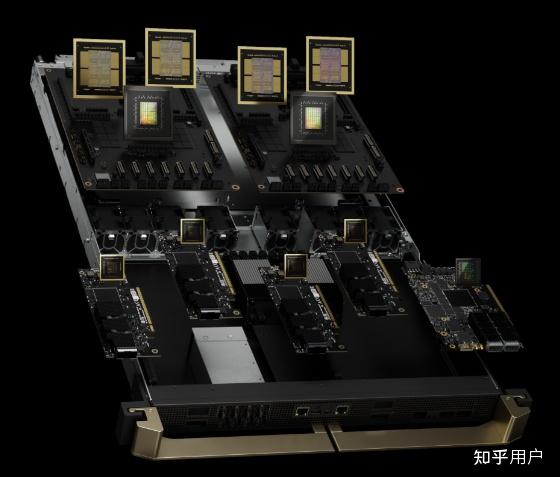

GB200 NVL72是将36个Grace CPU和72个Blackwell GPU集成到一个液冷机架中,可实现总计720 petaflops的AI训练性能,或是1,440 petaflops(1.4 exaflops)的推理性能。

它内部共有5000条独立电缆,长度近两英里。

它的背面效果如下图所示。

机架中的每个托盘包含两个GB200芯片,或两个NVLink交换机。一共有18个GB200芯片托盘,9个NVLink交换机托盘有。

老黄现场表示,「一个GB200 NVL72机架可以训练27万亿参数的模型」。

此前传言称,GPT-4的参数规模达1.8万亿,相当于能训练15个这样的模型。

与H100相比,对于大模型推理工作负载,GB200超级芯片提供高达30倍的性能提升。

那么,由8个系统组合在一起的就是DGX GB200。

总共有288个Grace CPU、576个Blackwell GPU、240 TB内存和11.5 exaflop FP4计算。

这一系统可以扩展到数万个GB200超级芯片,通过Quantum-X800 InfiniBand(最多144个连接)或Spectrum-X800ethernet(最多64个连接)与800Gbps网络连接在一起。

配备DGX GB200系统的全新DGX SuperPod采用统一的计算架构。

除了第五代NVIDIA NVLink,该架构还包括NVIDIA Bluefield-3 DPU,并将支持Quantum-X800 InfiniBand网络。

这种架构可以为平台中的每个GPU提供高达每秒1,800 GB的带宽。

除此之外,英伟达还发布了统一的超算平台DGX B200,用于AI模型训练、微调和推理。

它包括8个Blackwell GPU和2个第五代Intel Xeon处理器,包含FP4精度功能,提供高达144 petaflops的AI性能、1.4TB的GPU内存和64TB/s的内存带宽。

这使得万亿参数模型的实时推理速度,比上一代产品提高了15倍。

用户还可以使用DGX B200系统构建DGX SuperPOD,创建人工智能卓越中心,为运行多种不同工作的大型开发团队提供动力。

目前,亚马逊、谷歌、微软已经成为最新芯片超算的首批用户。

亚马逊网络服务,将建立一个拥有20,000 GB200芯片的服务器集群。

「不是一个芯片,更像一个平台」

自从ChatGPT于2022年底掀起AI热潮以来,英伟达的股价已经上涨了五倍之多,总销售额增长了两倍多。

因为英伟达的GPU对于训练和部署大型AI模型至关重要,微软、Meta等大公司都已纷纷豪掷数十亿购买。

如今各大公司和软件制造商还在争先恐后地抢购Hopper H100等芯片呢,GB200就已经出了。

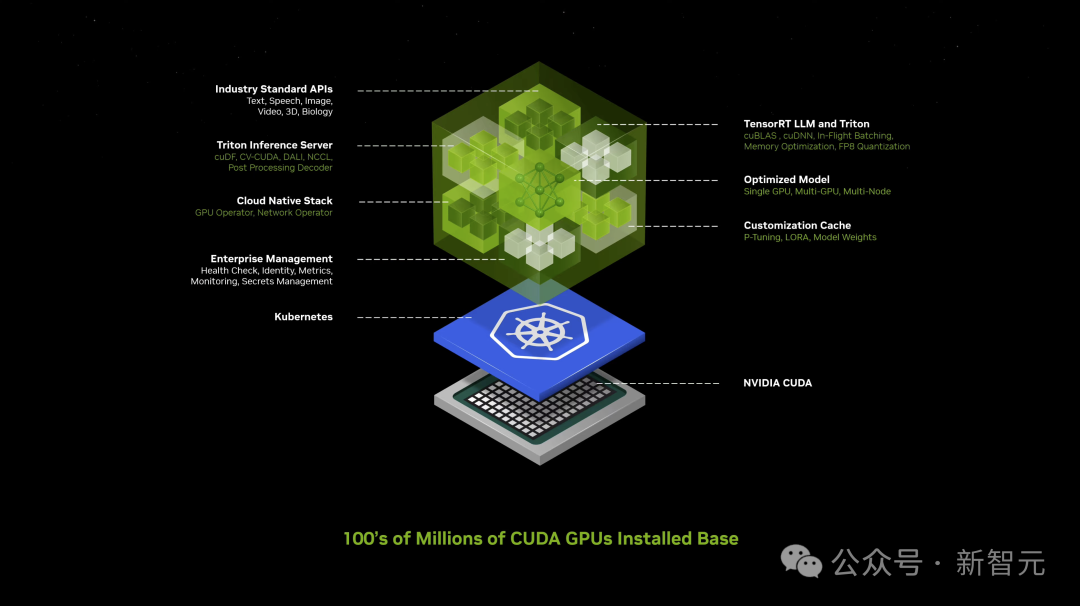

老黄表示,Blackwell不是一个芯片,而是一个平台的名称。

从此,英伟达不再是芯片供应商,而更像是微软、苹果这样的平台提供商,可以让其他公司在平台上构建软件。

英伟达副总裁Manuvir Das表示,GPU是可销售的商业产品,而软件,是为了帮人们用不同的方式使用GPU。

虽然英伟达现在仍然售卖GPU,但真正不同的是,英伟达现在有了商业软件业务。

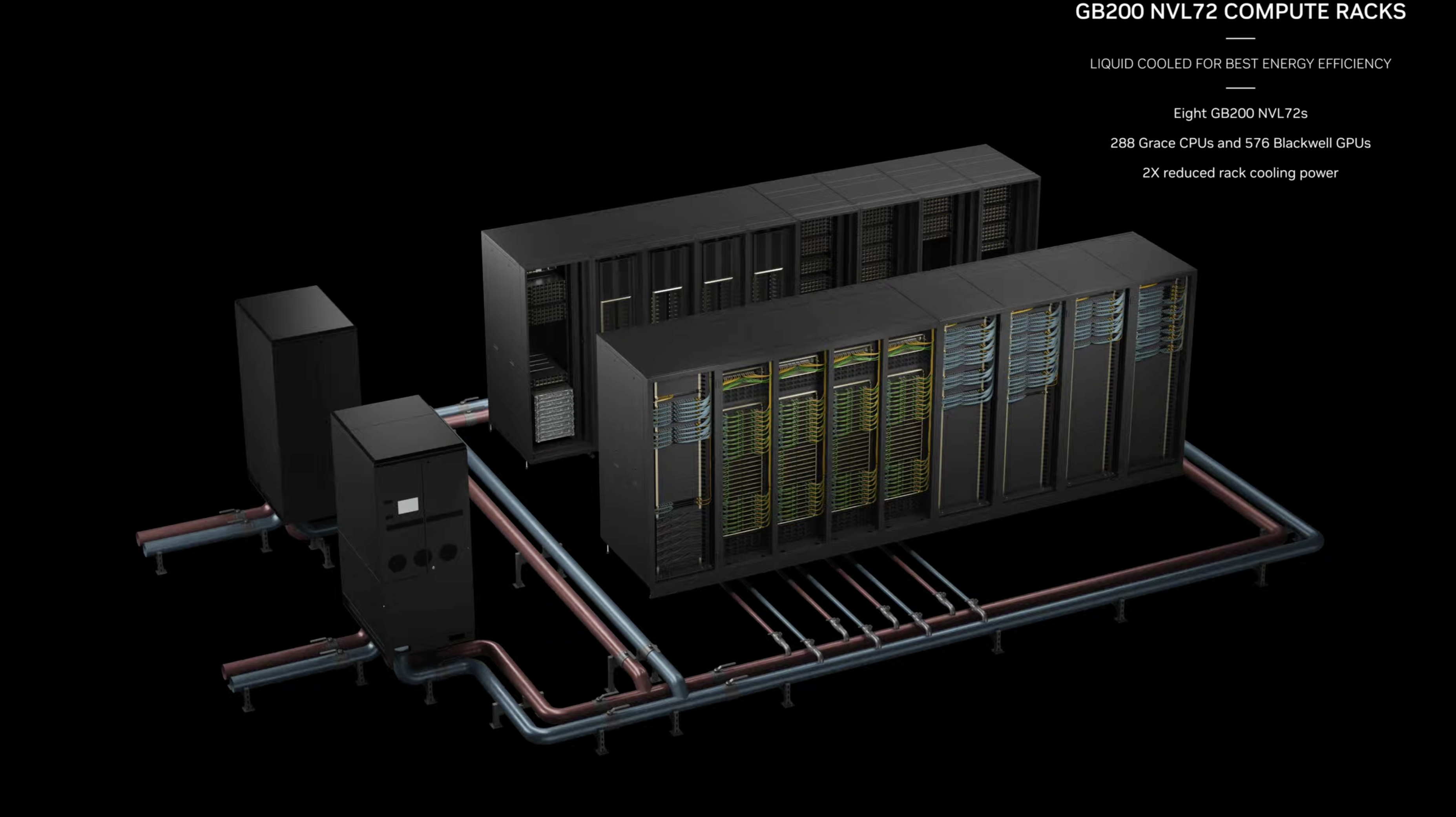

新软件NIM,代表着英伟达的推理微服务。

NIM使得在英伟达的任何GPU上运行程序都变得更容易,即使是可能更适合部署但不适合构建AI的旧GPU。

也就是说,假如一名开发者有一个有趣的模型,希望向人们推广,就可以把它放到NIM中。英伟达会确保它可以在所有的GPU上运行,这样模型的受众就大大扩展了。

NIM使得部署AI变得更容易,这就更加增加了客户使用英伟达芯片的粘性。

并且,与新AI模型的初始训练相比,NIM的推理需要更少的算力。

这样,想要运行自己AI模型的公司,就能运行自己的AI模型,而不是从OpenAI等公司购买对AI结果的访问权。

需要购买基于英伟达服务器的客户,需要注册Nvidia企业版,每个GPU每年需要花费4,500美元。

英伟达将与微软或Hugging Face等人工智能公司合作,确保他们的人工智能模型经过调整,可以在所有兼容的英伟达芯片上运行。

然后,使用NIM,开发者可以在自己的服务器或基于云的英伟达服务器上,高效运行模型,而无需冗长的配置过程。

Das介绍说,在自己调用OpenAI的代码中,他只替换了一行代码,就指向了NIM。

另外,NIM软件还将帮助AI在配备GPU的笔记本电脑上运行,而不是在云端的服务器上。

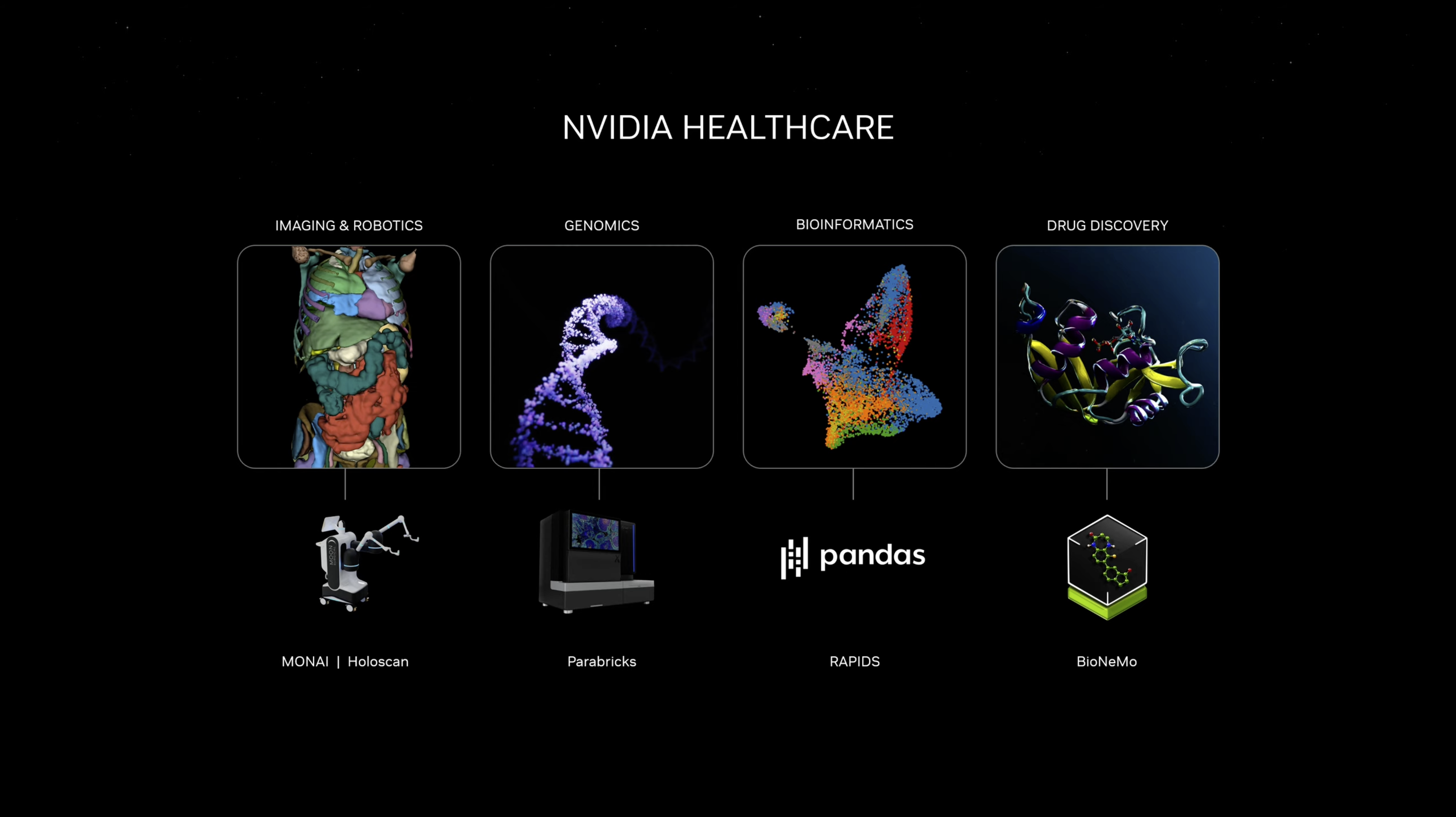

NIM支持跨多个领域的AI用例,包括LLMs、视觉语言模型(VLM)以及用于语音、图像、视频、3D、药物发现、医学成像等的模型。

AI API就是未来的软件。在未来,所有LLM都可以从云端获取,从云上下载,运行它的工作站。

终极生成式AI模型

而现在,整个行业都已经为Blackwell准备好了。

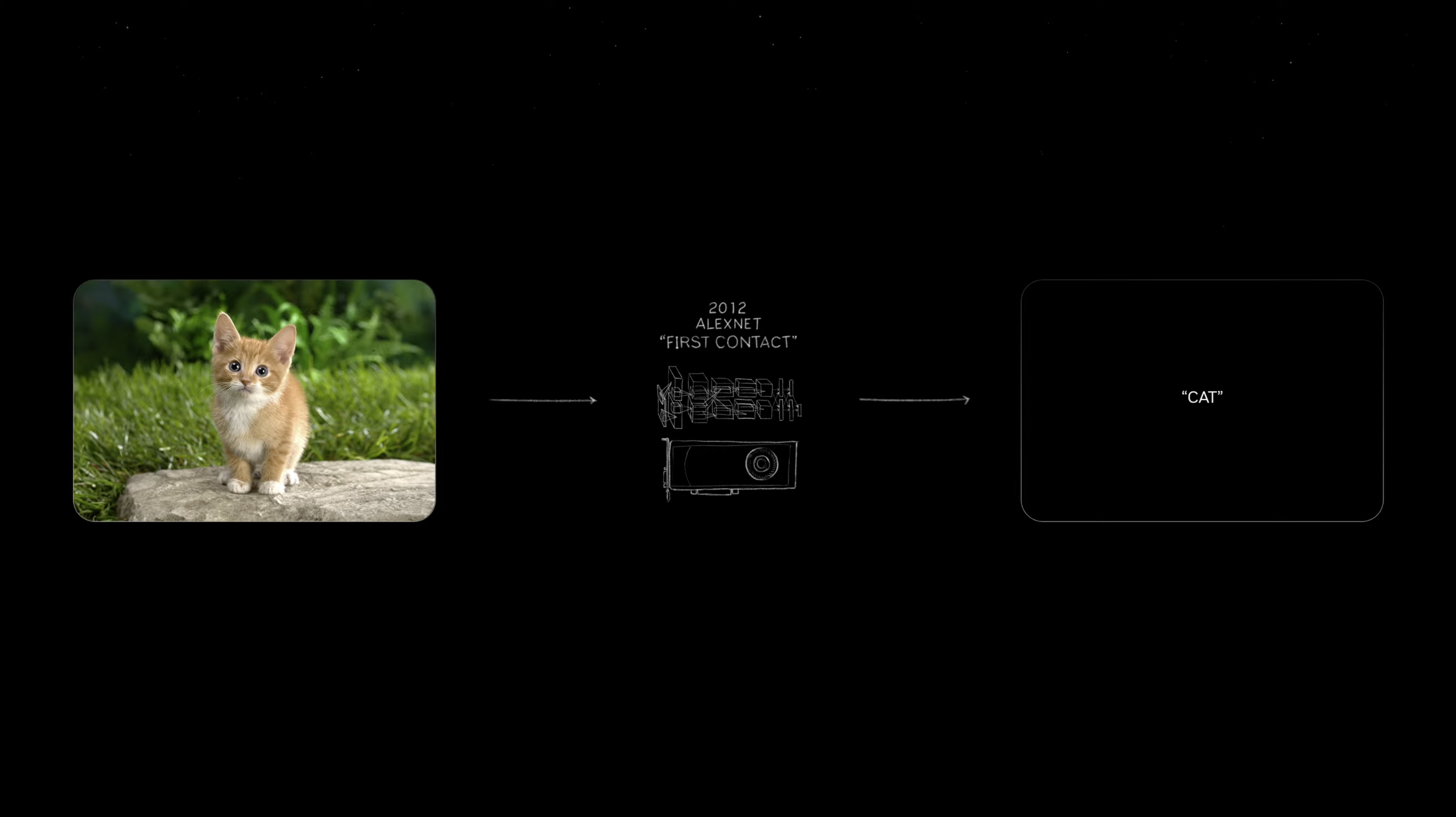

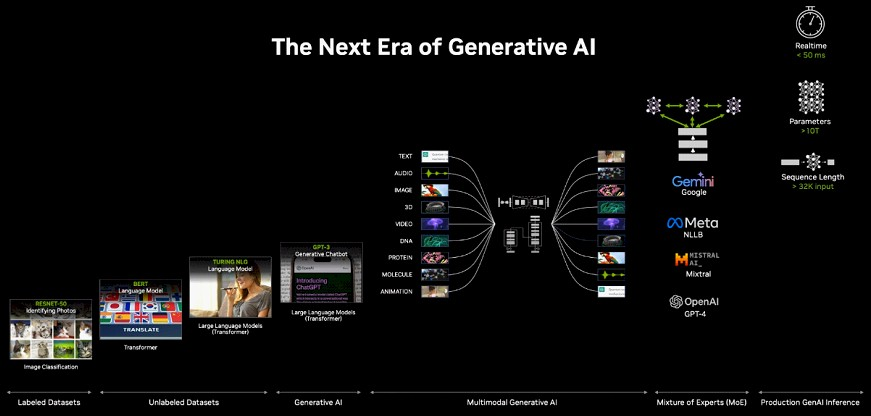

2012年,将一只小猫的图片输入,AlexNet识别后输出「cat」,让世界所有人为之震惊,并高呼这改变了一切。

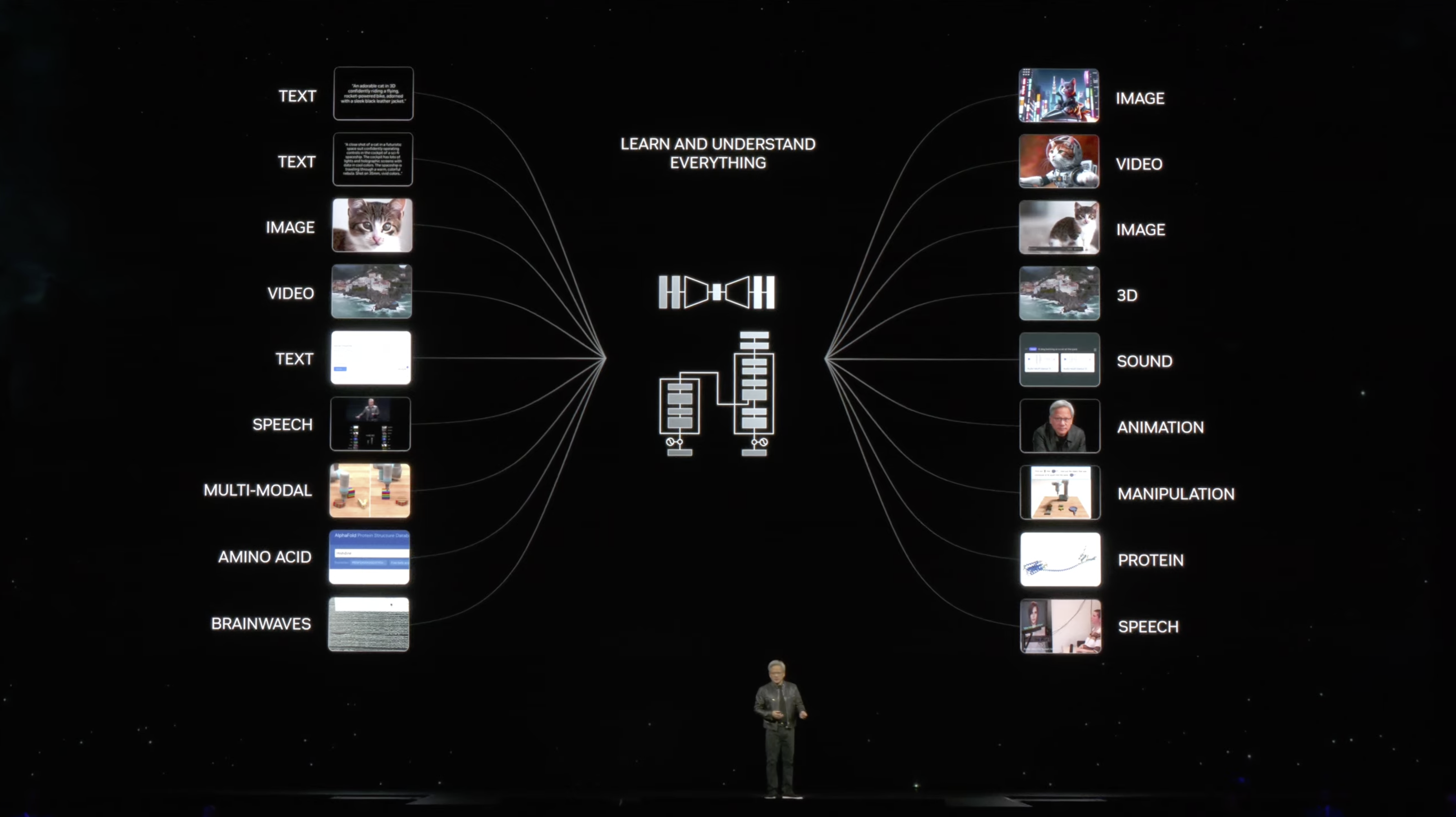

而现在从三个字「cat」输出10 million 像素成为了可能。仅用了10年时间,我们就可以识别文本、图像、视频。

万物都皆可数字化。

网友表示,老黄向我们展示了GenAI的终极游戏:多模态输入——多模态输出。

「这是我们总有一天都会使用的最终模型。它可以获取任何模态并生成任何模态。同时,它还能在没有每个部件的情况下工作」。

数字化的目的是让所有的目标都能成为机器学习的目标,从而让它们都能被AI生成。

比如,数字孪生地球,可以很好地帮助我们了解全球气象气候的变化。

将基因、蛋白质、氨基酸数字化,可以让人类去理解生命的力量。

在大会接近尾声时,活动迎来了一个小高潮:Wall-E机器人也登台表演了。

而生成式AI的未来应用不仅于此。

现在,有了世界最强的处理器Blackwell,新一轮技术革命即将开启。

发布于 2024-03-19 14:34・IP 属地北京查看全文>>

新智元 - 176 个点赞 👍

LLM任务可能要告别16bit浮点数做矩阵乘法计算的时代了。

Blackwell架构的Tensor Core支持FP4,可以让MoE模型的训练和推理受益。

To supercharge inference of MoE models, Blackwell Tensor Cores add new precisions, including new community-defined microscaling formats, giving high accuracy and ease of replacement for larger precisions. The Blackwell Transformer Engine utilizes fine-grain scaling techniques called micro-tensor scaling, to optimize performance and accuracy enabling 4-bit floating point (FP4) AI. This doubles the performance and size of next-generation models that memory can support while maintaining high accuracy.

这里提到的microscaling format应该是如下论文提出的方法,作者来自微软、AMD、英特尔、Meta、NVIDIA和高通,说明这个格式已经在业界形成了一定共识。之前FP8对整个Tensor进行统一scale,但是Tensor level Scaling被证明对于低于8bit的格式来说是不够的,因为这些格式的动态范围有限。所以缩放粒度要下降到更小的的sub-blocks of tensors,也就是Microscaling Data Formats。

Microscaling Data Formats for Deep Learning

另外,跨机的集合通信也可以用SHARP协议支持FP8。

The NVIDIA NVLink Switch Chip enables 130TB/s of GPU bandwidth in one 72-GPU NVLink domain (NVL72) and delivers 4X bandwidth efficiency with NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ FP8 support. The NVIDIA NVLink Switch Chip supports clusters beyond a single server at the same impressive 1.8TB/s interconnect. Multi-server clusters with NVLink scale GPU communications in balance with the increased computing, so NVL72 can support 9X the GPU throughput than a single eight-GPU system.

使用FP8梯度来做通信,这个之前MSRA的人已经做了一些验证。

Transformer Engine 2.0会支持FP4,期待一下第一个用FP4训练出来的MoE大模型。

评论区有人指出参数还是存储成高精度的。这里在补充一下混合精度训练概念:矩阵乘法的计算虽然用低精度数据格式完成,但是梯度计算结果会累加到高精度的参数上,有的非矩阵乘法计算还是会用高精度。具体细节可以参考我上面的知乎文章。

编辑于 2024-03-19 16:54・IP 属地上海查看全文>>

方佳瑞 - 51 个点赞 👍

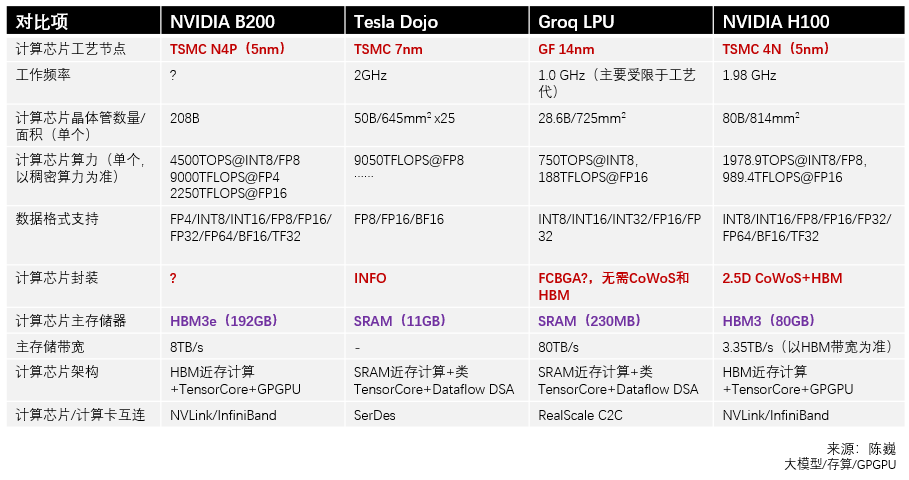

意味着西方阵营先进制程芯片目前领先幅度只有一个节点,这件事情已经基本上可以盖棺定论了。

老黄现在比四年前A100时期可富裕太多了,当代最先进制程的成本对于目前的NV来说完全就是小意思,如果N3真的有跨代级提升,那这种超级旗舰芯片无论如何都没理由不用。现在老黄依然不用N3,那就说明N3真的没卵用,真的又贵又拉垮,拉不开差距…

也就是说,目前西方阵营真正实用的最先进制程就是N4,属于N5节点,然后中芯N+2相当于N7节点——只领先一个节点。往前推五年,这种事情可是想都不敢想的。既然你现在已经撞墙,已经开始堆面积砍精度了,那我追起来可就有底气多了。

编辑于 2024-03-19 22:37・IP 属地北京查看全文>>

知乎用户 - 48 个点赞 👍

查看全文>>

王鸿钰 - 45 个点赞 👍

查看全文>>

团长 - 42 个点赞 👍

性能提升30倍,难怪有媒体说它是“AI核弹”!简单进行比较,单个B200的“算力”是它的前代产品H100的整整5倍。

B200芯片这是一款具有革命性的高性能计算产品,这个硬件性能的提升太及时了,要知道就在近日,来自MIT FutureTech的研究人员发表了一项关于大模型能力增长速度的研究。

该研究结果表明,大型语言模型(LLM)的能力以惊人的速度增长,大约每8个月翻倍,这一增速远超传统的摩尔定律预测。

由于LLM的能力提升在很大程度上依赖于算力的增强,而摩尔定律代表着硬件算力的发展,也就是说,随着时间的推移,终有一天人类的硬件设备,将无法满足LLM所需要的算力。

然而,令人没想到的是,才过几天,英伟达的最新B200芯片就以其卓越的性能,特别是在处理大型模型方面的算力,展现出了比LLM能力增长更快的硬件提升速度。

这一突破性的进展不仅满足了当前LLM对算力的迫切需求,还为未来更复杂模型的运行,提供了坚实的硬件基础。

B200芯片的推出,无疑是对目前大模型算力需求快速增长的回应,这也确保AI技术能够在满足基本硬件条件的情况下持续发展,不受算力限制的束缚。

性能的提升

B200芯片拥有2080亿个晶体管,这一数字是上一代H100芯片的两倍多。晶体管数量的增加直接关联到芯片处理能力和效率的提升。

与用于推理的相同数量的H100 Tensor Core GPU相比,全新的GB200 NVL机架级系统具有36个Grace Blackwell超级芯片,性能提高了30倍。

这意味着一台服务器的AI推理能力相当于一个超级计算机,极大地加速了AI技术在实际应用中的部署和运行。

对AI领域的意义

硬件的提升,带来的必然是更多的可能性。

在未来五年的时间内,我们预计将进入一个全新的信息处理时代,其中文本、图像、视频和语音等多种形式的数据,也许都能够实时输入到大语言模型(LLM)中。

计算机就能够直接接入所有信息源,并通过多模态交互不断地进行自我学习和改进。

而这,需要的就是巨量的算力。

只要能投入足够的计算资源,在所有的数据都被加载进大语言模型(LLM)后,构建超越人类智能的通用人工智能(AGI)就可能实现。

在不远的未来,我们可能只需使用简单的自然语言,就能与计算机进行有效沟通,并且实现我们想要的各种需求。

生成式AI在未来可能会演变为一种宏观世界层面的操作系统。

未来是创意的世界,只需要有足够的创意,人工智能就能够利用人类的历史积累智慧,想方设法把创意变为现实。

结语

硬件性能的提升,如果用人类来做类比,就好比我们拥有了一副能够适应更长时间工作需求的健康身体,以及一个反应更加迅速、思维更加敏捷的大脑。

这个身体不仅能够承受更高强度的工作压力,还能在面对复杂问题时迅速做出决策和响应。

正如一个经过良好训练的运动员,才能够在竞技场上展现出更加超凡的耐力和速度,英伟达B200芯片的推出,为AI领域带来了类似的飞跃。

在AI的世界里,芯片性能的提升,意味着计算机能够更快地处理和分析大量数据,更有效地训练复杂的机器学习模型,以及更实时地响应不断变化的计算需求。

这种硬件上的突破,为AI技术的发展打开了新的可能性,使得我们能够更加自信地迈向未来,探索那些曾经因为算力限制而难以触及的领域。

正如一个健康的身体是实现个人潜能的基础,强大的硬件性能也是推动AI技术进步和创新的基石。

随着高性能硬件的涌现,我们可以期待AI在未来将如何改变世界。

我是德里克文,一个对AI绘画,人工智能有强烈兴趣,从业多年的设计师!如果对我的文章内容感兴趣,请帮忙关注点赞收藏,谢谢!

编辑于 2024-03-19 18:21・IP 属地福建查看全文>>

德里克文 - 41 个点赞 👍

B200的主要进步,包括

1)使用先进封装,把两块GPGPU整合。这方案在Apple的芯片上已经采用很多年了。

2)使用FP4,提升算力密度。这个方法难度也不高,不过目前全世界使用FP4的还很少。

感觉B200的创新有点乏力了

发布于 2024-03-19 13:01・IP 属地广东查看全文>>

陈巍 - 22 个点赞 👍

是的,翻白眼儿还是允许的。

是的,反思还是允许的。

是的,甚至骂街也是允许的,即便不允许,躲在知乎上骂也是没问题的。

但是,不管咋说,这B200和你已经毫无关系了。从右边念或许道出了你们的本质。零零在空军的语境中又可以读成动动,这黄仁勋是诚心欺负人戏弄人啊!

Blackwell GPU是不是可以翻译成好黑GPU?

发布于 2024-03-19 19:27・IP 属地北京真诚赞赏,手留余香还没有人赞赏,快来当第一个赞赏的人吧!查看全文>>

刑天唐伯志 - 15 个点赞 👍

最强的AI芯片是畅销8年的麒麟710、被鸿蒙优化成旗舰性能的骁龙680;而宇宙最强的是麒麟9000、s、l、w,有这么多、这么强的国产芯片不用,非要去买美帝的芯片吗?不ai国吗?大公主受了那么多委屈,为什么不买华为芯片呢?

发布于 2024-03-19 17:17・IP 属地山东查看全文>>

十万个干什么 - 13 个点赞 👍

查看全文>>

bzrby - 8 个点赞 👍

老美真是快到寿了

去年炒作CHAT

今年炒作sora

炒完星舰

炒芯片

大殖子高潮一阵又一阵

美弟赢麻了 遥遥领先 我们要反思 定体问卷土重来

殖子们奔走相告 普天同庆 就如自己家里中奖了 扬眉吐气了 高人一等了

美弟真正黑科技还是远程养殖。

量子计算通讯大殖子视而不见

华为手机突破装看不到

新能源汽车大卖装瞎

航天科技不断突破不吱声

低空飞行汽车说不经济不实用

无人驾驶、生产线一个个落地它们装不知道

看到没

这些人不是脑子有问题它们聪明得很,就是屁股有问题而已,自甘把灵魂卖给敌人,当带路党当走狗当汉奸。

中国玩的是落地是产业是产能,美弟玩的还是虚了一些。AI再牛逼,不可能几台电脑凭空造出东西,还是需要结合实体服务实体。

星舰规划长久,到现在美弟5G也没普及

发动机这么刁,高超音速胡赛都有了,美弟没有

科技这么发达,苹果都玩不起新能源,光环不再

福利这么高,到处流浪汉,中国却全国脱贫

这么自由民主,到处是抽叶子、零元购,对比中国的确遥遥领先。

说会科技,科技再牛逼,还是要落地。能造出来,跟能应用又是两码事。

现在老美在局势上被逼得无路可走,就没事炒作几个科技新闻挽回颓势。

以后“科技突破”会越来越多,一个比一个雷。但是十有八九半年一年后全无消息。

局势所逼,美弟太需要点几个爆竹喜庆一下了。

然并卵,没未来了!

发布于 2024-03-19 18:56・IP 属地山东查看全文>>

飞得更高 - 6 个点赞 👍

美国基本到了强鹭之末,最近一段时间会集中造假利好,能吹多大吹多大,骗人接盘之后降息。

有人可能会问一句,降息股市不是应该涨吗?

对的,但是美元会暴跌,通胀两位数起步(如果敢报出真实数据的话),国外资金谁去谁死。

编辑于 2024-03-20 01:10・IP 属地湖南查看全文>>

优雅只于心间 - 5 个点赞 👍

总体来看是瞄准的是大模型,还有大力出奇迹。 参考意义两方面:

- 在工艺一定时,可以增大面积,采用更小精度,来增加吞吐。国产芯片可参考。

- 产品国内是买不到的,实测也没机会,只能根据资料(datasheet/TechBlog)评估一下当A国的大厂装备了此等装备后,我们该怎么追? 我们迭代一个模型耗费一年,人家迭代一个月/一周/一天?国产大模型厂可参考。

不是游戏卡,跟普通消费老百姓关系不大,就看看参数的热闹,来句“哇塞,SpaceX的钢皮甲烷火箭又升天啦”即可。

根据一些参考文章(文末)看一下新芯片在软/硬件的亮点:

1 硬件

1.1 芯片的升级

架构取了个新名字BlackWell

特点1:工艺不变,面积大了。怎么变大的---就是把两块芯片通过一根10TB/s 接起来,那么就大了。工艺的话认为是没有多大变化的。发布会嘛,不能说没啥变化吧,那就来个改良版4NP。

Blackwell-architecture GPUs pack 208 billion transistors and are manufactured using a custom-built TSMC 4NP process. All Blackwell products feature two reticle-limited dies connected by a 10 terabytes per second (TB/s) chip-to-chip interconnect in a unified single GPU.

工艺不变,串一点芯片就有戏了,真好,再也不要说堆叠了,我们搞串并联。so,国内的芯片是不是可以搞个4连、8连、16连、一键三连等措施,不管怎样连就对了。比如这样:

原创性--五边形芯片架构 特点2:依然稳稳地瞄准了大模型。 二代transformer引擎,针对的是MoE 和FP4。

1、此处,我和很多砖家们一样,都猜不准是为了搞点新鲜,从而推出了个FP4精度,还是说FP4真的有神奇之处。幸运的是,没有机器验证不了,先挖个坑,后续有机会了测测填坑(等A国解禁或者自费出国?)。

2、MoE嘛...国内的独角兽们,MoE市场需求再次实锤了,搞大模型MoE必不可少,投投投。

特点3/4/5: 好像没啥特点,参看文献1。

1.2 集群的升级

集群又升级了,这才是利器啊!造一个东西可能不难,量产一堆东西,还有凑在一起稳定工作、性能优秀、节能环保,这就有点家伙了。

过程是:

第一步,生成产这玩意(机器 GB200):

第二步,组装成这玩意(机柜 NVIDIA GB200):

NVIDIA GB200 第三步,接着拼装成这玩意(集群):

DGX SuperPOD 我们直接看看集群的参数吧:

看着确实不错,注意下面有串小字2:是在稀疏条件下测试的数据哦。

2 软件

软件方面的提升主要看看训练和推理方面的吞吐,这里也找到了官方提供的大模型benchmark数据,大家看看就好了:

推理吞吐的宣传:

GB200 NVL72 introduces cutting-edge capabilities and a second-generation Transformer Engine which enables FP4 AI and when coupled with fifth-generation NVIDIA NVLink, delivers 30X faster real-time LLM inference performance for trillion-parameter language models. This advancement is made possible with a new generation of Tensor Cores, which introduce new microscaling formats, giving high accuracy and greater throughput. Additionally, the GB200 NVL72 uses NVLink and liquid cooling to create a single massive 72-GPU rack that can overcome communication bottlenecks.

训练吞吐的宣传:

GB200 NVL72 includes a faster second-generation Transformer Engine featuring FP8 precision, enabling a remarkable 4X faster training for large language models at scale. This breakthrough is complemented by the fifth-generation NVLink, which provides 1.8 terabytes per second (TB/s) of GPU-to-GPU interconnect, InfiniBand networking, and NVIDIA Magnum IO™ software.

数据里面,其它数据都比较酷炫。就训练倍数是4x,可见训练提升不是那么容易。考虑真实的线性度,数据可能会更低。

不管怎么样,钢板甲烷火箭还是上天了,值得我们学习。

参考文章:

- Blackwell Architecture for Generative AI | NVIDIA

- NVIDIA DGX SuperPOD with DGX GB200 Systems Datasheet

- NVIDIA Blackwell Platform Arrives to Power a New Era of Computing | NVIDIA Newsroom

- GB200 NVL72 | NVIDIA

- NVIDIA GB200 NVL72 Delivers Trillion-Parameter LLM Training and Real-Time Inference | NVIDIA Technical Blog

发布于 2024-03-19 19:50・IP 属地上海查看全文>>

知乎用户 - 4 个点赞 👍

B200 GPU提供20 petaflops的FP4算力,源自其2080亿个晶体管,相比前代H100芯片,性能提升了30倍。并且B200在性能大幅提升的同时,将成本和能耗降低了25倍,这意味着在处理大规模AI模型时,更省电了

B200基于台积电的N4P制程工艺,这是上一代Hopper H100和Ada Lovelace架构GPU使用的N4工艺的改进版本。

B200并不是传统意义上的单一GPU,而是由两个紧密耦合的GPU芯片组成,通过10 TB/s的NV-HBI连接。更炸裂的是 两个B200 GPU和一个Grace CPU的GB200超级芯片,理论算力达到40 petaflops。并且没有内存局部性问题或缓存问题,CUDA 将其视为单块 GPU。

一块不行连上两块一起开干,妥妥的AI核弹

发布于 2024-03-19 16:47・IP 属地重庆查看全文>>

喜东东 - 3 个点赞 👍

英伟达2024 GTC大会如期开幕。

和之前相同的是,皮衣刀客老黄又带着王炸产品强势回归了。

而和之前不同的是,这次的AI春晚伴随着全世界的瞩目和飙升市值。