得算力者得天下

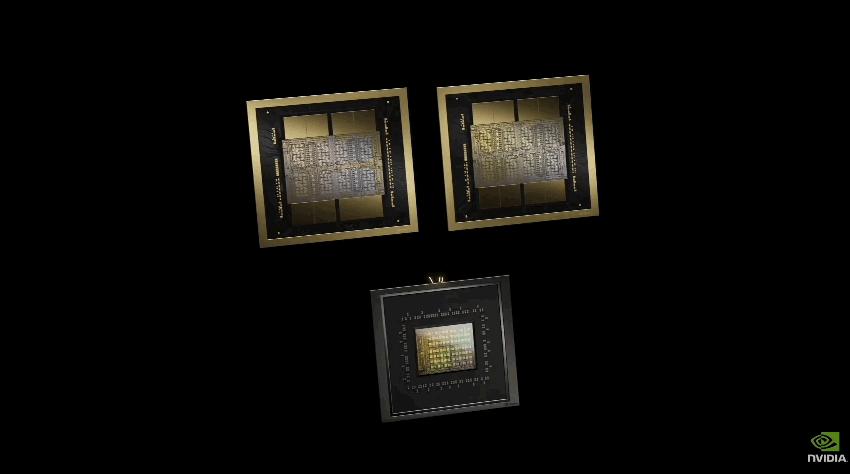

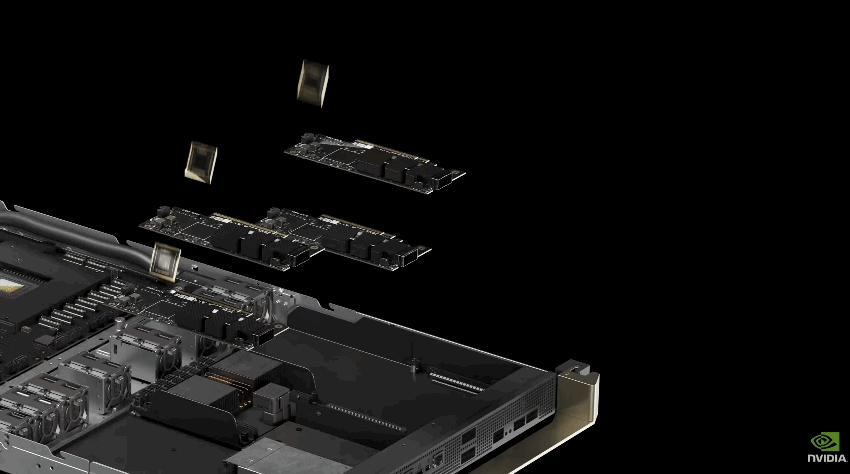

在标准的1750亿参数GPT-3基准测试中,GB200的性能是H100的7倍,提供的训练算力是H100的4倍。

过去,在90天内训练一个1.8万亿参数的MoE架构GPT模型,需要8000个Hopper架构GPU,15兆瓦功率。

如今,同样给90天时间,在Blackwell架构下只需要2000个GPU,以及1/4的能源消耗。

意味着 英伟达将成为下一个王者,黄仁勋坐上世界首富的宝座只是时间问题了。

对于整个 AI 领域的发展是好事,算力升级,节省的是人类的时间。能够以更快的速度验证自己的猜想,完成任务,会有更多的突破。

但是,作为国内的开发者,只能感到绝望。这样的产品,会让原本就和国外比较大的差距变得更大。

在这一波大模型发现的浪潮中,算力就是一切,理论、想法、语料、工程问题都可以解决,唯独算力,没有就是没有。算力掉队,别人一分钟搞定的事情,你用替代产品要等一星期,差距就这样越拉越大。只能干着急。

发布于 2024-03-19 18:55・IP 属地北京