简介:MLP定理的灵感来自逼近定理。相反,这里专注于Kolmogorov–Arnold表示定理,该定理可以通过一种成为Kolmogorov–Arnold网络的新型神经网络实现。在本文的 后续将会回顾Kolmogorov-Arnold 定理,并且根据此定理启发Kolmogorov-Arnold 网络设计。同时为KAN的表达能力机器神经缩放定律提供了理论保证。本文同时提出一种网络扩展技术,以使KAN越来越准确。在后面也提出了简化技术,使得KAN是可解释的。

1、Kolmogorov–Arnold 理论

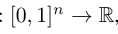

此理论由Vladimir Arnold和Andrey Kolmogorov共同确定,如果f是有域上的多元连续函数,则f可以写为单个变量的连续函数和加法的二元运算的有限组合。f的定义域:

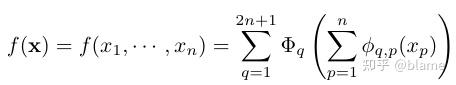

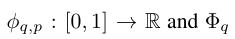

这里满足条件:

从某种意义上说,证明了唯一真正的多元函数都是加法,因为所有其他的函数都可以使用单变量函数和求和进行编写。对于机器学习来说,人们会天真的认为这是一个好消息:学习高维函数可以归结为学习多项式的一维函数。然而,这些一位函数可能是非平滑的,甚至是分形的,因此在事件中可能无法学习。由于这种病态行为,Kolmogorov–Arnold定理在机器学习中被判处为死刑,被认为理论上是合理,但实际上毫无用处。

然而,本文则认为Kolmogorov–Arnold定理对机器学习是有用的。首先我们不需要拘泥于原来的方程。它只有两层非线性和隐藏层中的(2n+1)项,这里将网络推广到任意宽度和深度。其次,科学和日常生活中的大多数功能通常是平滑的,并且具有稀疏的组成结构,这可能有助于有平滑的Kolmogorov–Arnold函数。这里更关心典型的情况而不是最坏的情况。毕竟,物理世界和机器学习任务必须具有使物理学和机器学习有用或可推广的结构。