谈MLP被干掉,还为时过早。我们对于KAN的主要观点:

1)精度比传统MLP更高;

2)训练算力要求更高,训练难度更高;

3)现在看起来toy的主要原因是因为Training的算力完全跟不上。

关于KAN的详细解读,可以看我们团队的长文:

由于训练算力限制,到大模型这类主流应用还是有很长的路要走,短期看KAN还是很难代替MLP的。类似当年Encoder-Decoder架构可能看起来比Decoder only要好,但实际上Encoder-Decoder的训练代价导致GPT这类Decoder only架构成为现在的主流。长远看KAN可能逐渐在数学物理研究中广泛采用,然后逐渐进入主流舞台。

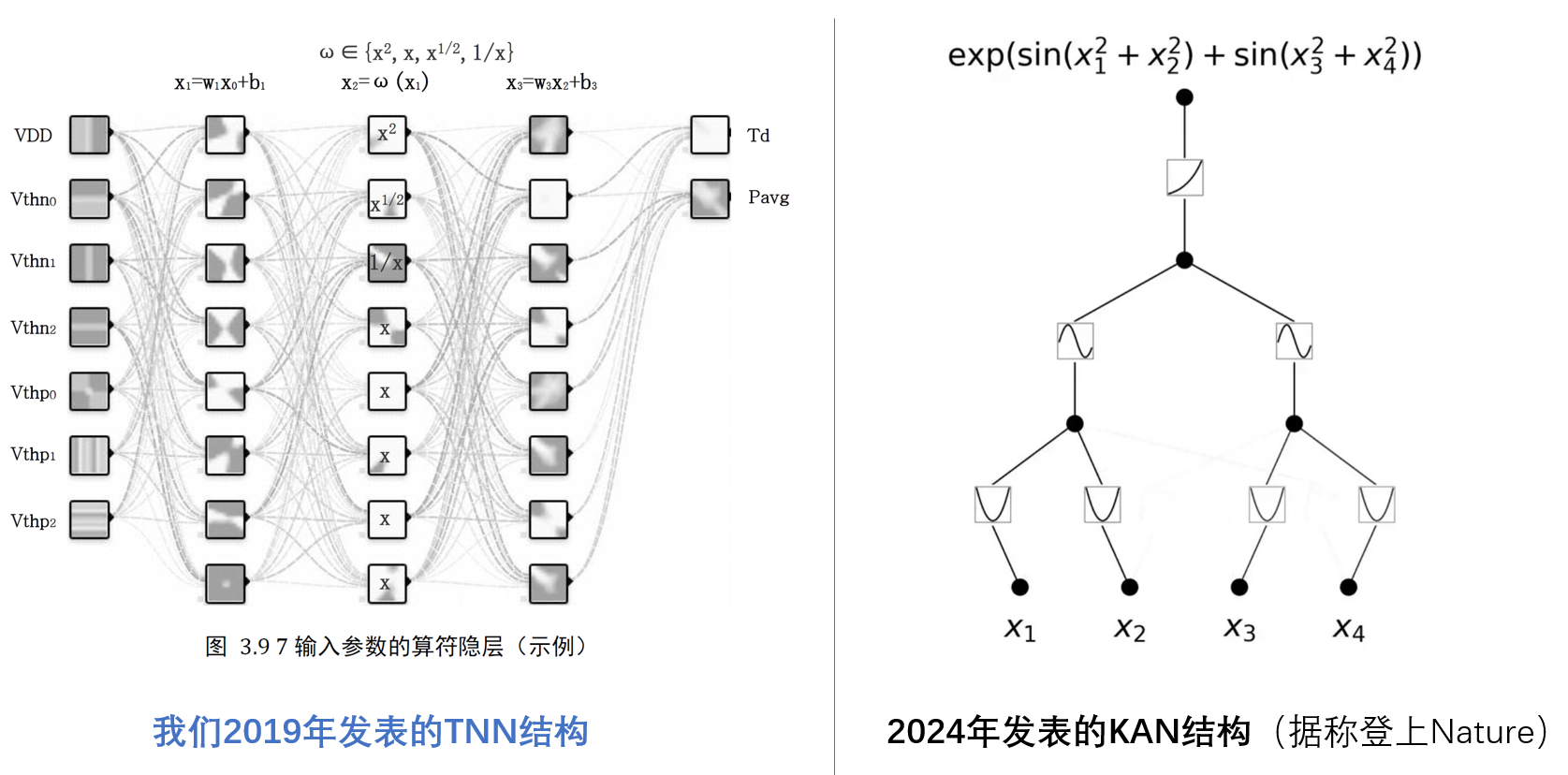

顺带说下,我们团队在5年前就发表了相近工作(我们称为TNN),在传统MLP中加入算符隐层,并奠定了使用非线性算子的核心思路。

其优势是使用非线性算子(典型的是多项式或样条)可以更快的逼近任意函数,难度在于训练的算力要求过高。这个工作的本质是借鉴了MLP及SVM Kernel Function的思路。

关键点有2个:

1)构造算子空间,提升表征能力。把原来的MLP实数空间扩展到“实数+算子”的泛函空间,将算子/核函数视为空间中的离散元素,将MLP中的乘法扩展为算子空间的元素。

2)参考泰勒展开,减小算子空间元素数量。参考泰勒展开的思路,可以使用多项式(非线性函数)累加做任意实数函数的逼近。这也就解释了为什么TNN和KAN这类方法可以很好的应用于数学计算。

发布于 2024-05-04 12:10・IP 属地广东