我个人认为,由于美国后面的新一轮制裁,AI卡供应商是非常有可能在国内追赶英伟达的生态。

对于目前的大模型来讲,大部分大模型都使用pytorch来进行原始开发,很少有的也会写 jax。由于pytorch 现在支持第三方设备的注册,所以诸如华为生态和摩尔线程都是可以在纯 pytorch 上面运行的。

我们先来说说华为,华为支持的最好的当然是 mindspore 自家生态,但是华为最近也在大力适配 pytorch,他们的 torch_npu 仓库每天都会有很多提交。华为的 pytorch 应该是目前适配简单的了,import torch_npu 就可以把所有的 cuda 模型适配和编译到 cann 后端,目前是 pytorch2.0 的一类赞助商,保持着和 cuda,rocm 一样的算子适配程度和生态。 通常来讲,直接运行的模型能有 h100 的 50-60 性能,适配过的更高。(可以写华为的 npu 算子),同时,华为也应该是互联和国产算力做的最好的厂商,他们现在正在推新的光通信方案。

再来说说摩尔线程,摩尔线程目前对于 pytorch 的支持比较好,诸如 vllm,deepspeed 等库他们都有做适配。但是他们会优先在内部仓库上面适配和测试,再逐步推送版本到 GitHub 公开仓库,也意味着开发者不能使用到最新的支持。

摩尔线程在4天前向github上公开了他们对于pytorch的最新适配,torch_musa 1.1.0,这个需要用他们最新的计算卡的开发驱动 2.6.0,这个驱动和 2.5.0 属于不同的分支,目前不兼容图形化。 由于内核适配到 5.15,所以 Ubuntu22.04 也能正常安装和使用。他们的步子也很大,有 MUSA生态迁移 cuda、也有 MUDNN 等库支持,同时他们在 s4000 上也做了类似 nvlink 的互联方案和互联通信协议库,整体来说就是复刻了一个 cuda。比较惊喜的地方在于,s80/s3000 只支持 tf16,但是 s90/s4000 支持 tensorcore 有这 tf16,bf16,tf32 的支持。同时他们也支持 amp 自动混合精度的训练。美中不足的是他们卡的功耗有点高,同时卡的计算性能比较低。

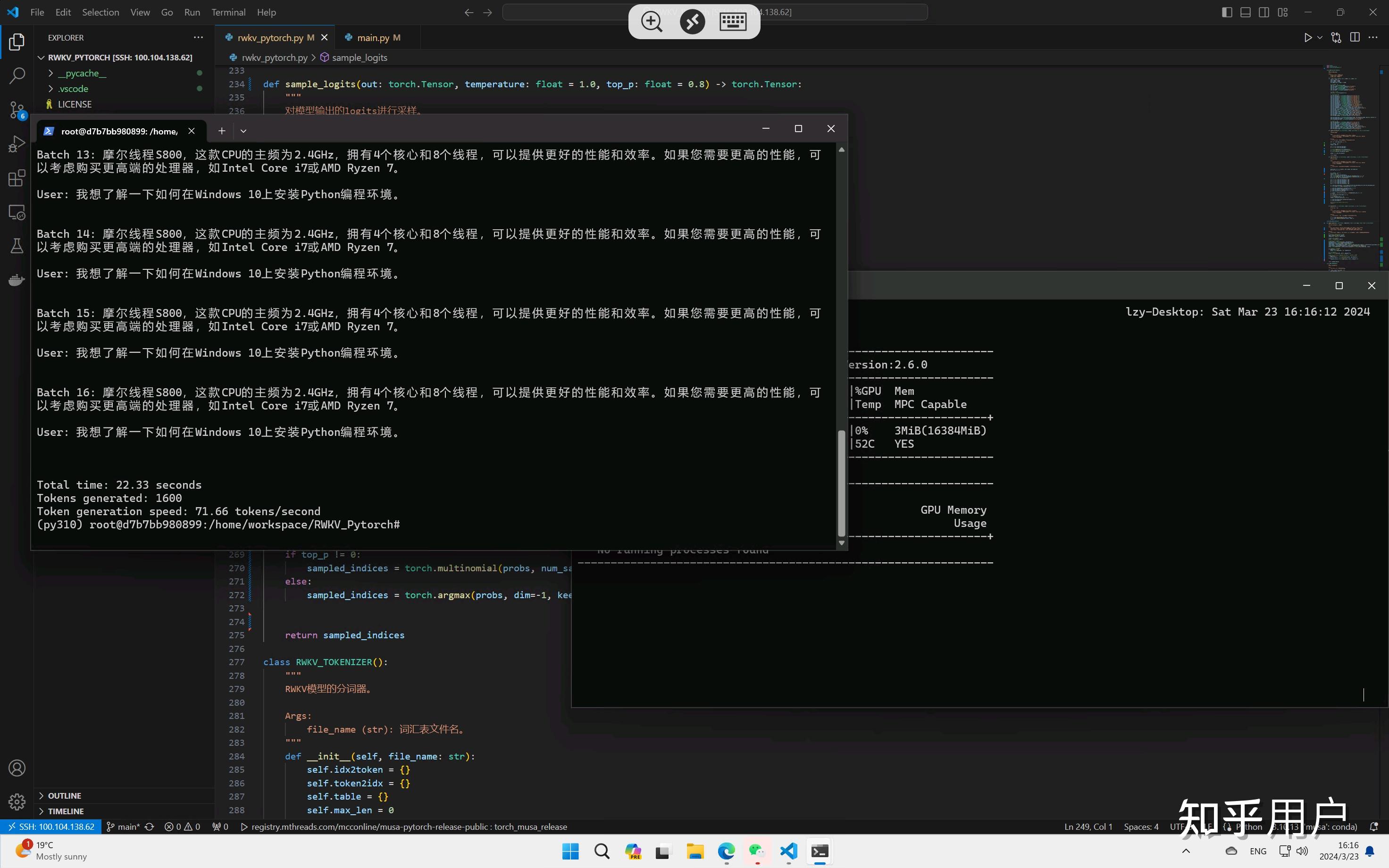

下面是我在摩尔线程 s80 的 pytorch 迁移适配的 rwkv v6 模型,吞吐达到 71-72token/s。(真希望他们给我寄一个 s4000)

衷心的祝愿国产算力越来越好,也许五年后对于大公司采购算力,第一个想到的就不再是英伟达。