总结一下昨天大会的核心内容

1,英伟达推出全球最强大芯片Blackwell

Blackwell的出现标志着在短短8年内,英伟达AI芯片的计算能力实现了提升1000倍的历史性成就

2016 年,“Pascal”芯片的计算能力仅为19 teraflops,而今天Blackwell的计算能力已经达到了 20000 teraflops

老黄在演讲中举例称,如果要训练一个1.8万亿参数量的GPT模型,需要8000张Hopper GPU,消耗15兆瓦的电力,连续跑上90天

但如果使用GB200 Blackwell GPU,只需要2000张,同样跑90天只消耗四分之一的电力

不只是训练,生成Token的成本也会随之显著降低

Blackwell由2080亿个晶体管组成,采用台积电4nm制程

支持多达10万亿参数的模型进行AI训练和实时大语言模型(LLM)推理

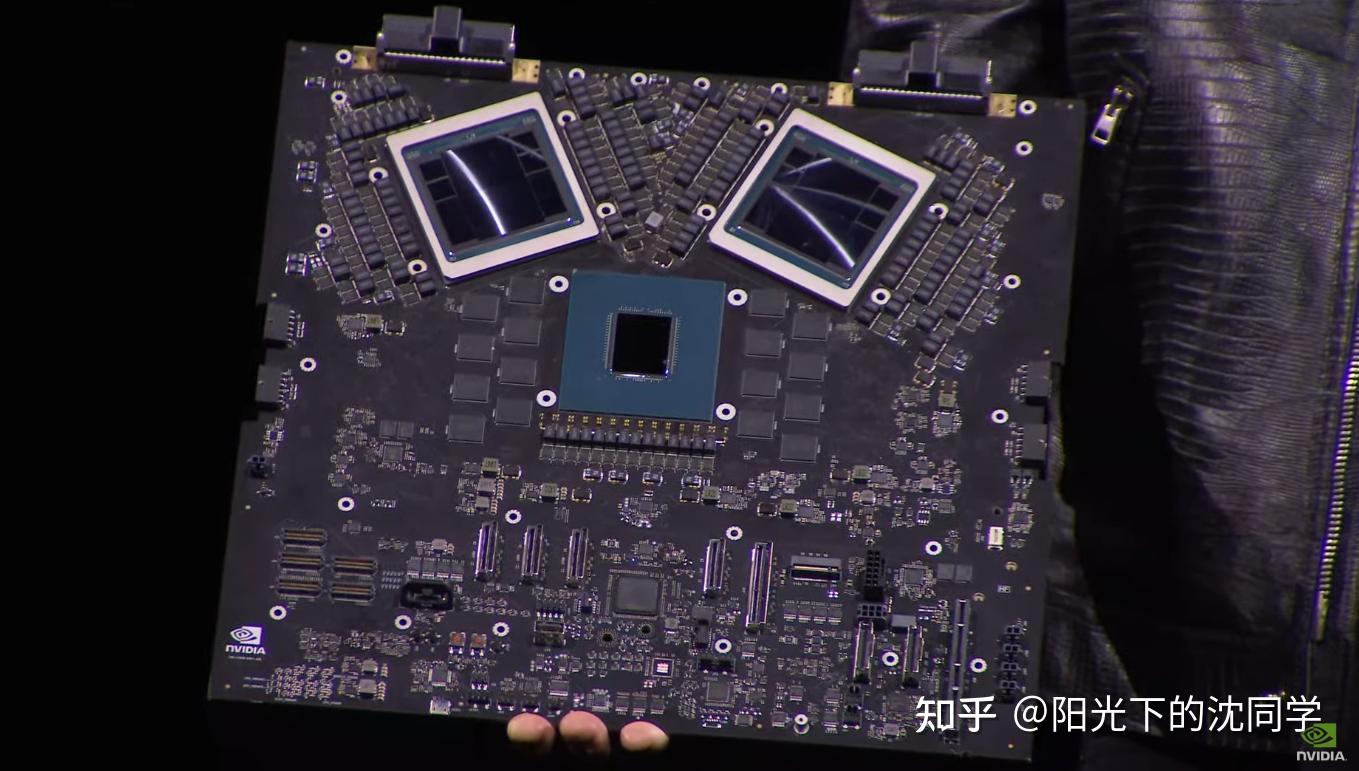

两个reticle极限GPU裸片将10TB/秒的芯片到芯片链路连接成单个统一的GPU

Blackwell 将通过新的4位浮点AI支持双倍的计算和模型大小推理能力

亚马逊、微软、谷歌和甲骨文在首批提供Blackwell支持的云服务商之列

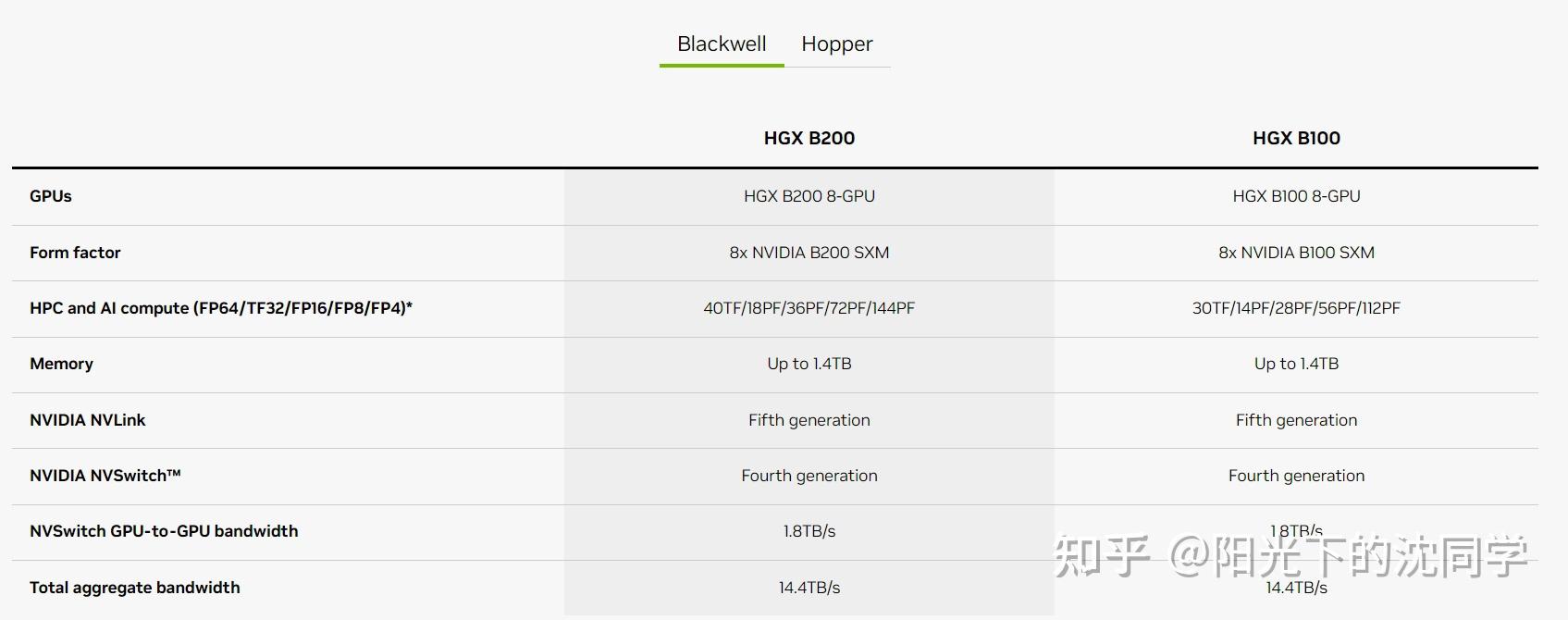

GB200 Grace Blackwell超级芯片,是由2个B200芯片(4个die)和Grace CPU组合而来

相较于H100,大语言模型性能提升30倍,同时能耗只有25分之一

2,英伟达推出AI项目Project GR00T助力人形机器人

3,台积电和Synopsys将采用英伟达计算光刻技术

4,英伟达推出新软件NIM,让用户更容易利用已有英伟达GPU进行AI推理

Blackwell就是英伟达最新推出的AI图形处理器【GPU】,今年可能下半年会发货

Blackwell平台能够在万亿参数级的大型语言模型(LLM)上构建和运行实时生成式 AI,而成本和能耗比前代改善25倍,这个是最大的看点

在拥有1750亿参数的GPT-3大模型基准测试中,GB200的性能是H100的7倍,训练速度是H100的4倍

B200GPU的重要进步之一,是采用了第二代Transformer引擎

它通过对每个神经元使用4位(20 petaflops FP4)而不是8位,直接将计算能力、带宽和模型参数规模翻了一倍

DGX Grace-Blackwell GB200:单个机架的计算能力超过1 Exaflop

黄仁勋交付给OpenAI的第一台DGX是0.17 Petaflops

GPT-4的1.8T参数可在2000个Blackwell上完成90天的训练

大概率这款芯片使用是192GB的HBM3E内存

英伟达最近还在投资AI制药

英国公司Relation Therapeutics开发了一个通过读取DNA以更好理解基因的大型语言模型,而这是创造新药的关键步骤

这个公司宣布获得3500万美元的新种子轮融资,由DCVC和NVIDIA(英伟达)的风险投资部门 NVentures 联合领投

英伟达还表示未来会重点投资通用机器人,让人形机器人能够将文本、语音、视频甚至现场演示作为输入那日,并对其进行处理,采取特定的通用操作

英伟达在大会上说的Project GR00T由英伟达Isaac 机器人平台工具的帮助下开发的

黄仁勋称,由Project GR00T平台提供支持的机器人将被设计为,通过观察人类行为来理解自然语言并模仿动作,使它们能快速学习协调性、灵活性和其他技能,从而适应现实世界并在与之互动,绝对不会产生机器人起义

英伟达投资的AI衍生行业非常多,很多企业都有英伟达的投资

英伟达在全面发力+投资AI

而且大家要知道,大多数的AI新创都奠基于英伟达的CUDA平台

英伟达的策略就是让平台衍生出庞大的软件生态,让后者难以突破

英伟达在其软件领域面临着巨大的进入壁垒,CUDA 是其中的重要组成部分,但即使CUDA的替代品出现,Nvidia 提供软件和库的方式也有利于他们构建一个非常可靠的生态系统

英伟达企业的护城河比想象的深

现在1GPU已经从仅仅比CP 更快地运行游戏的设备发展成为通用加速器

为全球的工作站、服务器和超级计算机提供动力

在三十年前,CPU和其他专用处理器几乎处理所有计算任务

在那个时代的显卡有助于加快 Windows和应用程序中2D形状的绘制速度,但没有其他用途

但现在GPU已经成为业界最具主导地位的芯片之一

机器学习和高性能计算严重依赖于GPU的处理能力

GPU的发展非常超预期

英伟达之前认为AMD,英特尔,华为、博通,高通,亚马逊和微软等云计算公司都是竞争对手

AMD在2022年6月,就推出CPU+GPU架构的Instinct MI300,正式进军AI训练端

在去年6月,又公布了MI300X与MI300A两款AI加速器

英特尔在去年年底首次展示了用于深度学习和大规模生成人工智能模型的Gaudi3系列AI 加速器,预计将于2024年上市

华为在去年8月正式发布了“昇腾910”AI芯片及“MindSpore”全场景AI计算框架

微软在2023年推出了两款定制设计的芯片和集成系统:针对人工智能 (AI) 任务和生成式 AI 进行优化的 Microsoft Azure Maia AI 加速器

亚马逊从2013年推出首颗Nitro1芯片至今,AWS是最先涉足自研芯片的云端厂商,已拥有网路芯片、伺服器芯片、人工智慧机器学习自研芯片3条产品线

英伟达需要不断的努力才能不被众多竞争对手超越,才能一直保持领先优势

不过从目前来看,英伟达的AI芯片暂时没有对手