对万亿参数模型的兴趣是什么?我们知道当今的许多用例,由于承诺增加以下能力,人们的兴趣正在增长:

- 自然语言处理任务,如翻译、问答、抽象和流利。

- 保持长期背景和对话能力。

- 结合语言、视觉和语音的多模式应用程序。

- 讲故事、诗歌生成和代码生成等创意应用程序。

- 科学应用,如蛋白质折叠预测和药物发现。

- 个性化,能够培养一致的个性并记住用户上下文。

好处很大,但训练和部署大型模型可能计算成本高昂且资源密集型。计算高效、具有成本效益和节能的系统,旨在提供实时推理,对于广泛部署至关重要。新的NVIDIA GB200 NVL72就是这样一个可以完成任务的系统。

为了说明,让我们考虑专家混合(MoE)模型。这些模型有助于在多个专家之间分配计算负载,并使用模型并行性和管道并行性在数千个GPU上进行训练。使系统更高效。

然而,新水平的并行计算、高速内存和高性能通信可以使GPU集群使技术挑战易于处理。NVIDIA GB200 NVL72机架规模架构实现了这一目标,我们将在以下帖子中详细介绍。

超大规模AI超级计算机的机架式设计

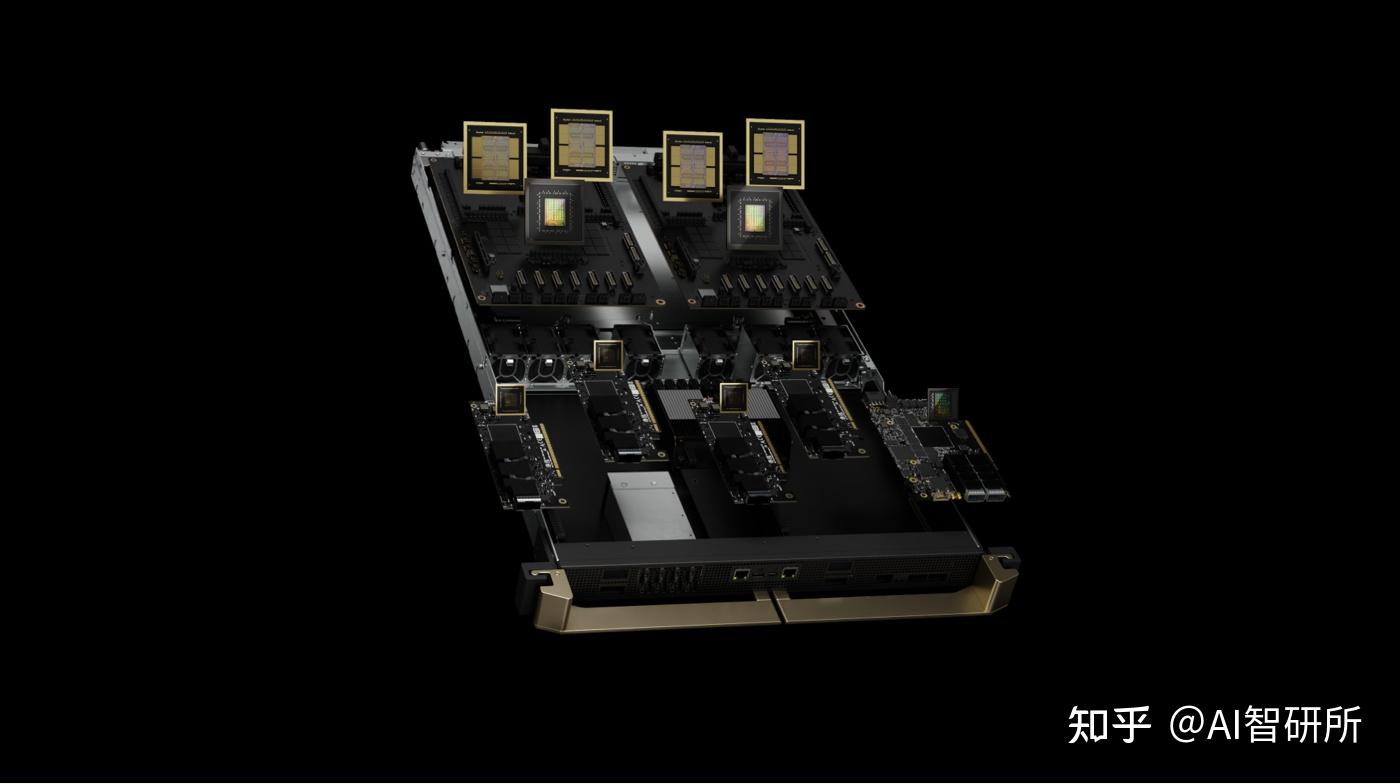

GB200 NVL72的核心是NVIDIA GB200 Grace Blackwell超级芯片。它将两个高性能的NVIDIA Blackwell Tensor Core GPU和NVIDIA Grace CPU与NVLink芯片到芯片(C2C)接口连接起来,该接口提供900 GB/s的双向带宽。使用NVLink-C2C,应用程序可以连贯地访问统一的内存空间。这简化了编程,并支持万亿参数LLM、多模态任务的变压器模型、大规模模拟模型和3D数据的生成模型的更大内存需求。

GB200计算托盘基于新的NVIDIA MGX设计。它包含两个Grace CPU和四个Blackwell GPU。GB200具有用于液体冷却的冷板和连接,PCIe gen 6支持高速联网,以及用于NVLink电缆盒的NVLink连接器。GB200计算托盘提供80 petaflops的AI性能和1.7 TB的快速内存。

最大的问题需要足够数量的突破性的Blackwell GPU才能高效并行工作,因此它们必须以高带宽和低延迟进行通信,并保持忙碌。

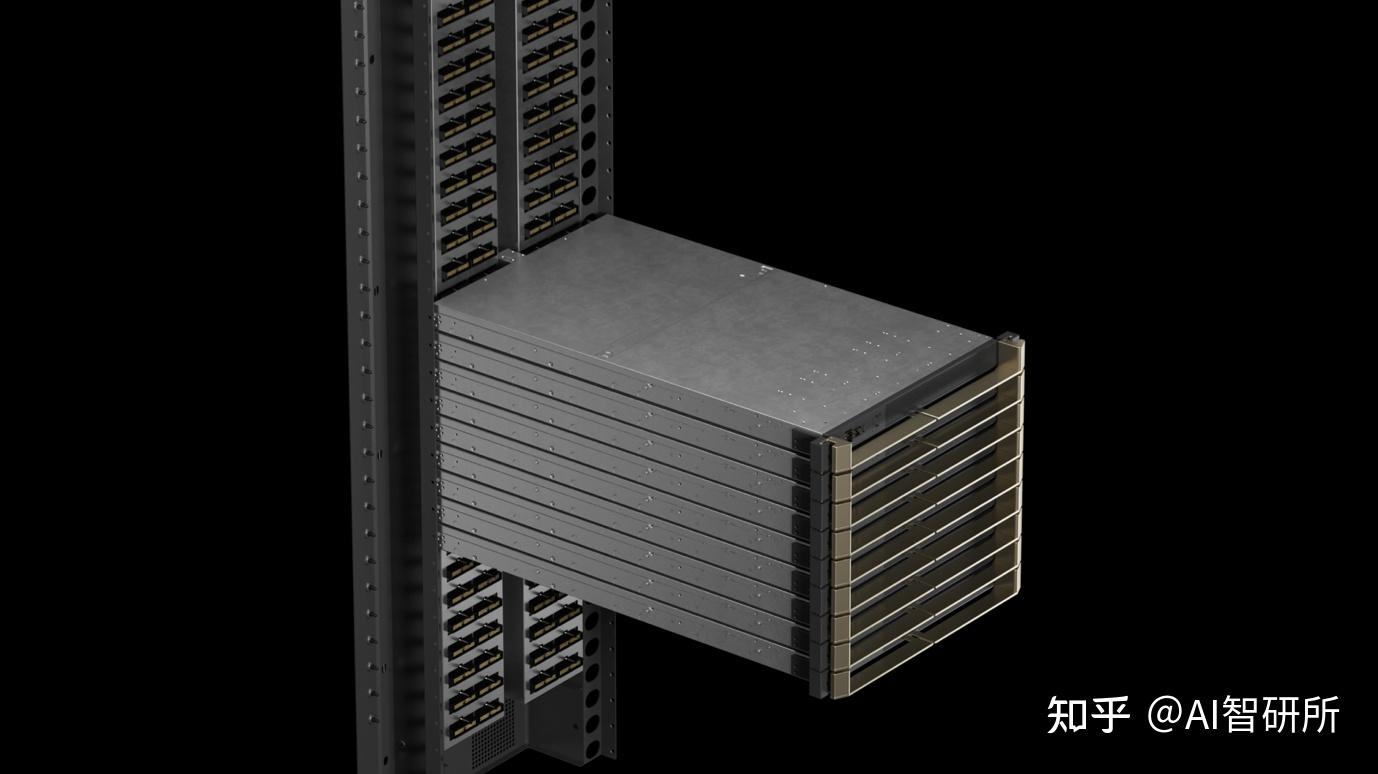

GB200 NVL72机架式系统使用带有9个NVLink交换机托盘的NVIDIA NVLink交换机系统以及连接GPU和交换机的电缆盒,促进了18个计算节点的并行模型效率。

NVIDIA GB200 NVL36和NVL72

GB200在NVLink域中支持36和72个GPU。每个机架根据MGX参考设计和NVLink交换机系统托管18个计算节点。它具有GB200 NVL36配置,一个机架中有36个GPU和18个单个GB200计算节点。GB200 NVL72在一个机架中配置了72个GPU和18个双GB200计算节点,或者在两个机架中配置了72个GPU,有18个单个GB200计算节点。

GB200 NVL72使用铜缆墨盒密集包装和互连GPU,以简化操作。它还使用液体冷却系统设计,降低成本和能耗降低25倍。

第五代NVLink和NVLink交换机系统

NVIDIA GB200 NVL72引入了第五代NVLink,它在一个NVLink域中连接了多达576个GPU,总带宽超过1 PB/s,内存超过240 TB。每个NVLink交换机托盘提供100 GB的144个NVLink端口,因此9个交换机在72个Blackwell GPU上完全连接18个NVLink端口中的每个端口。

革命性的每个GPU1.8 TB/s的双向吞吐量是PCIe Gen5的14倍,为当今最复杂的大型机型提供了无缝的高速通信。

几代人的NVLink

NVIDIA行业领先的高速低功耗SerDes创新推动了GPU到GPU通信的进步,从引入NVLink开始,以高速加速多GPU通信。NVLink GPU到GPU的带宽为1.8 TB/s,是PCIe带宽的14倍。第五代NVLink比2014年推出的第一代速度为160 GB/s快12倍。NVLink GPU到GPU通信有助于在AI和HPC中扩展多GPU性能。

GPU带宽的进步加上NVLink域大小的指数扩张,自2014年以来,将576 Blackwell GPU NVLink域的总带宽增加了900倍,达到1 PB/s。

用例和性能结果

GB200 NVL72的计算和通信能力是前所未有的,给AI和HPC带来了巨大的挑战。

人工智能培训

GB200包括一个更快的第二代变压器发动机,具有FP8精度。与相同数量的NVIDIA H100 GPU相比,它为GPT-MoE-1.8T等大型语言型号提供32k GB200 NVL72的训练性能快4倍。

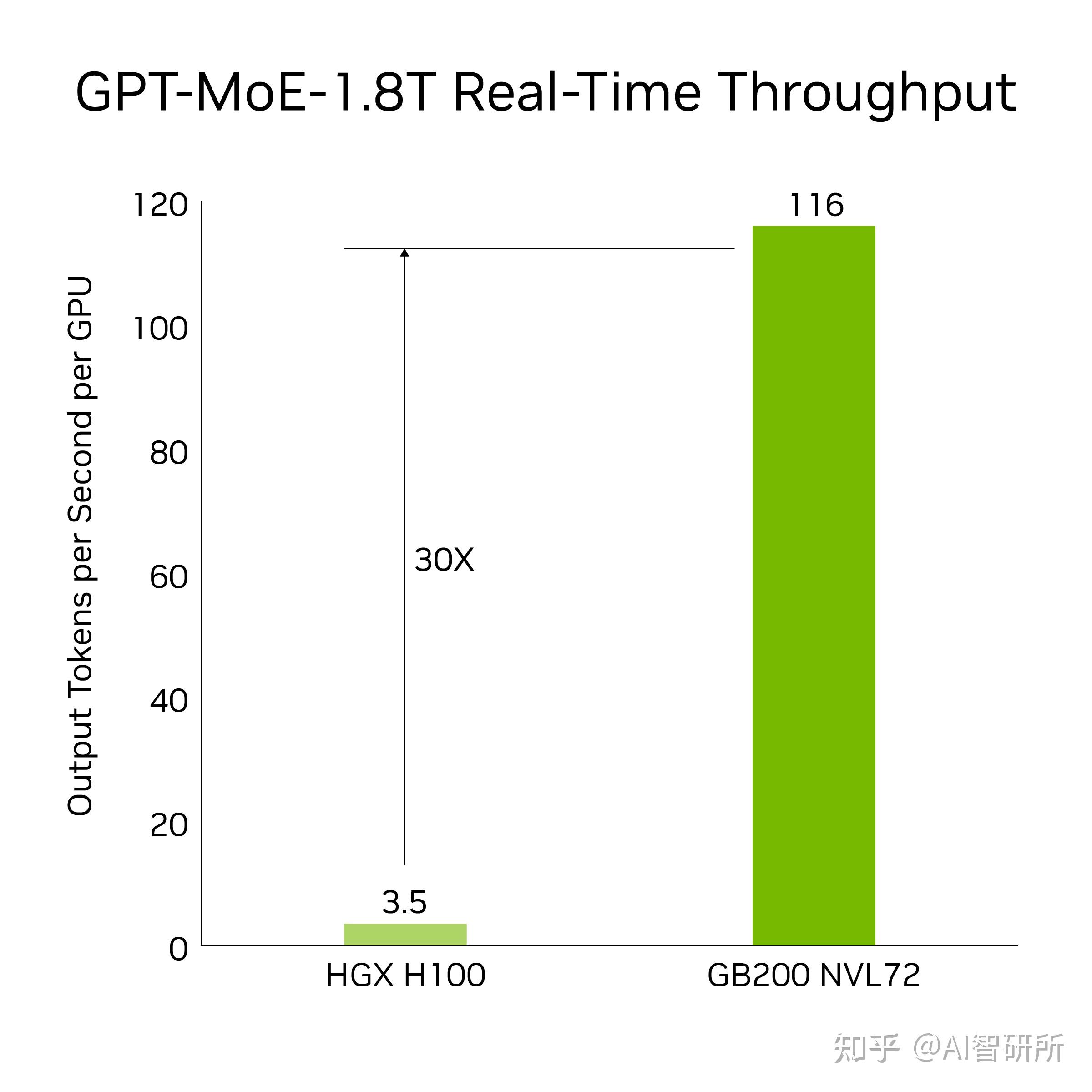

人工智能推断

GB200引入了尖端功能和第二代变压器发动机,可加速LLM推理工作负载。与上一代H100相比,它为1.8T参数GPT-MoE等资源密集型应用程序提供了30倍的加速。新一代张量核心使这一进步成为可能,该核心引入了FP4精度和第五代NVLink的许多优势

结果基于令牌到令牌延迟= 50毫秒;实时,第一个令牌延迟= 5,000毫秒;输入序列长度= 32,768;输出序列长度= 1,024输出,8x八向HGX H100风冷:400 GB IB网络与18 GB200超级芯片液冷:NVL36,每个GPU性能比较。预计性能可能会发生变化。

30倍的加速将64个NVIDIA Hopper GPU与使用GPT-MoE-1.8T的GB200 NVL72的32个Blackwell GPU相比,在8路NVLink和InfiniBand上进行了扩展。

数据处理

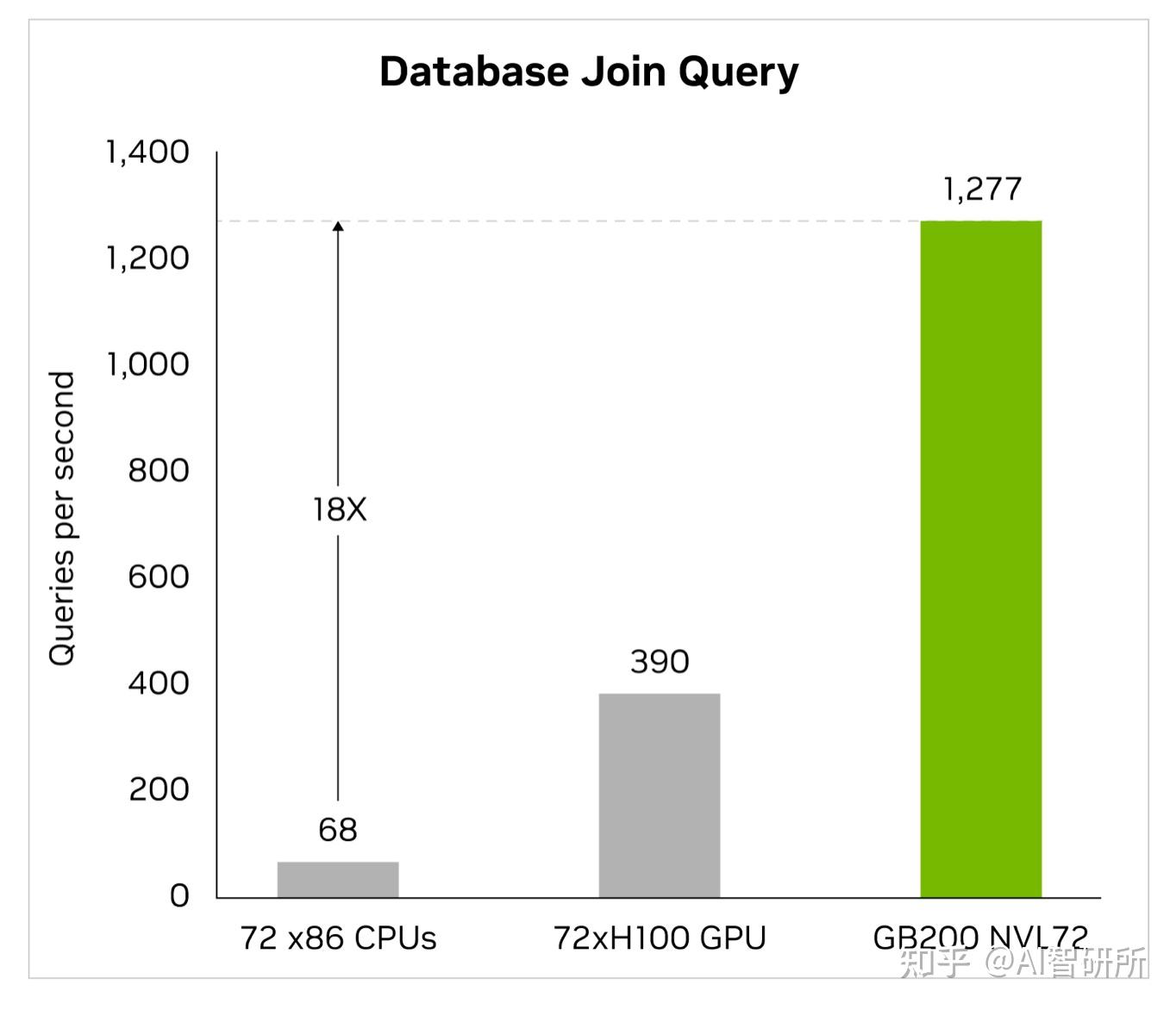

大数据分析帮助组织解锁洞察力并做出更明智的决策。组织持续大规模生成数据,并依靠各种压缩技术来缓解瓶颈并节省存储成本。为了在GPU上高效处理这些数据集,Blackwell架构引入了硬件解压缩引擎,可以原生大规模解压缩压缩数据,并加快端到端分析管道的速度。解压缩引擎原生支持使用LZ4、Deflate和Snappy压缩格式解压缩数据。

解压引擎加快了内存绑定内核操作。它提供高达800 GB/s的性能,并使Grace Blackwell的性能比CPU(Sapphire Rapids)快18倍,比NVIDIA H100 Tensor Core GPU快6倍,用于查询基准测试。

凭借惊人的8 TB/s高内存带宽和Grace CPU高速NVlink-Chip-to-Chip(C2C),该引擎加快了数据库查询的整个过程。这导致数据分析和数据科学用例的一流性能。这使组织能够快速获得见解,同时降低成本。

基于物理的模拟

基于物理的模拟仍然是产品设计和开发的支柱。从飞机和火车到桥梁、硅芯片,甚至药品,通过模拟测试和改进产品可以节省数十亿美元。

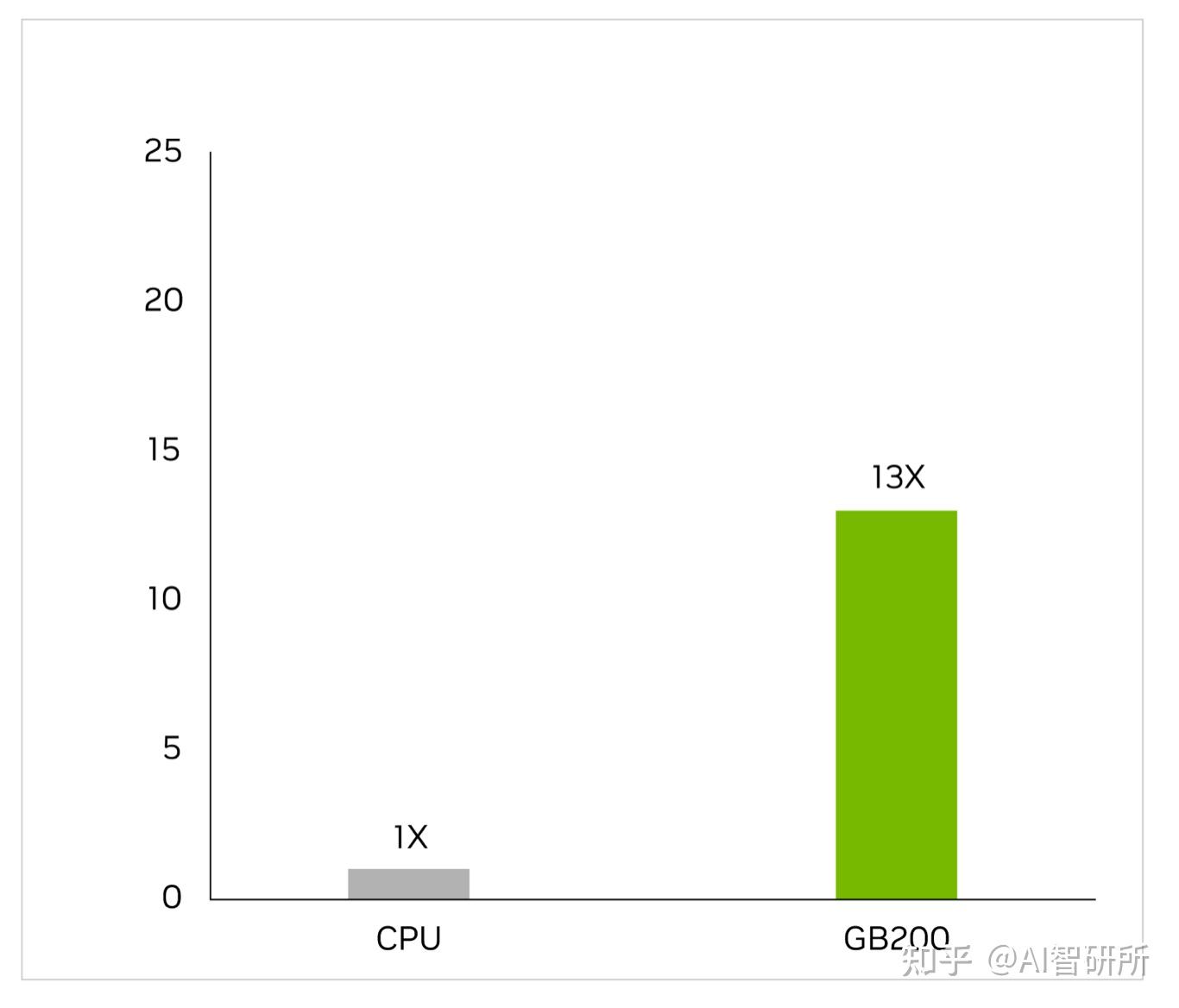

特定于应用程序的集成电路几乎完全在CPU上设计,在漫长而复杂的工作流程中,包括用于识别电压和电流的模拟分析。Cadence SpectreX模拟器是求解器的一个例子。下图显示,SpectreX在GB200上运行速度比x86 CPU快13倍。

Cadence SpectreX(香料模拟器)| CPU:16核AMD Milan 75F3数据集:KeithC Design TSMC N5 | GB200的性能预测可能会发生变化

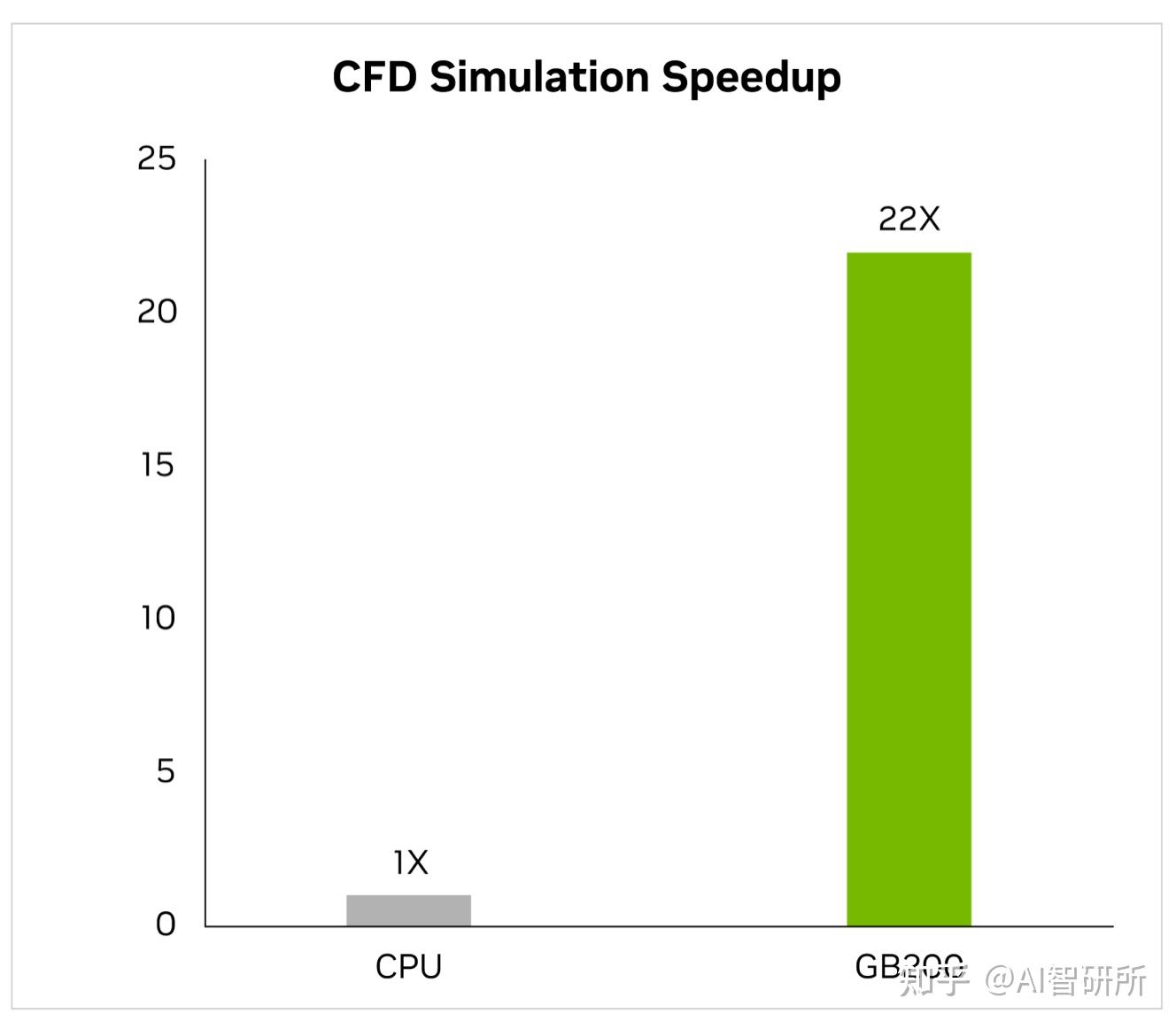

在过去的两年里,该行业越来越多地转向GPU加速计算流体动力学(CFD)作为关键工具。工程师和设备设计师使用它来研究和预测他们设计的行为。Cadence Fidelity,一个大型涡流模拟器(LES)在GB200上运行模拟的速度比x86 CPU快22倍。

Cadence Fidelity(LES CFD Solver)| CPU:16核AMD Milan 75F3数据集:GearPump 2M电池|GB200的性能预测可能会发生变化

我们期待在GB200 NVL72上探索Cadence Fidelity的可能性。凭借并行可扩展性和每个机架30 TB的内存,我们的目标是捕获以前从未捕获过的流细节。