英伟达在2024年GTC大会上发布的Blackwell架构GPU和DGX GB200服务器无疑是人工智能和深度学习领域的一次重大突破。

Blackwell架构GPU的推出展现了英伟达在芯片设计和制造上的深厚实力。这款GPU集成了高达2080亿个晶体管,采用了台积电4纳米制程技术,其AI运算性能在FP8和NEWFP6上可达到20 petaflops,是前一代Hopper架构的2.5倍。在NEWFP4上,性能更是达到了惊人的40 petaflops,是Hopper架构的5倍。这样的性能提升使得Blackwell架构GPU能够应对更大规模、更复杂的数据处理和计算任务,为深度学习、自然语言处理等领域的研究和应用提供了强大的硬件支持。

DGX GB200服务器的发布更是将英伟达的AI计算能力推向了新的高度。这款服务器集成了两个Blackwell架构GPU和一个GraceCPU,性能较其前身H100提升了7倍,训练速度达到H100的4倍。更为引人注目的是,DGX GB200的推理性能相比H100提升了45倍,使其能够轻松应对万亿级参数的大模型。同时,DGX GB200还使用了第五代NVLink和BlueField3技术,进一步提升了数据传输效率和安全性。

在演讲中,黄仁勋多次提到AI推理,这也反映了英伟达对于AI推理领域的重视和投入。随着深度学习技术的不断发展,AI推理已经成为许多应用场景中的关键环节。英伟达通过不断提升其硬件产品的推理性能,为AI应用的落地提供了坚实的支持。

英伟达在2024年GTC大会上发布的Blackwell架构GPU和DGX GB200服务器无疑为人工智能和深度学习领域的发展注入了新的活力。这些产品不仅在性能上取得了显著的突破,而且在应用上也展现出了广阔的前景。相信在未来,英伟达将继续引领AI计算领域的发展潮流,为人工智能技术的普及和应用做出更大的贡献。

一文看懂英伟达A100、A800、H100、H800各个版本有什么区别? - 知乎 (zhihu.com)

2023第一性原理科研服务器、量化计算平台推荐 - 知乎 (zhihu.com)

Llama-2 LLM各个版本GPU服务器的配置要求是什么? - 知乎 (zhihu.com) 人工智能训练与推理工作站、服务器、集群硬件配置推荐

整理了一些深度学习,人工智能方面的资料,可以看看

机器学习、深度学习和强化学习的关系和区别是什么? - 知乎 (zhihu.com)

人工智能 (Artificial Intelligence, AI)主要应用领域和三种形态:弱人工智能、强人工智能和超级人工智能。

买硬件服务器划算还是租云服务器划算? - 知乎 (zhihu.com)

深度学习机器学习知识点全面总结 - 知乎 (zhihu.com)

自学机器学习、深度学习、人工智能的网站看这里 - 知乎 (zhihu.com)

2023年深度学习GPU服务器配置推荐参考(3) - 知乎 (zhihu.com)

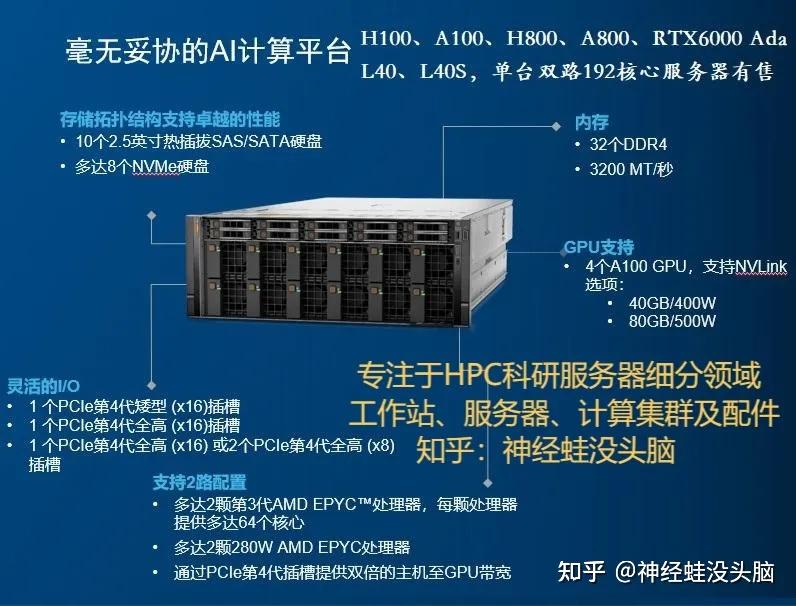

多年来一直专注于科学计算服务器,入围政采平台,H100、A100、H800、A800、L40、L40S、RTX6000 Ada,RTX A6000,单台双路256核心服务器等。