一、手机大模型是不是伪需求?

在回答题主这个问题之前,我想先提出另一个疑问:

——我们真的需要一个部署在手机上的大模型吗?

在我们讨论大模型是否会彻底改变手机智能系统前,有一个不可忽略的事实是,目前市面上最火的几个大模型,早就已经推出了手机版的 App,乃至还有基于这些大模型的衍生应用。

这些 App 虽然不是在本地部署的,但远程调用云端的大模型这样又不会对手机性能造成额外的负担,又能拥有理论上更高的算力从而实现更强的 AI 性能。

既然如此,那岂不是没有必要费心费力的投入大量资源资金自研这个能部署在手机上的大模型了?手机上这些大模型的 App,以及各种基于大模型能力衍生的其他应用就能让手机也用上大模型的 AI 能力了?

事情没那么简单,这些大模型高昂的算力成本和流量成本其实还没看到能收回来的可能性,现阶段用户每使用一次都在亏钱,未来的收费上涨甚至偷偷阉割能力,这些都是极有可能发生 or 正在发生的事情。

即便是厂商能够接受前期的烧钱投入,但是随着计算需求的增加,大模型的云端算力必然难以承载如此庞大的计算量,从而导致单次计算的时效和成本都急剧增加。

所以分配一定量的计算需求到终端,依靠终端的算力解决这一问题才是未来的趋势。

二、云端+终端的混合部署方式,可能是当下最有实际意义的解决方案。

云端和终端协同工作,根据不同的场景和计算需求分配 AI 计算的工作负载,以更高效地利用算力资源来为用户提供更好的体验。

就像我们平时玩的 FPS 游戏,往往也是这样本地计算和云端服务器的协同工作才得意确保游戏的公平、流畅。

本地客户端负责处理玩家的输入、渲染游戏世界、以及执行本地游戏逻辑,例如玩家的移动、开火等动作。游戏服务器则负责协调游戏世界中所有玩家的状态和事件,以确保游戏的一致性。

包括我们人类自己,也是中枢神经和外周神经来协同的,一些低级反射并不受大脑控制。

除此之外,单纯部署于云端的大模型本身也有一些问题有待解决。

如果你用过 ChatGPT 或者其他的一些大模型,你会发现它们其实有很多局限,比如「失忆」,还有「幻觉」。

而端侧的部署则是突破大模型的「失忆」和「幻觉」最有效的方式之一,因为历史数据只来源于于用户一个人。

三、云不了解用户,但终端设备了解。

如果大模型能够在终端设备上训练、调整,那它作为个人的专属 AI 将非常强大,因为它只为用户一个人服务,完全了解用户的喜好、需求。相对来说,即便记忆瓶颈存在,也能降低失忆对任务的影响,产生幻觉的矛盾概率也会更低。

而最了解用户的终端是什么?对于大部分人来说,一定是手机。

根据商业智能数据服务商 QuestMobile 之前发布的《中国移动互联网 2023 年上半年大报告》数据显示,截止到 2023 年 6 月,月人均单日使用时长达到7.2小时,月人均单日使用次数达到116.3次……

无论这些年来占据手机最久使用时长的 App 如何风水轮流转,手机厂商永远稳坐钓鱼台。

所以手机厂商做大模型这件事,天经地义,而且相比其他科技公司在 to C 的应用层上更具优势。

我们现在可以回答开头的疑问了——我们真的需要一个部署在手机上的大模型。

相比其他以 App 形式出现在手机上的大模型,融入手机系统的大模型可以改变整个智能手机的使用方式,让其他的 App 也在一定程度上拥有大模型的能力。

这对于智能手机系统来说甚至不亚于猿人第一次学会使用工具,虽然距离进化成人类还有相当远的距离,但是其意义不言自明,手机系统部署大模型后,所谓的「智能手机」在未来也将拥有真正的「智能」。

四、手机厂商都在抢着接入人工智能

根据目前所流出来的 OriginOS4 的大模型能力来看,vivo 手机无疑是动作最快的那一波厂商。

vivo 对于人工智能的布局其实相当早,早到我们早就已经在它的手机上对这些智慧能力习以为常。

比如我每次想找应用时的「应用建议」,基本上我此时此刻需要的 App 95% 的概率会出现在这里。

再比如相册中的「智能分类」,即便我相册中有近万张图片,它也能在我疏于整理时将画面中的内容精细地分门别类,细化到不同题材内容。

还有 vivo 的影像算法,Jovi 的智慧建议,后台的不公平调度等等等等,这些实际上都是人工智能的实际应用,手机系统的好用与否离不开这些润物细无声的智慧能力。

这些都是源起于 2017 年 vivo 人工智能全球研究院的成立,再这之后还有图谱研究院,直到今天 vivo 一直有千人以上的团队在做相关的技术研发。

最能量化这五年多以来成果的一定是一个针对大模型的评估排行榜,毕竟研发时间多久对于用户而言是没有意义的,而能力的强弱则是直接影响到体验的好坏。性能强大才是好用的前提。

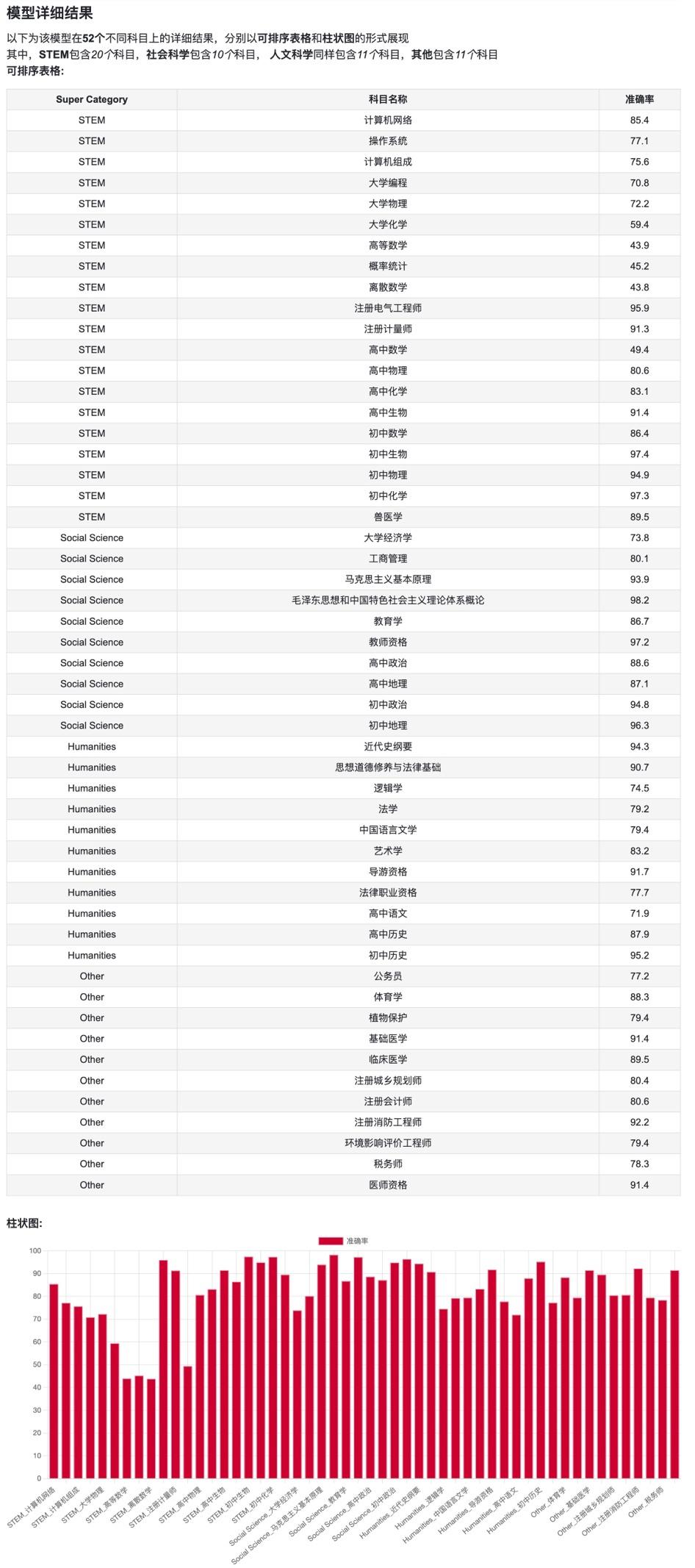

多个排行榜中我觉得对于国内用户最有意义的还是 C-Eval,这是由清华、上交联合爱丁堡大学合作构建的面向中文模型的综合性多层次多学科评估套件,其中包含了包含了 13948 个多项选择题,涵盖了 52 个不同的学科和四个难度级别。

而 vivo 自研的 LLM-vivoLM 在受限访问模型中排行第一。

https://cevalbenchmark.com/static/leaderboard_zh.html(C-Eval 排行榜链接)

也就是说,这场专门针对大模型的考试中,vivo 自研的大模型考了最高分(受限访问中的最高分),具体各个科目的分数如下:

(原链接:模型详细结果 | C-Eval: 一个适用于大语言模型的多层次多学科中文评估套件 (cevalbenchmark.com))

仔细看这些科目的分数,如果把 vivo 大模型当成一个人来看待的话,他应该是除了数学成绩稍弱之外,其他科目门门是 A+ 的全才,理科、工科、文科样样精通。

所以实际上 OriginOS4 搭载的 vivo 自研大模型是在手机里塞进来一个多领域的专家,最重要的是,这名「专家」的理解能力也远超以往,这就给我们很大的想象空间了。

五、系统接入大模型会带来什么变化?

最直观最容易预见到的一个场景就是手机的智能系统会变的更「聪明」。

现阶段的语音助手虽然也能执行一些相对不那么「精确」的「模糊指令」,但是「我好像听不明白」这种无法理解用户需求的回答还是会频频出现。它明明是「人工智能」,但是实际用起来却经常听不懂人话,理解不了一些更复杂的需求。

等 OriginOS4 接入 vivo 大模型后,可能 Jovi Copilot 真的能成为我们的一个私人助理,就像钢铁侠的J.A.R.V.I.S. 一样。

比如我想在开周会前输出一个自己的工作总结以便会上分享,我可以直接让 Jovi 帮我写一篇出来,可能比自己写的还好,毕竟它的总结归纳能力要比我强的多。

或者我身体有不适的时候,也可以跟 Jovi 描述一下自己的感受,让它做一个预诊,帮忙判断是什么情况,需要去哪个科室问诊,顺便帮我找好医院预约一个挂号。

如果我遇到一些报税、发票上的问题,我也能在满头问号的情况下向 Jovi 咨询一下我所面临的税务问题,履行纳税的公民义务。

有一个想找的文件想不起来在哪存储也不记得文件名时,向 Jovi 描述它的特征或者内容中的关键词,都能够快速定位其所在的位置。

也许就连定闹钟也变成了一整套早晨场景的布置,直接叫 Jovi 在工作日的早上 8:00 叫你起床,如果想赖床就再过几分钟叫一次,在用户拿起手机之后开始播报天气并提供穿衣建议……

就连不太会用手机的年长的人们也能在 Jovi 的教学下一步步无障碍地完成手机的各种操作,诈骗电话也能直接帮用户挂断并拉黑报警。

这些都是很容易想到的一些场景,也是大模型接入后轻松能实现的事情。

但是能做到回应和做到「精准的回应」乃至「快速又精准的回应」在体验上是有着巨大的区别的。

如果说这些需求都由类 GPT 的 1750 亿大模型来进行运算的话,算上网络通信和运算时间,它的整个响应流程可能要到几秒后才能给出回应,我觉得这样的速度不能算是「体验好」的,因为等的太久了。

六、All in One 的 One 可以不止一个大模型

vivo 用了一个很巧妙的办法解决了这个问题,vivo 带来了 5 个大模型,有 10 亿,有 70 亿,有 660 亿,有1300 亿,还有 1750 亿。其中 10 亿、70 亿应该是能部署在本地的,另外三个参数量更高的则是云端。

这和处理器的大中小核架构设计有异曲同工之妙,不同的模型对应处理不同的任务,以达到计算资源和计算性能的均衡和最优。

对响应时间要求高,但是性能要求低的简单任务,比如输入法的单词联想,用小一点的模型在本地调用运算就够了。反之,性能要求更高的复杂任务,一般来说响应时间也没那么高要求,比如 AI 图片的绘制生成,可能就还是要调用云端的大模型来进行运算了。

我觉得比起所有东西都用一个大模型来处理,这种才能算是真正的 All in One。只不过这个 One 不是单一的大模型,而是五个模型的集合体。

也就是说,vivo 这五个大模型的集合体或许会重塑我们的智能手机系统。这样想象空间就非常大了,现在 OriginOS4 仅是透露出来的功能就让人眼前一亮,等到正式发布时不知道vivo 还会带来什么惊喜。

七、手机大模型的内卷正在加速

客观来看,手机大模型的 iPhone 时刻确实还并没有真正到来,iPhone 4 之所以改变世界,除了领先于时代的设计和当时最优的软件生态之外,别忘了还有那个 45nm 制程的 A4 处理器,再杀手级的应用也要依托于足够强大的性能。

现在手机端并不是不能用百亿级以上的大模型,算力是足够的,但是功耗对于手机来说是消耗不起的,不能说为了用大模型让手机负载和玩原神的时候差不多,这可能就得不偿失了。

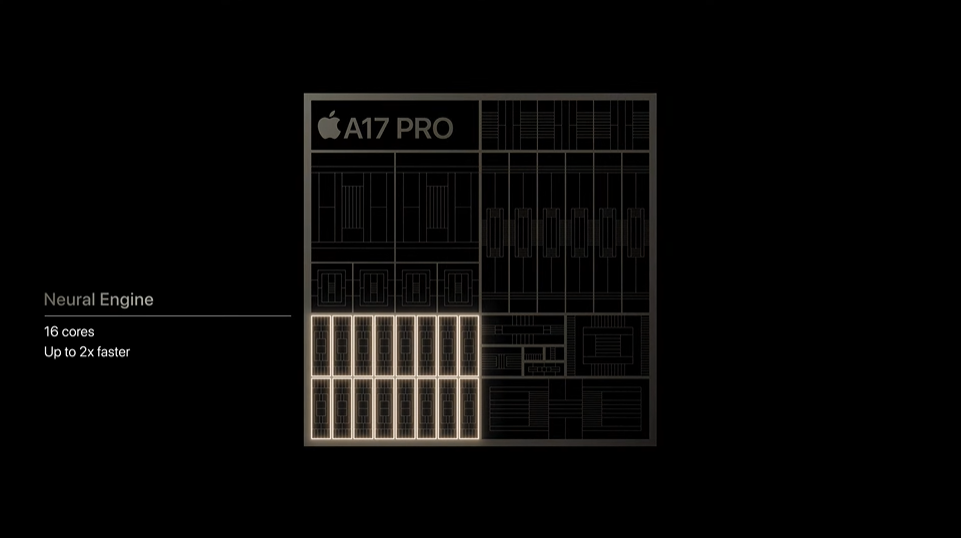

不过好消息是未来主流的 SoC 都会在 AI 性能上进行针对性加强,高通、联发科的芯片已经连续多年积极推进 AI 算力增强,也推出了本地部署大模型的解决方案,前不久苹果刚发布的 A17 Pro 也加入了巨量的晶体管分配给 NPU,每秒可执行最高达 35 万亿次操作(35 TOPS 算力)。

虽然现阶段能够实现在手机端侧部署的只是特定的大模型,但是随着未来算力的升级,技术的不断成熟,手机端能够部署的模型数量、模态类型甚至部署的形式都会加速发展。

在智能手机系统中的落地会极快的加速手机大模型 iPhone 时刻的到来,毕竟再好的创新只有每个人都能用上才能发挥出它最大的意义。

正如 iPhone 4 的火爆不是因为它有多领先于时代,而是因为它能玩水果忍者。