Meta 发布 Llama2 模型,与微软高通展开合作,哪些细节值得关注,这一大模型会有什么作用?

(财联社)时隔半年后,Meta AI在周二发布了最新一代开源大模型Llama 2。相较于今年2月发布的Llama 1,训练所用的token翻了一倍至2万亿,同时...

- 8 个点赞 👍

整个模型全量在手机上以有意义的速度运行,这个肯定是不现实的。但是使用类似于LoRA的方法让每个用户都可以用上自己的个性化模型,并兼顾个人隐私防护,这个是有可能实现的——例如可以在用户自己的手机上计算LoRA的部分,然后base模型在服务器上计算。

发布于 2023-07-21 14:38・IP 属地北京查看全文>>

到处挖坑蒋玉成 - 0 个点赞 👍

一天前, Meta(Facebook)发布了大语言模型Llama 2。

它最大的亮点不是多大参数或多强的能力,而是不再犹抱琵琶半遮面,向所有开发和商业用途开源!另外,还结盟了对手Open AI的盟友微软作为优选伙伴, 直捣OpenAI最大的商业用户老巢。

走封闭路线的OpenAI商业化的脚跟还没站稳,Meta就掀翻了牌桌。

对中国的创业者和投资人,这到底意味着什么?做什么、怎么做?

开源解放生产力

开源绝不仅仅是免费那么简单,开发者省去了昂贵的大语言模型使用成本,使用者免除了向OpenAI交“使用税”。

在此之前,随着AIGC领导者OpenAI的版本升级,无论使用或是开发,都要直接交费,就像用Office365要交费,天经地义。尤其对于利用LLM(大语言模型)提供服务的商家,这笔费用都是减不掉的成本。如今,人们多了一个选择,如同Office365免费用。

在Llama 2商用免费后,无数开发者可以在Llama上开发基础设施工具和应用,我们一下看到了繁荣的曙光。

信息化、数字化之后,产业AI化的革命会来得更迅猛。

Llama 2为大模型参与者省了多少钱

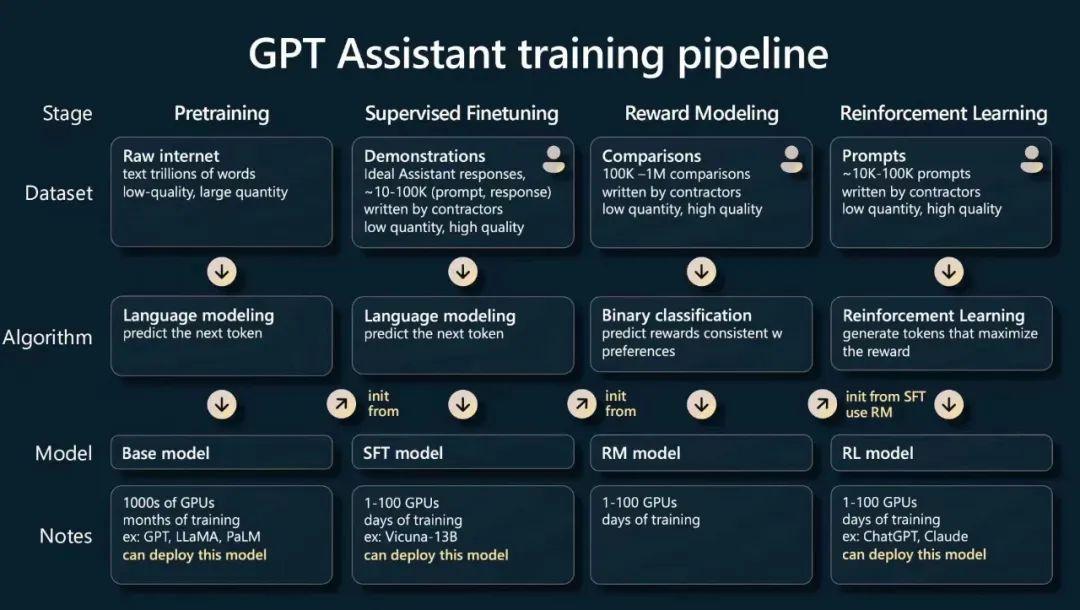

国内有很多有实力的商家,在考虑开发自用模型(俗称甲方模型)。现在可以直接用开放模型做自己的甲方模型了,而且还是一个能力超群的大模型。这里有一个经典图,说明了Llama 2为平台开发者节约了为开发模型要付出的99%算力成本。

图中大模型训练的四大步骤,pre-training, supervised fine tuning, reward modeling和reinforcement learning, 第一步堪称鸿沟,粗算下来,算力时长占全部四个步骤的99%以上。这个比例,就是Llama 2 的开放为自己准备拥有大模型的人节约的算力成本。

换句话说,Llama 2为中国训练大模型的企业跨越了算力鸿沟。

领导者走封闭路线并靠此获利,如同苹果手机。追随者为了生存毫不犹豫地选择开放,如同安卓。Llama 2的开放只是带了个头,Cohere、Anthropic的开放平台同样值得期待 - 再后进者要想方设法取悦开发者,提供更独特的价值。

这,就是开放的商业世界的beauty。

创业者做什么

“to be(B), or not to be(B),是莎士比亚《王子复仇记》的一句著名台词,经常被我们用来形容AIGC创业者的选择。toC毫无疑问大厂占据了大机会,然而LLM智力的涌现,给无数toB服务带来了机会。节约上面说的99%算力成本后,企业可以训练自己的大模型。万事数为先,数据必须是私有的,所以模型也必须是私有的,否则丢了模型比丢了数据更恐怖。

上周和一个大厂模型参与者交流,大家明显看到只有500强段位的企业有能力训练自己的模型。99%以上需要模型的企业需要大量的模型服务者,为企业量身定做自己的模型。

我们曾经说过,得人才者得模型,得模型者得天下(可参考文章:AI奇点爆发:“得模型者得天下,得人才者得模型”), 现在再加一句,产品制胜。把模型训练、服务产品化, 靠产品化实现规模化、低成本,是AIGC创业的王道。

模型是生产力,AI化是趋势。这一轮产业进步,新贵肯定不止四小龙,产生数十个上市公司不足为怪。

Llama 2帮助节省了99%的训练模型算力时长,99%的企业需要第三方模型服务,这两个99%,就是创业的机会。

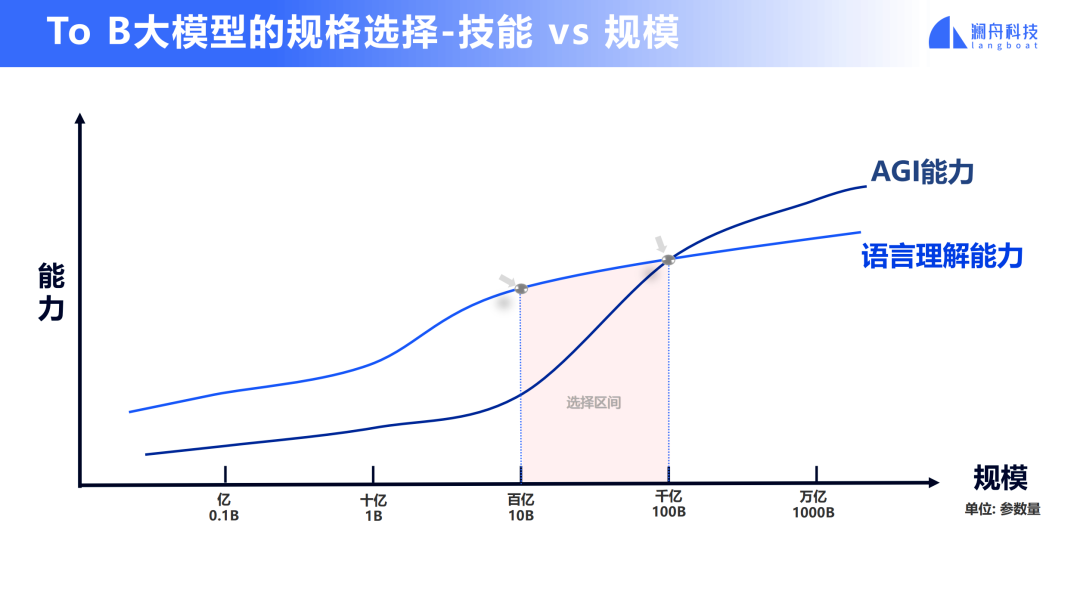

再看“周明曲线”

5月27日,合肥,中国科学技术大学校园里,阿尔法公社参与主办的科大校友创业投资论坛ChatGPT全球论坛上,科大博导,著名NLP专家、澜舟科技创始人周明教授抛出了一个曲线,经我提议,当场被科大理工男们命名为“周明曲线”。(可参考文章:几大模型同场,院士辞职创业,近7万人在线的科大校友大模型创业投资论坛)

这条曲线说明大多数垂类模型根本不需要175B的大参数,当然也不需要那么多的GPU算力。这让大家想起了本科物理课某些超级牛的定理,简单而又深刻。

Llama 2也只有区区13B参数,它的发布和开源,说明打仗何须核武器,只要有了会搞算法、练模型的人,就占有了商机。

为什么是个大机会

过往的SaaS市场在中国发展得磕磕绊绊,究其原因是客户付费愿望不强,导致超大型客户主导了市场话语权,创业公司能生存、难长大。AI化的根本是模型的比拼,不断喂数据、不断优化才是王道。当然,模型持续使用中的算力需求也是工业界收入机会的纯增量,如同Snowflake有一大笔收入是转售Amazon和微软Azure云服务一样,这一轮AIGC既有持续产品改进的收入机会,又平添了一份云算力整合服务的收入机会,都是增量。

哪些服务是机会

三层架构:大模型、基础设施类工具和应用。传统软件服务商、SaaS服务商既面临增量机会,又有被“掀翻”的风险。懂企业服务的AI创新者机会更多。此处不赘述,我们不久另外做讨论。Alpha Founders Club也会组织专题讨论(可参考文章:AIGC在中国还有哪些创业机会?院士创业者、天使投资人这样说|Alpha Founders Club),欢迎创业者们找我们交流。

BP投递邮箱:[email protected]

大模型的开放之路,让人们看到了产业AI化的曙光。

本文作者:阿尔法公社创始合伙人许四清。

关于阿尔法公社

发布于 2023-07-20 11:16・IP 属地北京查看全文>>

阿尔法公社 - 0 个点赞 👍

Meta发布开源模型LLaMA 2很正常,但是真正耐人寻味的是和微软与高通的合作。

微软是在两头下注。一边微软投资了闭源的openAI,另一边也并不排斥开源社区的成果。微软这一招实在是高。

微软宣布,和Meta的开源LLaMA 2进行了深度融合,自家旗下的云服务Azure将提供LLaMA的部署,并提供LLaMA运行在Windows系统下的便利。[1]

- 云服务自然不必说,Azure作为云服务提供商,肯定是兼容并收,愿意在我的云上跑模型自然来者不拒。

- 微软将提供LLaMA 2在Windows系统下的本地运行,有可能带来AI本地部署的热潮。现在本地部署大语言模型,需要用户自行配置环境,非常麻烦。但是如果Windows系统提供更好的原生支持,比如做到一键部署,那就方便太多了。

和高通的合作,指向就更明确了——让AI在手机上也能跑起来。

现有手机的算力,想在用户设备端侧部署大语言模型还有一定的困难,至少现有算力翻倍才行。至于说手机上目前配备了这么多NPU神经网络处理器,却只能用来拍照做优化,实在是大材小用。AI运行需要大量的张量计算,正好把NPU给用起来。

参考

发布于 2023-07-21 11:41・IP 属地甘肃真诚赞赏,手留余香还没有人赞赏,快来当第一个赞赏的人吧!查看全文>>

chengxd 达达