有机会,但是这十来年不一定。

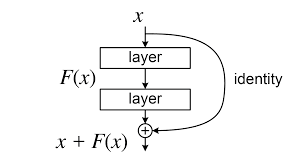

Deep Residual Learning for Image Recognition

这篇文章提到的ResNet结构,并不多是少有的从CNN时代穿透到Transformer,甚至到RWKV,Mamba等变种的基础模型的架构设计。

它可以认为是 Backward Propagation级别的设计,没有它,现阶段的任何一个神经网络可能都过不了二十层。

可以这么说:

FFN 代表了知识

QKV代表了查询知识

而 ResNet就是信息流通的通道,从QKV到FFN必须要有ResNet才能完成信息的流通!

尽管它实在是太简单了,但是它足够的优秀不是吗?

发布于 2025-03-29 14:32・IP 属地浙江