何恺明有机会拿图灵奖吗?

- 167 个点赞 👍

2019 年提出这个时可以被归为行为艺术,根本不值得回答。

2023 年再次审视时已经不那么行为艺术了。下面时写于2023年三月的认真回答,不再修改,立贴为证。

恺明非常有机会在二十年内拿到图灵奖,但并不是板上钉钉。以下几点是变数。

- 一定一定要保持身体健康。图灵奖不会发给已经过世的人 (此处向孙剑博士默哀五分钟)。近二十年图灵奖有严重老龄化,终身成就奖化的趋势。Alfred Aho 2020 年得奖时已经 79 岁了。即使成就瞩目也要有耐心慢慢熬。

- 如果恺明能加入 MIT 这样的名校当教授并保持稳定输出,将极大程度增加得奖概率,加快得奖速度。图灵奖的评委多数在大学里,图灵奖历史获奖者里大学教授占压倒多数。

- 避免结仇,避免卷入丑闻。

- 历史上图灵奖相对更青睐做理论研究的学者,但这种趋势未来会逐渐改变。做自己喜欢并擅长的事就好,没有必要刻意去迎合评委的口味。

发布于 2023-03-13 11:19・IP 属地美国查看全文>>

高德纳 - 150 个点赞 👍

第一点,我觉得何的resnet竞争不过transformer。

最主要的原因,resnet看上去工作量不太够,工作量难以支撑起图灵奖。而transformer,和cnn的关系,如同英伟达显卡和amd显卡的关系,而cnn的作者已经拿过图灵奖了。如今最火出圈的两个作品,stable diffusion(扩散模型)和chatgpt,都用到了transformer的技术。

第二点,没准何恺明可以和transformer之父联手拿图灵奖。

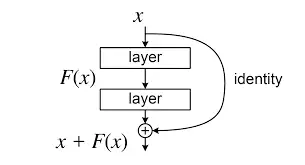

首先,transformer本身就用到了跳跃连接。其次,现在的模型和之前的模型相比,无非就只有两处提升:结构更加先进,大小更加庞大。和早期的cnn相比,transformer代表了更加先进的结构;正是有,也必须有何的跳跃连接,模型规模才能越做越大。何和transformer能联手拿奖,则概括了模型近年的发展

声明

- 有人说stable diffusion里面没有transformer,如图,橙色方块:

2. 我不是说transformer或者resnet有多好,我只是说这两个工作影响力足够大。现在transformer引用68k,resnet引用160k。之所以我更看好trasnformer,是因为resnet看上去实在过于简单。我觉得resnet拿图灵奖没戏,没有"基本"。在我这里最好的结果就是,resnet跟其他作品一起拿奖。

编辑于 2023-03-21 18:37・IP 属地安徽查看全文>>

SuperMouseman - 43 个点赞 👍

引用数量不能表明一切,何恺明唯一长期保持着影响力的工作就是Resnet,离图灵奖还是有点远了

去雾和fast R-CNN已经没人用了,MoCo和MAE被CLIP压制着,也就Resnet一颗常青树。

我发现了一件事

重视目前的工业落地的人会更重视He的成就,喜欢把AGI/zero-shot当作目标的会相对轻视一些

可能这就是道不同吧

编辑于 2023-08-03 19:22・IP 属地浙江查看全文>>

可爱AI - 8 个点赞 👍

有的。

这些奖都是投票出来的。

他去麻省理工教书,每年申请多一些经费,培养多一些学生。

学生也培养更多学生。

另外注意养生。

最后整个人工智能界都是他的徒子徒孙。

大家投票让他拿图灵奖就可以了。

发布于 2023-04-11 13:23・IP 属地广东查看全文>>

babyquant - 2 个点赞 👍

有机会,但是这十来年不一定。

Deep Residual Learning for Image Recognition

这篇文章提到的ResNet结构,并不多是少有的从CNN时代穿透到Transformer,甚至到RWKV,Mamba等变种的基础模型的架构设计。

它可以认为是 Backward Propagation级别的设计,没有它,现阶段的任何一个神经网络可能都过不了二十层。

可以这么说:

FFN 代表了知识

QKV代表了查询知识

而 ResNet就是信息流通的通道,从QKV到FFN必须要有ResNet才能完成信息的流通!

尽管它实在是太简单了,但是它足够的优秀不是吗?

发布于 2025-03-29 14:32・IP 属地浙江查看全文>>

亚东