deepseek本地部署满血复活版到底需要多少块h100才能达到类似豆包的丝滑沟通?

- 11 个点赞 👍

想知道需要什么显卡、需要多少张显卡,核心在于计算显存占用问题。想要丝滑流畅,你要保证完整加载整个模型权重,并预留一定的空间给KV-cache。你输入的上下文越长,占用额外的推理开销就会越大,KV-cache也就越大。

直接说答案,丝滑体验需要10张H100。

Deepseek V3和R1都是671B参数。在FP8下,1B参数 = 1GB显存。所以你要671GB显存。已知H100的显存单张是80GB。仅仅需要加载权重就需要9张H100了。通常想实现128K上下文,额外预留20%的显存作为推理开销,那就是805GB,那就得10张H100,凑出800GB显存。

当然,如果把题目当中的丝滑二字给去掉,也有一些野路子。由于Deepseek V3是MoE架构,每一次运行的时候并不会激活全部671B的参数,而是只激活39B。所以理论上你也可以只有39GB的显存,每次运行的时候从硬盘或者内存当中把需要的参数给加载到显存里面。这样算一张H100就够用了,80GB显存>39GB了。

这样的体验就不会丝滑,

查看全文>>

chengxd 达达 - 6 个点赞 👍

满血复活版是哪个版???没用过

不过1.5b的那个真不咋样,跟人工智障差不多

然后70b的完全带不起来….感觉70b少说也给4090才带的动,反应慢的像砸电脑。

就搞不懂怎么那么多人吹deepseek给英伟达当头一棒的…这玩意没好显卡完全玩不了!!

查看全文>>

一方通行kuma - 5 个点赞 👍

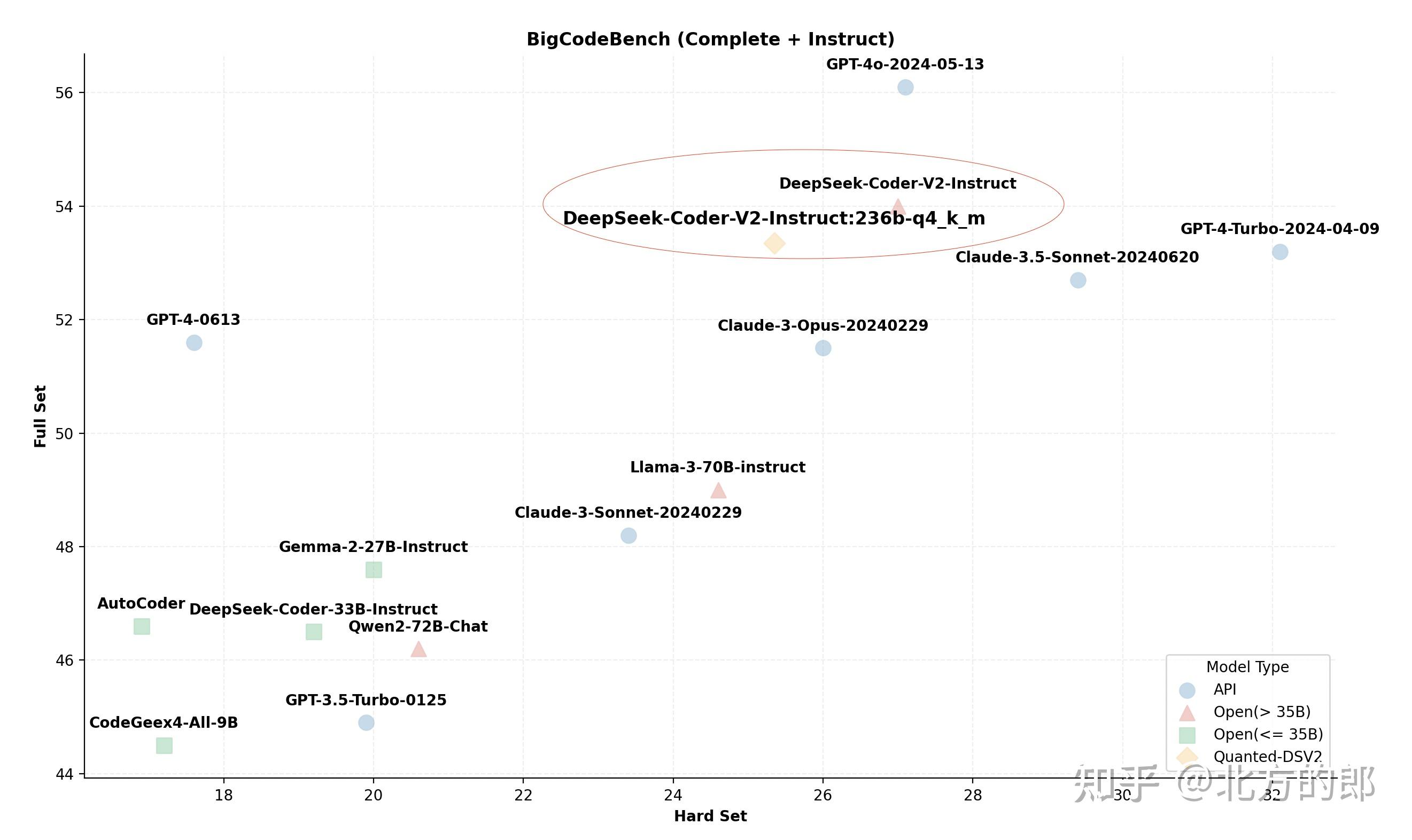

最新资料是:4090+382GB内存就可以运行满血DeepSeek-Coder-V3/R1模型的Q4_K_M

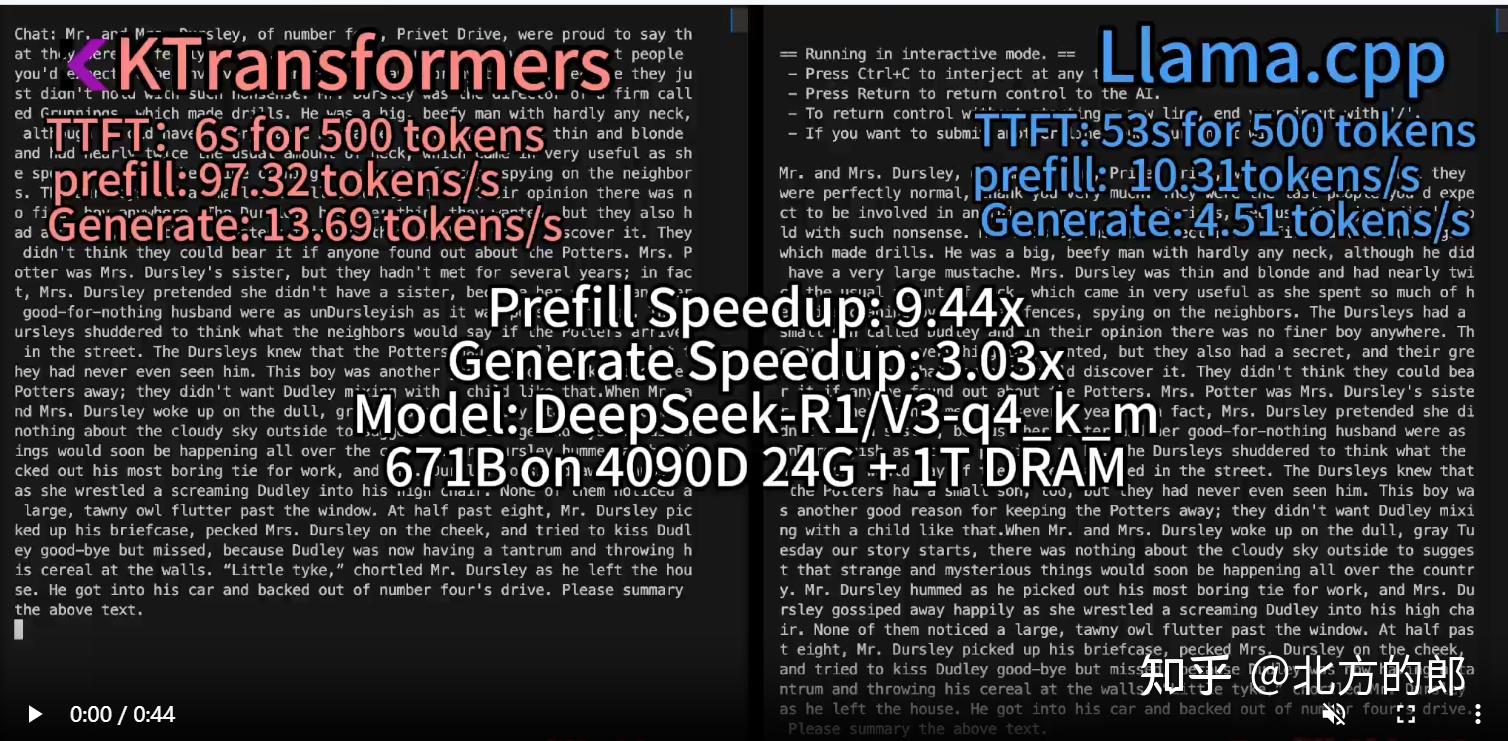

2025年2月10日,KTransformers团队(之前以本地CPU/GPU混合推理开源项目DeepSeek-V2而闻名)发布了一项新的技术成果,宣布支持DeepSeek-R1/V3模型,并展示了其在本地运行时的卓越性能。通过使用仅24GB显存和382GB内存的配置,他们成功运行了DeepSeek-Coder-V3/R1模型的Q4_K_M版本,并实现了高达3~28倍的速度提升。

GitHub:https://github.com/kvcache-ai/ktransformers

发布博客:https://github.com/kvcache-ai/ktransformers/blob/main/doc/en/DeepseekR1_V3_tutorial.md

性能亮点

- 预填充速度(Prefill Speed, tokens/s):

- KTransfermor: 单路(32核)为54.21 → 双路(64核)为74.362 → 使用Intel AMX优化的MoE内核(V0.3版)为255.26 → 选择性激活6个专家(V0.3版)为286.55。

- 相较于llama.cpp在双路配置下的10.31 tokens/s,KTransfermor实现了最高27.79倍的速度提升。

- 解码速度(Decode Speed, tokens/s):

- KTransfermor: 单路(32核)为8.73 → 双路(64核)为11.26 → 选择性激活6个专家(V0.3版)为13.69。

- 相较于llama.cpp在双路配置下的4.51 tokens/s,KTransfermor实现了最高3.03倍的速度提升。

技术优化

团队通过以下两项关键技术实现了性能飞跃:

- Intel AMX指令集加速: 针对Intel CPU的AMX指令集进行了深度优化,使计算效率远超现有的llama.cpp实现。

- 专家选择策略: 基于离线分析结果,减少了推理过程中激活的专家数量,从而显著提升了速度,同时保持输出质量不变。

版本对比

- V0.2版: 支持DeepseekV3-q4km(int4量化),需要至少14GB显存和382GB内存。

- V0.3-Preview版: 支持DeepseekV3-BF16模型,并通过在线量化适配CPU(int8)和GPU(int4)。预填充速度比V0.2版快3.45倍,比llama.cpp快27.79倍。

详见:北方的郎:突破大模型推理极限:1张4090跑满血671B的DeepSeek-V3/R1大模型!

——完——

@北方的郎 · 专注模型与代码

喜欢的朋友,欢迎赞同、关注、分享三连 ^O^

查看全文>>

北方的郎