Deepseek R1的版本更新,我大概昨天下午就感觉到了,最近在跑一个任务,同样的提示词,前天的r1和昨天判若两ai。我和朋友的原话是——

今天的r1,(*)话怎么长了好几倍?

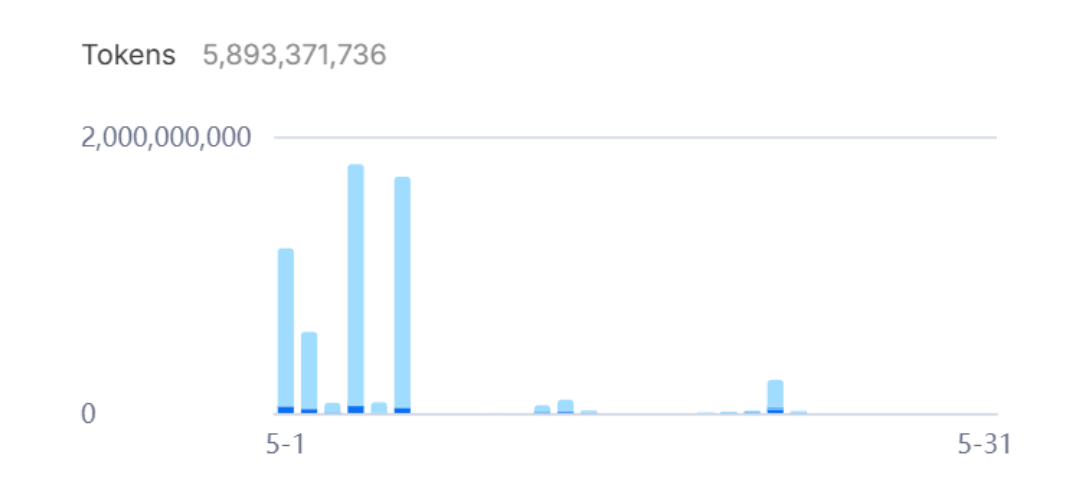

先叠个甲,R1是我用得最多,花钱最多的api。可以看下面的截图,这个月已经消费了60亿token。

进入主题,我们来看看原本deepseek-r1和新版的变化。

在数据质量上,我有一个简单的测试任务,可以在我的github里下载到:

这个任务是在去年这篇文章的基础上修改的,目的是让o3、gemini、claude 4和deepseek r1等模型同时完成一个写论文的任务。

今年加入了更长的流程,要求大模型完成这几个环环相扣的工作:

1)阅读一个数据的结构和给定的研究想法,找到合适的数据和研究切入点;

2)根据研究想法和所选的数据,设置合理的研究方案和最终使用的数据变量;

3)根据数据和上一步生成的研究方案,撰写一系列的统计分析和作图代码,并且在遇到错误时还会自己修改。

4)根据统计分析的结果进行研究文章的撰写。

大家可以下载数据以及代码以后,在本地设置好各类环境变量,便可以自行测试。

这个任务对于大模型的考验还是比较大的,它需要在开脑洞和实现能力上取得平衡,而且每一步的幻觉需要尽可能少,比如在第一步,输入的codebook长达690行,必须从里面跳出这项研究需要的变量,一个字都不能错。第三步,要根据大模型自己生成的研究方案和数据撰写代码,这个代码也不能有问题,所以如果第一步开了脑洞想出了一个不可能完成的任务,那么第三步自然写不出可以成功实现的代码。

这样一个一键生成论文的代码,在o3、gemini和claude 4这里,大概是这样的:

o3——80%左右的成功率,o3喜欢在第一步使用很复杂的计量方法,而且在大多数时候都能真正实现,但还有20%的概率它实现不了,主要是它想出来了一个很难的依赖包,而我没有安装这个依赖包;或者是想出来了一个很复杂的实现,但是这个实现用python做不到。但只要写出文章来,o3的洞见肯定是最深的,速度也很快,大概两分钟可以写完一篇文章。但是它每运行一次耗费1美元。

gemini 2.5——90%左右的成功率,gemini的计量方法选择相对平实,但是喜欢用很多变量一起交互,变量一多,最后能运行的数据量就少,它在测试中唯一一次失败一般出现在这里,选了一大堆变量,最后有效数据是0,所以在回归分析时运行了一个空气。gemini的深度没有o3那么深,但是写的字数很多,比较面面俱到。

claude——100%,我运行了大概十个研究主题,没有一次不成功的。而且claude 4 opus画图特别好看,它每次画出来的图在美观程度上都远超其他几个模型。但是claude对数据研究分析最浅,做出来的分析和画出来的图常常是我不需要做也能想出来的。

这是顶尖三家大模型的情况。而deepseek_r1在昨天更新之前,运行这个脚本的成功率是——0%

没有一次可以跑出文章,因为昨天之前的deepseek_r1在给自己撰写研究方案的时候,就已经开始天马行空了,想出来一个不存在的变量,或者是一个不可能实现的方法,于是第三步写代码的时候,没有一次成功画出图或者做出成功的回归分析来。

但在昨天升级之后,deepseek_r1的成功率大幅度上升到了50%。我只运行了两次,它就成功了一次,说明它在脑洞终于闭合了,不会写出不可能实现的方案,代码成功率也比以前高了很多。

大家可以在我的gitub中找到我让它们用“”我想研究决定收入高低的因素都有哪些?“”这样的研究主题生成的四篇文章,看一下他们各自选择的变量和方法以及结论。

但可能有人要问,为什么不多测试几次deepseek呢?

很简单,新的Deepseek_r1,太慢了……

生成一篇文章,o3耗时3分钟,gemini耗时5分钟,claude 4耗时4分钟。

新deepseek r1,耗时23分钟。

这也是在本轮deepseek-r1后可能产生的一个副作用,由于reasoning_content加长了好几倍(价格直接上升好几倍),速度慢了很多(差不多只有之前的20%),但质量和o3,稳定性和claude的差距却依然存在(虽然缩小了),导致deepseek的比较优势反而下降了。

之前的工作流中,已经形成了这样的惯例——最难的项目找o3、最长的文本找gemini、最需要稳定的流程找claude,最需要又快又好的生产线操作找deepseek。

但是在改版后,o3、gemini和claude的比较优势没有变,deepseek自己的优势却减少了,此时需要又快又好的生产线操作,可能就会去找qwen3-235b进行进一步评估。

原本deepseek-r1的速度和价格优势把一切本地部署的尝试都打趴下,能在质量基本不落后太多的同时,达到顶尖模型5%以内的价格。在半夜进行,充分利用缓存击中,可以同时做到200个并发,速度极快。

这种速度和价格的优势是其他模型完全不能比的。

但改版后的价格上升和速度下降后,本地部署其他模型就成了一个可以讨论的选项。

大模型就是这样残酷,只有某个领域的第一名才会被使用到,第二名往后,只在榜单上可能引起欢呼,在商业使用上就是个屁。

之前的deepseek虽然质量不是第一名,但是脑洞、速度、价格都是毫无争议的第一名,脑洞大,在很多场景不是一个劣势,速度和价格就更加如此了。因此,虽然原版R1的质量没有达到第一名的水平,却值得用户在它身上花最多的钱。而r1-0528还能在这几个方面都断崖式领先qwen3吗?存在疑问。

再怎么改版,都尽量不要做一个门门都排第二的模型,如果要权衡,也至少在某一个领域保持第一名,优势才能持续下去。