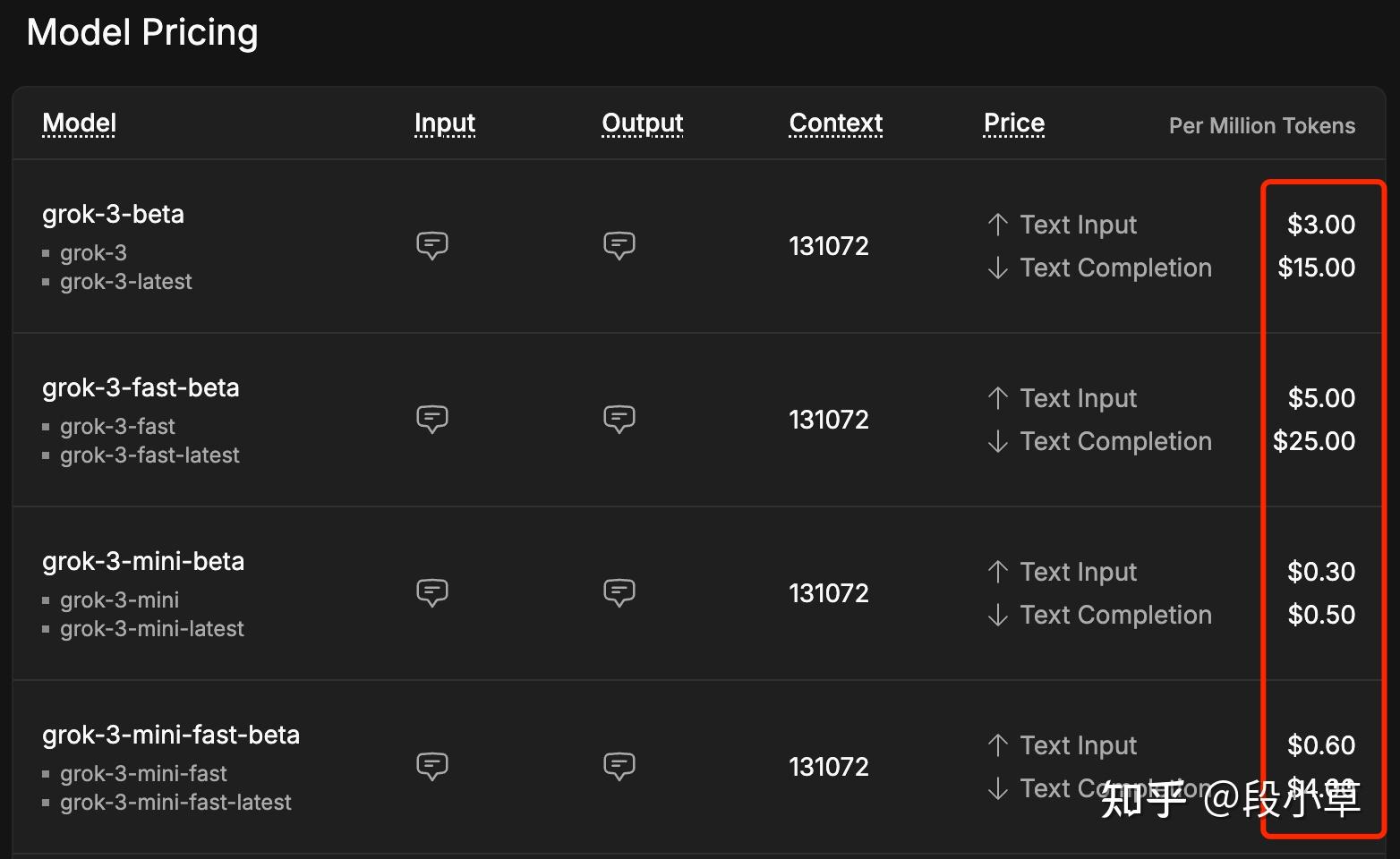

今天 xAI 终于面向普通用户开放 Grok 3 API 了,第一时间来体验一下。首先这次 API 增加了两款模型,分别是 Grok 3 和 Grok 3 mini,两款模型分别有默认和快速模式,价格如下[1]:

官方对「快速模式」的介绍是:「可以降低延迟并缩短首个 token 的生成时间」,但我实际测试下来,fast mode 的效果并不明显,所以建议大家直接用普通版就好。

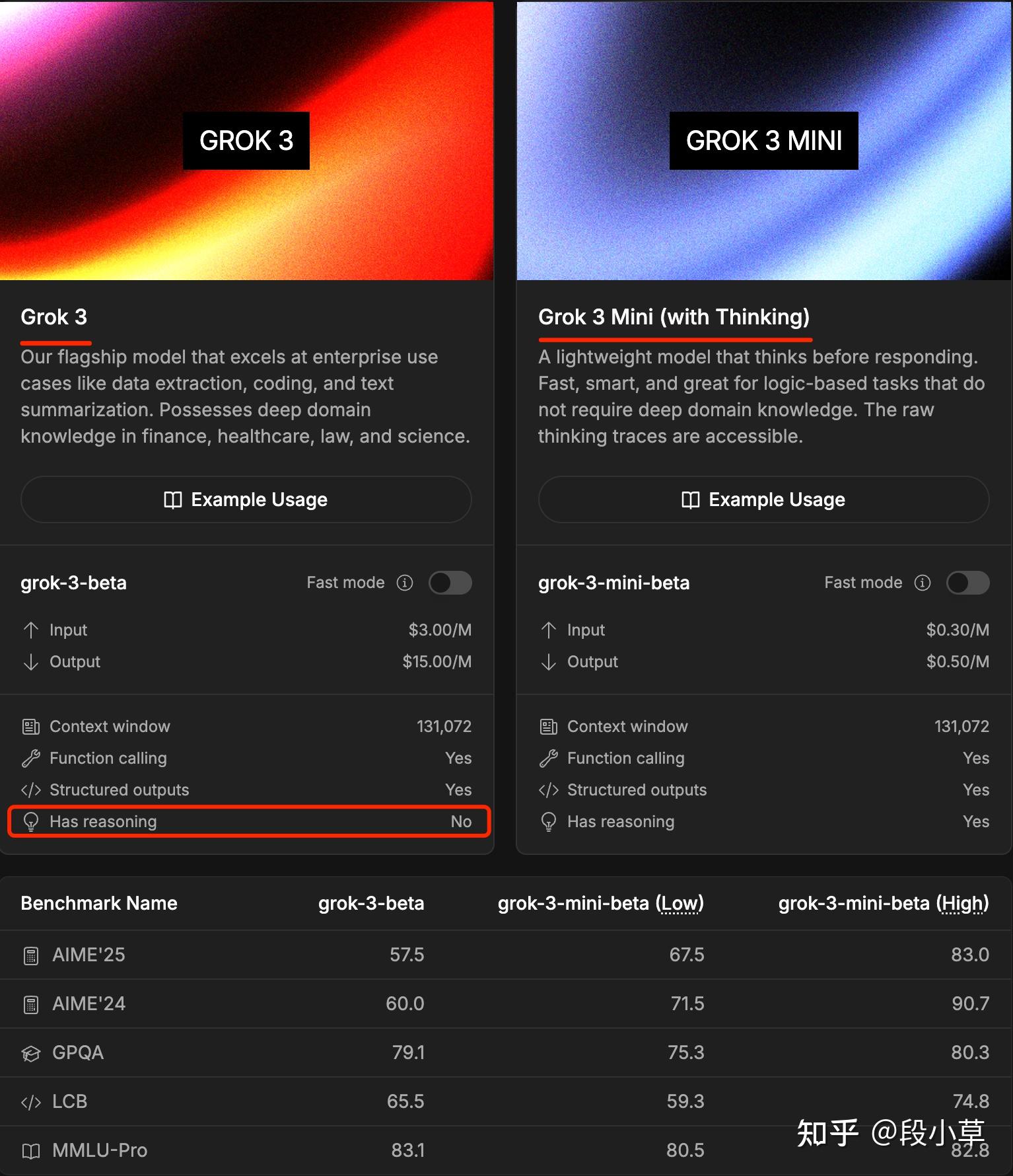

Grok API 和其他家的不同之处还在于,Grok 3 是没有推理功能的,而 mini 默认有推理能力(这一点很容易会造成误解):

Grok 3 是旗舰模型,擅长企业级应用场景,如数据提取、编程和文本摘要。在金融、医疗、法律和科学领域具备深厚的专业知识。

Grok 3 mini 是一款轻量级模型,在回应前会进行思考。快速、智能,适合不需要深厚领域知识的逻辑型任务。原始思考过程可被查看。

那么是不是 Grok 3 一定比 Grok 3 mini 能力强分数高呢?似乎也不是。根据官方给出的部分测评分数可以看出,Grok 3 mini high 几乎全部强于 Grok 3:

所以我一直说,现在选模型还真不是无脑选大的选贵的(比如 GPT-4.5),要根据自己的实际需求做了测试再说。

接下来测一下接口响应的速度:

【grok-3-latest】

首 token 响应时间: 1.49 秒

内容生成:717 字符,479 tokens, 总用时:9.64 秒, 生成速度:49.71 tokens/s

如计入首 token 用时, 总用时:11.12 秒, 生成速度:43.06 tokens/s

【grok-3-fast-latest】

首 token 响应时间: 1.59 秒

内容生成:633 字符,431 tokens, 总用时:9.06 秒, 生成速度:47.57 tokens/s

如计入首 token 用时, 总用时:10.65 秒, 生成速度:40.45 tokens/s

【grok-3-mini-latest: low】

首 token 响应时间: 1.18 秒

Reasoning 部分:754 字符,455 tokens, 用时:2.41 秒, 生成速度:188.73 tokens/s

Content 部分:962 字符,635 tokens, 用时:3.37 秒, 生成速度:188.68 tokens/s

内容生成:1716 字符,1090 tokens, 总用时:5.78 秒, 生成速度:188.65 tokens/s

如计入首 token 用时, 总用时:6.96 秒, 生成速度:156.57 tokens/s

【grok-3-mini-latest: medium】

首 token 响应时间: 2.23 秒

Reasoning 部分:583 字符,360 tokens, 用时:1.89 秒, 生成速度:190.58 tokens/s

Content 部分:920 字符,606 tokens, 用时:3.19 秒, 生成速度:189.82 tokens/s

内容生成:1503 字符,966 tokens, 总用时:5.13 秒, 生成速度:188.28 tokens/s

如计入首 token 用时, 总用时:7.36 秒, 生成速度:131.26 tokens/s

【grok-3-mini-latest: high】

首 token 响应时间: 1.14 秒

Reasoning 部分:958 字符,511 tokens, 用时:2.70 秒, 生成速度:189.36 tokens/s

Content 部分:679 字符,443 tokens, 用时:2.37 秒, 生成速度:186.90 tokens/s

内容生成:1637 字符,954 tokens, 总用时:5.07 秒, 生成速度:188.16 tokens/s

如计入首 token 用时, 总用时:6.21 秒, 生成速度:153.57 tokens/s

【grok-3-mini-fast-latest: medium】

首 token 响应时间: 1.21 秒

Reasoning 部分:723 字符,423 tokens, 用时:2.27 秒, 生成速度:186.09 tokens/s

Content 部分:794 字符,522 tokens, 用时:2.78 秒, 生成速度:187.84 tokens/s

内容生成:1517 字符,945 tokens, 总用时:5.06 秒, 生成速度:186.91 tokens/s

如计入首 token 用时, 总用时:6.26 秒, 生成速度:150.91 tokens/s作为对比,顺便测试 Grok 2 的接口速度:

【grok-2-latest】

首 token 响应时间: 1.32 秒

内容生成:620 字符,465 tokens, 总用时:7.77 秒, 生成速度:59.88 tokens/s

如计入首 token 用时, 总用时:9.08 秒, 生成速度:51.20 tokens/s怎么说呢,两点感觉:

- Grok 3 API 现在的响应速度挺好的,fast 模式纯冤大头,花了几倍的价格体验上没差别,当然也可能后期业务繁忙后会优先保障 fast 接口,但至少目前意义不大。

- Grok 3 能跑到接近 50 tps,Grok 3 mini 能接近 190 tps(这有点太夸张)。

- Grok 3 mini 的三个 reasoning effort(low、medium、high)[2]似乎差别并不大,考虑到 0.3/0.5 的价格,无脑 high 也能接受。

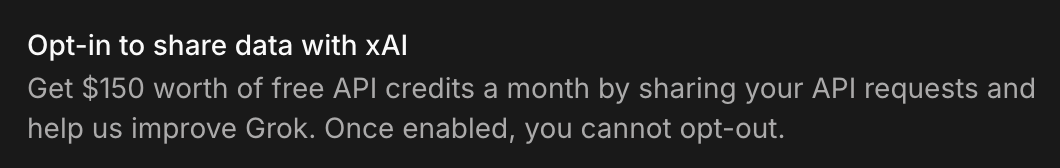

最后就是价格问题了,老马还真是圣人,只要充 5 刀到账号里,然后加入「数据共享计划」[3],每月就送 150 刀的额度。

150 刀的额度,就算全用 Grok 3,也能用 2500 万 tokens 了(按输入输出 3:1 估算),如果全用 Grok 3 mini…算不过来了,反正不可能用完就是了。

所以如果用于不考虑数据隐私的场景(比如网页翻译),白嫖 Grok 3 API 也许会是不错的选择。

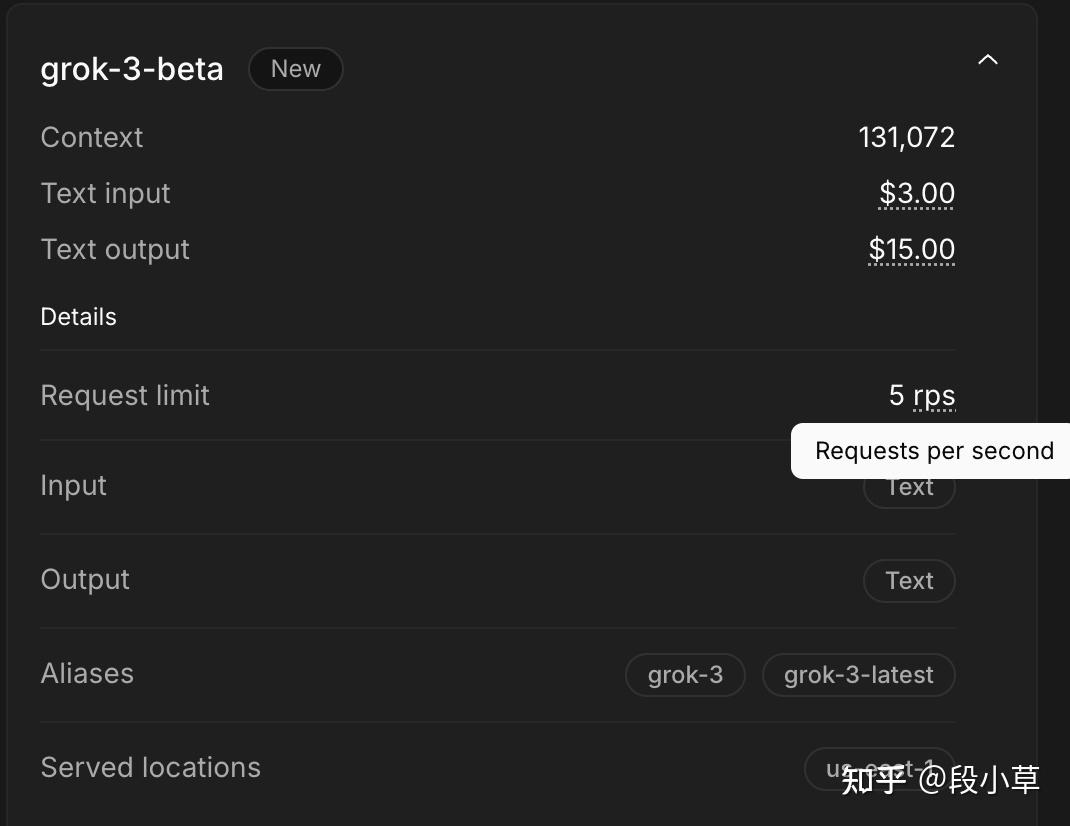

顺便,Grok 3 现在的并发限制都是 5 rps,每秒 5 次,够用了:

哦对了,补充一下,Grok API 很奇怪,他们虽然支持 OpenAI compatible 接口,但对一些具体的字段有自己的想法。

比如统计 tokens 数量时,有几个值:

- completion_tokens

- prompt_tokens

- total_tokens

- reasoning_tokens

OpenAI 的数值里,total_tokens = prompt_tokens + completion_tokens,reasoning_tokens 是 completion_tokens 的一部分。

而在 Grok 的返回值里,reasoning_tokens 是推理部分,completion_tokens 是回答部分,total_tokens = prompt_tokens + reasoning_tokens + completion_tokens。

只能说 Grok 对 API 有着自己的理解:)

另,根据评论区反馈,Grok 3 API 疑似降智。大家还是实测一下表现,如果实锤降智厉害的话,那再便宜也失去了价值。