因为服务器快被刷爆了。。。

本地部署DeepSeek-R1的确可以解决服务器繁忙的问题,但效果嘛。。只能说一言难尽。。。

毕竟就算你的显存有24个G,能部署的也只是DeepSeek 14B的版本,跟官方671B的版本比起来,不说天壤之别,也是欺负幼儿园小朋友了。。。

不同模型大小的部署要求

| 模型大小 | 显存需求(FP16 推理) | 显存需求(INT8 推理) | 推荐显卡 | MacOS 需要的 RAM |

|---|---|---|---|---|

| 1.5b | 3GB | 2GB | RTX 2060/MacGPU 可运行 | 8GB |

| 7b | 14GB | 10GB | RTX 3060 12GB/4070 Ti | 16GB |

| 8b | 16GB | 12GB | RTX 4070/MacGPU 高效运行 | 16GB |

| 14b | 28GB | 20GB | RTX 4090/A100-40G | 32GB |

| 32b | 64GB | 48GB | A100-80G/2xRTX4090 | 64GB |

更何况,很多人在第一步就被劝退了“GitHub无法访问。。。”、“命令终端从哪打开。。”

无需本地部署的稳定访问新方法

今天,教大家一个新方法,让你不需本地部署,也能稳定访问DeepSeek。

方法也简单,就是通过第三方应用,调用DeepSeek的API,实现稳定访问。

可能有人要说,调用API不是要收费吗?而且就要恢复原价了。。。

虽说我认为,收费这事DeepSeek已经很良心了,但本着能省一文是一文的原则,有没有更便宜的渠道呢?

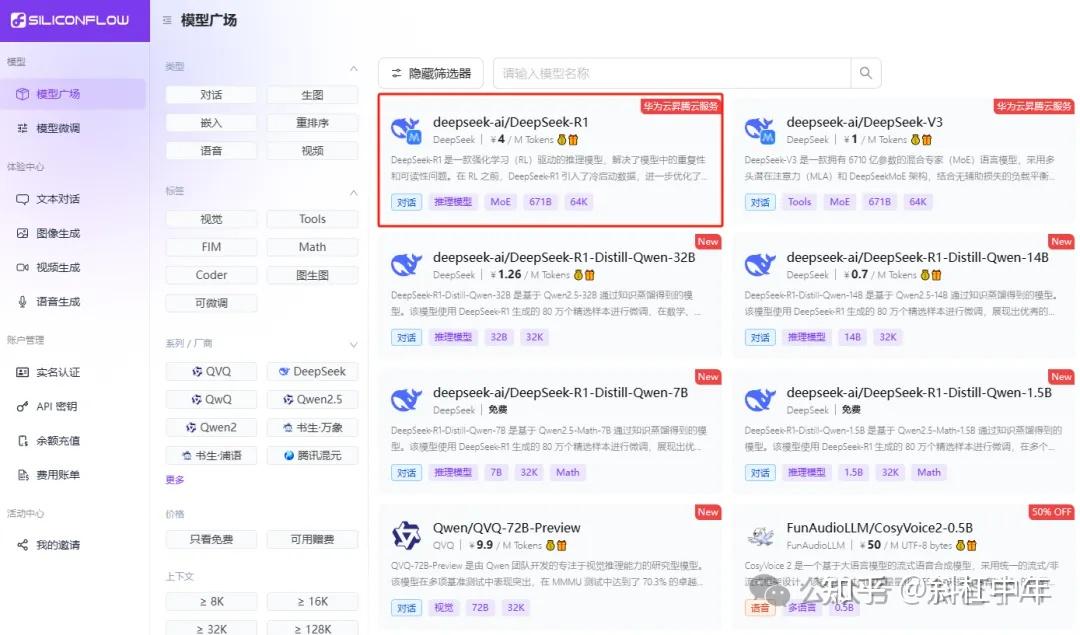

还真有!通过硅基流动的API入口可以调用DeepSeek的全部模型

重点是,现在注册就送2000万Tokens,相当于让你免费用AI做100个项目,四舍五入就是不要钱啊。。。

划重点

- 现在点我的专属链接注册

- 咱俩都能白嫖2000万Tokens(够你玩到爽)

- 下载开源软件CherryStudio就能开启使用。

推荐理由

- 流畅体验:服务器与华为云合作,使用体验丝滑流畅,彻底告别服务器无响应的痛苦。

- 多端便捷:手机、平板、电脑都能访问,随时随地调用AI,方便快捷。

- 服务稳定:企业级服务不宕机,不用担心用着用着数据丢失。

手把手教程

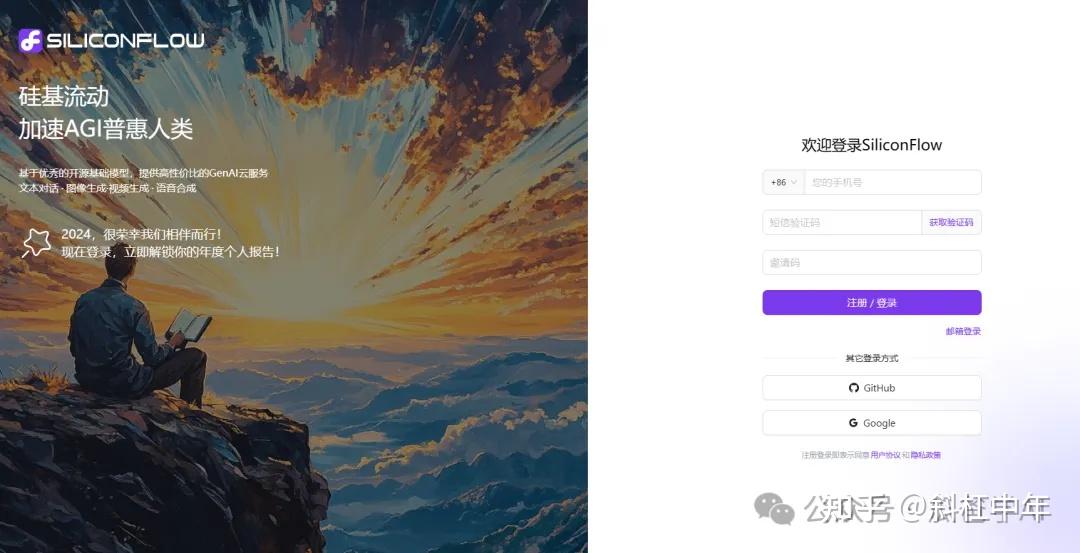

注册硅基流动账号

点击这里,只需一个手机号就能轻松注册

模型广场中就有DeepSeek R1模型

每邀请一位好友成为硅基流动新用户,您与好友均可获赠2000万Tokens(14元平台配额)。余额充值中有14元表示领取成功。

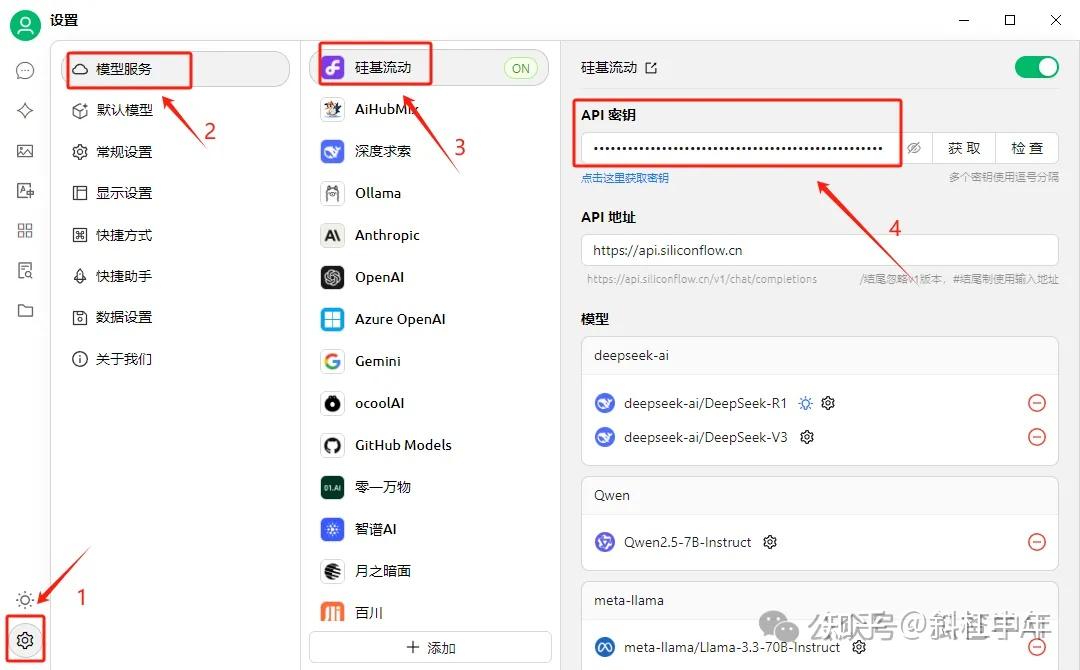

新建硅基流动API

点击API密钥》》新建API密钥,即可生成新的密钥

下载CherryStudio客户端(电脑版)

CherryStudio官网:https://cherry-ai.com/

点击下载客户端,安装完成后点击左下角设置》》模型服务》》选择硅基流动,复制刚刚新建的API密钥,OK搞定!

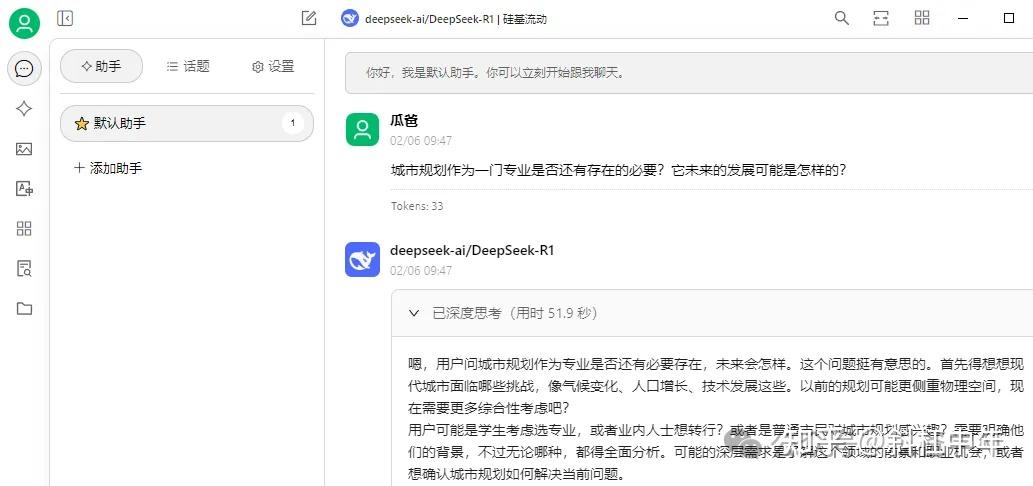

就可以正常对话了,是不是很简单